- Rynek układów przyspieszających AI ma wzrosnąć z 28,5 mld USD w 2024 roku do ponad 360 mld USD do 2032 roku, CAGR 37,4%.

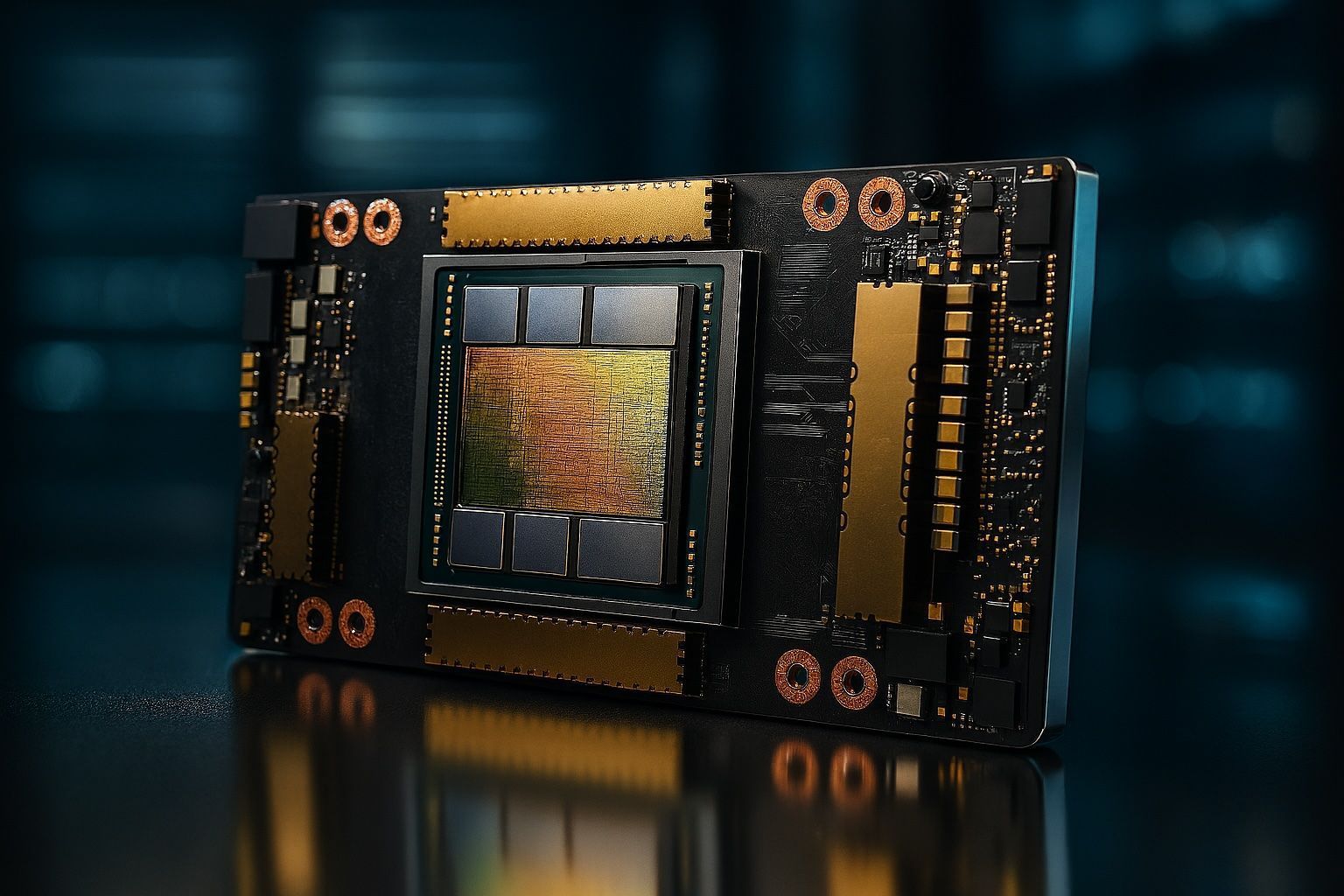

- NVIDIA ma około 80% udziału w rynku sprzętu akceleratorów AI w centrach danych, a trening GPT-4 podobno wymagał 25 000 GPU NVIDIA pracujących przez miesiące.

- W 2024 roku centra danych w chmurze odpowiadały za około 75% zapotrzebowania na układy AI, podczas gdy edge computing notuje ponad 40% rocznego wzrostu.

- TSMC planuje rozpocząć produkcję wafli 2nm w 2025 roku, wykorzystując nanosheet (GAAFET) do większej gęstości i efektywności.

- Chiny traktują chipy AI jako priorytet strategiczny: do 2025 roku dążą do samowystarczalności produkcyjnej 70% używanych chipów, a do 2030 roku mogą odpowiadać za prawie jedną trzecią światowego popytu na chipy AI; do 2023 roku zarejestrowano ponad 1200 firm zajmujących chipy AI.

- EU Chips Act z 2023 roku przeznacza 43 mld euro na suwerenność półprzewodnikową i celuje w 20% udziału Europy w globalnej produkcji chipów do 2030 roku; Intel planuje inwestycje do 30 mld euro w fabryki w Niemczech i Irlandii, a TSMC ma zbudować fabrykę w Niemczech.

- Loop Capital ocenia rynek AI silicon na 2 biliony USD do 2028 roku.

- Cerebras Systems opracowało wafer-scale engine z 850 tysiącami rdzeni, a Graphcore prowadzi architekturę IPU z wysoką przepustowością pamięci.

- Google używa TPU v4 w Google Cloud, łączy ponad 4000 chipów TPU v4 w klastrze połączonym ultrawiązką siecią optyczną mesh, a edge TPU (Coral) działa na urządzeniach mobilnych.

- Do 2030 roku oczekuje się 2–3× wzrostu wydajności na wat co 1,5–2 lata dzięki postępom w procesach 3nm/2nm, chipletom i nowym architektom, co umożliwi zastosowania AI w większej liczbie urządzeń.

Wprowadzenie: Eksplozja sztucznej inteligencji wywołała bezprecedensową gorączkę złota na układy przyspieszające AI – wyspecjalizowane procesory napędzające wszystko, od chatbotów po samochody autonomiczne. W miarę jak modele AI stają się coraz bardziej złożone i wszechobecne, gwałtownie rośnie zapotrzebowanie na GPU, TPU, NPU, ASIC, FPGA i inne niestandardowe układy scalone zoptymalizowane pod kątem obciążeń AI. To napędza zaciekły globalny wyścig zarówno wśród gigantów technologicznych, jak i startupów, aby zdominować rynek, którego wartość do 2030 roku ma sięgnąć setek miliardów dolarów nextmsc.com fingerlakes1.com. Ameryka Północna, Chiny, Europa i inne regiony intensywnie inwestują w możliwości produkcji chipów AI, postrzegając je jako infrastrukturę strategiczną dla przywództwa gospodarczego i technologicznego. Niniejszy raport przedstawia kompleksową analizę rynku na lata 2025–2030 – obejmującą głównych graczy (NVIDIA, AMD, Intel, Google, Amazon, Apple, Alibaba, Huawei, Graphcore, Cerebras, Tenstorrent i innych), kluczowe regiony, zastosowania od chmur obliczeniowych po urządzenia brzegowe, a także czynniki napędzające rynek, wyzwania, trendy technologiczne, aspekty regulacyjne oraz prognozy finansowe (TAM, CAGR, podziały segmentów). Era akceleratorów AI już nadeszła, a stawka w wyścigu o dostarczanie „mózgów” dla naszej przyszłości opartej na AI nie mogła być wyższa.

Przegląd rynku i prognoza wzrostu (2025–2030)

Rynek układów przyspieszających AI ma wzrosnąć z 28,5 mld USD w 2024 roku do ponad 360 mld USD do 2032 roku, rosnąc w zawrotnym tempie CAGR 37,4% globenewswire.com.

Globalny rynek układów przyspieszających AI wchodzi w fazę eksplozji wzrostu. Prognozy branżowe są zgodne co do oczekiwań dwu- lub nawet trzycyfrowych miliardowych przychodów do końca dekady. Na przykład, Next Move Strategy Consulting szacuje rynek układów AI na około 52,9 mld dolarów w 2024 roku, rosnący do 295,6 mld dolarów do 2030 roku (33,2% CAGR) nextmsc.com. Podobnie, Grand View Research prognozuje około 305 mld dolarów do 2030 roku (około 29% CAGR) techstrong.ai. Niektórzy analitycy z Wall Street są jeszcze bardziej optymistyczni – Bank of America przewiduje, że rynek akceleratorów AI może osiągnąć 650 mld dolarów rocznych przychodów do 2030 roku, co oznacza ponad trzykrotny wzrost z ~200 mld dolarów w 2025 roku fingerlakes1.com. Choć szacunki się różnią, panuje konsensus, że roczny wzrost na poziomie 25–35%+ znacznie przewyższy szerszy rynek półprzewodników wraz z przyspieszającą adopcją AI.

Napędza tę wykładniczą ekspansję nienasycony apetyt obliczeniowy współczesnej AI. Każda nowa generacja modeli (np. duże modele językowe i generatywna AI) wymaga większej mocy przetwarzania równoległego, przepustowości pamięci i efektywności energetycznej, niż mogą zapewnić tradycyjne CPU. To sprawiło, że wyspecjalizowane akceleratory stały się niezbędne do trenowania i wnioskowania AI. Jak podsumowuje jeden z raportów: „Wzrost rynku układów przyspieszających AI napędzany jest rosnącym zapotrzebowaniem na generatywną AI, edge computing i energooszczędne układy, z innowacjami liderów takich jak Nvidia i Google.” globenewswire.com. Innymi słowy, rosnące zastosowania – od trenowania ogromnych modeli w stylu GPT w chmurze po uruchamianie AI w czasie rzeczywistym na smartfonach i czujnikach na brzegu sieci – napędzają masową falę modernizacji sprzętu.

W szczególności, podział segmentów ujawnia kluczowe dynamiki tego wzrostu. W 2024 roku GPU (procesory graficzne) nadal stanowiły około 35% przychodów z układów akceleratorów AI, dzięki swojej wszechstronności i przewadze jako podstawowe narzędzie uczenia głębokiego globenewswire.com. Jednak dedykowane układy AI ASIC (układy specjalizowane, takie jak Google TPU czy inne NPU) to najszybciej rosnący segment, prognozowany na wzrost o ponad 43% CAGR, ponieważ organizacje poszukują dostosowanych, energooszczędnych układów do specyficznych zadań AI globenewswire.com. Pod względem wdrożeń, chmurowe centra danych obecnie dominują (~75% zapotrzebowania na układy AI), ze względu na wymagania związane z trenowaniem dużych modeli na klastrach akceleratorów globenewswire.com. Jednak edge computing szybko nadrabia zaległości – potrzeby AI na urządzeniach napędzają ponad 40% roczny wzrost układów AI na brzegu sieci globenewswire.com. Według branż, elektronika konsumencka (smartfony, inteligentne urządzenia) stanowiła około 34% wykorzystania układów AI w 2024 roku (poprzez zintegrowane NPU w telefonach itp.), podczas gdy układy AI dla motoryzacji (do autonomicznej jazdy i ADAS) mają być najszybciej rosnącym segmentem – około 42,6% CAGR, wraz z rozwojem możliwości autonomicznej jazdy globenewswire.com globenewswire.com. Regionalnie, Ameryka Północna prowadzi na rynku z udziałem około 44% w 2024 roku – co nie dziwi, biorąc pod uwagę obecność głównych graczy z Doliny Krzemowej – ale region Azji i Pacyfiku (szczególnie Chiny) jest gotowy na najszybszy wzrost (blisko 40% CAGR) dzięki ogromnym inwestycjom w infrastrukturę AI i może znacząco zmniejszyć dystans do 2030 roku globenewswire.com globenewswire.com.

Podsumowując, wszystkie znaki wskazują na wielusetmiliardowy TAM do 2030 roku dla akceleratorów AI. Połączenie gwałtownego wzrostu popytu (wynikającego z ciągle rozszerzających się zastosowań AI) oraz nieustannych postępów technologicznych (mniejsze tranzystory, nowe architektury) prawdopodobnie utrzyma wysoki, dwucyfrowy wzrost w przewidywalnej przyszłości. Następnie przyglądamy się krajobrazowi konkurencyjnemu oraz temu, jak różne regiony i firmy manewrują, by zdobyć ten rozwijający się rynek.

Ameryka Północna: Dominacja Doliny Krzemowej w AI Silicon

Ameryka Północna – na czele ze Stanami Zjednoczonymi – obecnie znajduje się w epicentrum branży chipów AI. Amerykańskie firmy zapoczątkowały rewolucję obliczeń GPU, która umożliwiła współczesny boom AI, i nadal mają ogromną przewagę technologiczną oraz udział w rynku. NVIDIA w szczególności dominuje na tym polu: de facto „pozostaje praktycznie monopolistą w zakresie kluczowej infrastruktury AI” dzięki swoim platformom GPU, „z siłą ustalania cen, kontrolą marż i popytem ze strony każdego hiperskalera oraz rządowych wdrożeń AI na całym świecie.” fingerlakes1.com. GPU NVIDIA do centrów danych (takie jak A100 i H100) stały się domyślnym sprzętem do trenowania najnowocześniejszych modeli AI – do tego stopnia, że pojedyncze trenowanie GPT-4 od OpenAI wymagało podobno 25 000 GPU NVIDIA pracujących przez miesiące research.contrary.com. Nic dziwnego, że NVIDIA cieszy się szacunkowo ponad 80% udziałem w rynku sprzętu akceleratorów AI w centrach danych i odnotowała gwałtowny wzrost wyceny wraz z napływem inwestycji w AI w latach 2023–2025. Firma nieustannie przesuwa granice (np. GPU generacji „Blackwell” i sieci komputerowe), a jej CEO Jensen Huang słynnie porównał boom na AI do „złotej fali”, która wciąż jest na wczesnym etapie fingerlakes1.com fingerlakes1.com.

Dominacja NVIDIA jednak wywołuje silną konkurencję. AMD (Advanced Micro Devices) wyłoniło się jako główny rywal w segmencie wysokowydajnych GPU do AI. Najnowsze akceleratory AMD z serii MI200 i MI300, wyposażone w zaawansowane chiplety 5nm i integrację CPU+GPU, mają na celu zmniejszenie dystansu do NVIDIA zarówno w zadaniach treningowych, jak i inferencyjnych. Dzięki przejęciu Xilinx, AMD zyskało także technologię FPGA, którą można zastosować w adaptacyjnych akceleratorach AI. Główne firmy chmurowe, takie jak Microsoft i Google, zaczęły testować GPU AMD Instinct jako alternatywę w swoich centrach danych. Choć udział AMD w rynku akceleratorów AI pozostaje niewielki, firma agresywnie iteruje i pozycjonuje się jako realne drugie źródło – co zauważają analitycy, którzy nadal widzą NVIDIA „daleko z przodu”, ale konkurenci szykują się do walki fingerlakes1.com.

Tymczasem Intel – od dawna gigant komputerów ogólnego przeznaczenia – gorączkowo stara się zdobyć pozycję na rynku akceleratorów AI. Po kilku nieudanych próbach (np. rezygnacja z chipów AI Nervana), Intel przejął izraelski startup Habana Labs i obecnie oferuje serię procesorów Gaudi do trenowania i wnioskowania AI. Akceleratory Gaudi2 Intela zostały zaadoptowane przez niektórych dostawców chmury (Amazon AWS oferuje instancje oparte na Gaudi) jako tańsza alternatywa dla określonych zadań. Intel pozostaje także liderem w edge AI dzięki swojemu narzędziu OpenVINO oraz dominacji działu Mobileye w chipach wizyjnych do zaawansowanych systemów wspomagania kierowcy (chip EyeQ Mobileye napędza systemy ADAS w wielu samochodach). Jednak Intel napotyka poważne trudności na rynku akceleratorów centrów danych – w 2025 roku pojawiły się nawet doniesienia, że Intel może ograniczyć wysiłki w zakresie dyskretnych GPU AI w obliczu przytłaczającej przewagi NVIDIA mitrade.com. Mimo to, dzięki ogromnym zasobom R&D i „naciskowi na chiplet i zaawansowane pakowanie” jako części swojej strategii, Intela nie można skreślać w dłuższej perspektywie.

Siła Ameryki Północnej wynika także z obecności hiperskalowych gigantów chmurowych oraz dynamicznego ekosystemu startupów. Firmy takie jak Google, Amazon, Meta i Microsoft wzięły sprawy w swoje ręce, projektując własne układy AI na potrzeby wewnętrzne, by obniżyć koszty i zmniejszyć zależność od NVIDIA. Google był tu prekursorem dzięki TPU (Tensor Processing Unit), czyli ASIC zoptymalizowanemu pod operacje sieci neuronowych, wdrażanemu w centrach danych Google od 2015 roku (obecnie TPUv4 i TPUv5). TPU Google osiągnęły znaczącą wydajność na dolar dla zadań takich jak modele językowe i są dostępne w Google Cloud. Amazon Web Services (AWS) również opracował chipy Inferentia i Trainium do wnioskowania i trenowania AI, odpowiednio, by zasilać instancje chmurowe AWS taniej niż GPU dla określonych zadań. Hiperskalerzy będą kontynuować tę strategię „budować czy kupować” – stosując własne ASIC na dużą skalę, gdy to korzystne, ale wciąż kupując gotowe chipy dla uniwersalności, jak zauważa analiza TD Securities tdsecurities.com. W rzeczywistości jedno z badań szacuje, że do 2030 roku około 15% wydatków na akceleratory AI przypadnie na własne chipy firm (wzrost z ~10% obecnie) – rosnąc o ~30% rocznie do ok. 50 mld USD – podczas gdy gotowe układy (GPU od NVIDIA/AMD i innych) podwoją się do prawie 300 mld USD tdsecurities.com.

Region ten może się również pochwalić licznymi startupami produkującymi chipy AI, które rozwijają nowatorskie architektury. Do godnych uwagi przykładów należą Graphcore (pochodzący z Wielkiej Brytanii, ale obecny także w USA) ze swoimi procesorami IPU, Cerebras Systems z rekordowym wafer-scale engine (pojedynczy, ogromny chip wielkości talerza obiadowego do trenowania AI), SambaNova Systems (oferujący systemy AI z rekonfigurowalnymi chipami dataflow), Groq (wyspecjalizowane procesory do inferencji), Mythic (analogowe chipy AI), Hailo (akceleratory edge AI z Izraela) oraz Tenstorrent (z siedzibą w Kanadzie, prowadzony przez słynnego architekta chipów Jima Kellera, projektujący chipy AI oparte na RISC-V). Do tych pretendentów napłynęły ogromne inwestycje venture capital. Od 2016 roku ponad 6 miliardów dolarów zostało zainwestowanych w startupy AI produkujące chipy, takie jak Cambricon, Graphcore, Cerebras, Groq, SambaNova i Habana galileo.ai. Wiele z nich osiągnęło wysokie wyceny typu „jednorożec” – na przykład Graphcore pozyskał ok. 680 mln dolarów i osiągnął wycenę 2,8 mld dolarów w szczytowym momencie research.contrary.com, podczas gdy Lightmatter i Groq w USA każda przekroczyła wycenę 1 mld dolarów research.contrary.com. Ten kwitnący ekosystem startupów w Ameryce Północnej (oraz Europie/Izraelu) podkreśla zarówno ogromną szansę, jak i różnorodność technologiczną – od projektów wafer-scale po obliczenia fotoniczne – gdy przedsiębiorcy próbują przeskoczyć obecnych liderów rynku.Jednak przewaga Ameryki Północnej nie jest niezagrożona. Konkurenci za granicą szybko rosną, a dominacja USA przyciągnęła także geopolityczną uwagę (np. kontrole eksportowe), o czym opowiemy później. Najpierw przyjrzyjmy się równoległym wysiłkom w Chinach, Europie i innych regionach, które starają się zbudować własny potencjał w zakresie chipów AI.

Chiny: Rozwój na dużą skalę mimo ograniczeń

Chiny traktują chipy AI jako kluczowy priorytet strategiczny i zmobilizowały ogromne zasoby, by rozwinąć rodzimy przemysł, zwłaszcza w obliczu zaostrzających się amerykańskich ograniczeń eksportowych. Chińscy giganci technologiczni i startupy opracowują różnorodne akceleratory, by obsłużyć dynamicznie rozwijający się rynek aplikacji AI – od chmur obliczeniowych, przez monitoring, smartfony, po pojazdy autonomiczne. Warto zauważyć, że Alibaba, Tencent, Baidu i Huawei – czasem nazywane „Smokami AI” Chin – w ostatnich latach zaprojektowały własne chipy AI:

- Alibaba zaprezentowała Hanguang 800 NPU w 2019 roku do inferencji AI w swojej chmurze i posiada spółki półprzewodnikowe (takie jak T-Head) produkujące układy SoC zorientowane na AI do chmury i edge.

- Baidu stworzyło akcelerator Kunlun AI, wdrożony zarówno w Baidu Cloud, jak i na edge (np. obsługujący asystentów głosowych Baidu i platformę autonomicznej jazdy). Chip Kunlun 2 Baidu (7 nm) zadebiutował w 2021 roku, oferując konkurencyjną wydajność dla zadań NLP i komputerowego rozpoznawania obrazów.

- Huawei opracowało serię układów AI Ascend (Ascend 910 do trenowania, Ascend 310 do zastosowań brzegowych) jako część szerszej strategii budowy kompleksowych rozwiązań AI. Ascend 910 (7nm) był jednym z najpotężniejszych na świecie układów do trenowania AI w momencie premiery, a Huawei wykorzystuje je w swojej chmurze i sprzęcie AI (takim jak moduły serwerowe Atlas). Dział smartfonów Huawei również zintegrował NPU (Neural Processing Units) w swoich mobilnych SoC Kirin, umożliwiając funkcje AI na urządzeniu – choć amerykańskie sankcje ostatnio ograniczyły możliwości produkcji najnowocześniejszych układów do telefonów.

- Tencent i ByteDance (właściciel TikToka) podobno rozpoczęły projekty projektowania własnych układów AI do wykorzystania w swoich centrach danych, biorąc pod uwagę skalę algorytmów rekomendacji AI i moderacji treści, które obsługują. A SenseTime, czołowy chiński jednorożec AI, również eksperymentował z projektowaniem układów AI, aby zoptymalizować swoje wdrożenia rozpoznawania twarzy.

Poza gigantami, chińskie startupy mnożą się – często przy wsparciu rządu – aby budować rodzime akceleratory AI. Do znanych nazw należą Cambricon Technologies, które zaczynało od dostarczania IP sieci neuronowych do wczesnych NPU Kirin Huawei, a później wprowadziło własną linię procesorów AI (układy Cambricon były używane w serwerach Alibaba i innych). Horizon Robotics koncentruje się na motoryzacyjnych układach AI do systemów wspomagania kierowcy i ma umowy z Volkswagenem oraz chińskimi producentami OEM. Biren Technology zasłynęło opracowaniem zaawansowanego układu AI przypominającego GPU (Biren BR100) produkowanego w TSMC 7nm – mającego rywalizować z NVIDIA A100 – choć ograniczenia eksportowe narzędzi EDA wymusiły pewne obniżenie specyfikacji. Inni gracze, tacy jak Iluvatar, Denglin, Montage, Black Sesame i wielu innych, celują w nisze od trenowania w chmurze po edge AI w IoT. Cały ten ekosystem korzystał z dużego wsparcia rządowego (takiego jak Chiński Narodowy Fundusz Inwestycyjny IC, czasem nazywany „Wielkim Funduszem”, który zainwestował dziesiątki miliardów w półprzewodniki). Według raportów branżowych, ponad 1200 firm zajmujących się układami AI zostało zarejestrowanych w Chinach do 2023 roku, zachęconych hojnymi dotacjami, choć tylko niewielka część osiągnęła zaawansowany etap rozwoju produktów.

Znaczącym wyzwaniem dla chińskich działań w zakresie chipów AI są amerykańskie ograniczenia handlowe dotyczące zaawansowanych półprzewodników. Od 2019 roku rząd USA stopniowo zaostrzał kontrolę eksportu, zakazując firmom takim jak NVIDIA sprzedaży swoich najwyższej klasy GPU (A100, H100) chińskim klientom. W latach 2022 i 2023 nowe przepisy ograniczyły również dostawy do Chin narzędzi do produkcji najnowocześniejszych chipów poniżej ~14 nm przez amerykańskich i sojuszniczych producentów sprzętu bez odpowiednich licencji. Te działania bezpośrednio wpływają na akceleratory AI, ponieważ zaawansowane chipy do trenowania wymagają najnowszych procesów technologicznych i często amerykańskiej własności intelektualnej. Aby się dostosować, chińskie firmy podjęły kreatywne działania – na przykład NVIDIA sprzedaje teraz zmodyfikowane GPU A800 i H800 do Chin, z ograniczoną wydajnością, aby spełnić amerykańskie limity eksportowe (niższe prędkości połączeń itp.), dzięki czemu chińscy dostawcy chmury mogą nadal zbliżyć się do światowego poziomu. Tymczasem Chiny ścigają się, aby osiągnąć samowystarczalność w kluczowych technologiach chipowych. Krajowa odlewnia SMIC zaskoczyła obserwatorów, produkując chipy klasy 7 nm (z wykorzystaniem technik litografii DUV) – podobno używane w nowym smartfonie Huawei i akceleratorze AI – mimo braku dostępu do narzędzi EUV globenewswire.com. Wskazuje to na determinację Chin do rozwoju nawet pod sankcjami: na przykład innowacje SMIC w zakresie DUV umożliwiły produkcję chipu AI Huawei Ascend 920 w technologii ~7 nm, pomagając „przezwyciężyć ograniczenia eksportowe i pozostać konkurencyjnym” globenewswire.com. Rząd uruchomił także programy rozwoju krajowego oprogramowania EDA, materiałów półprzewodnikowych i kadr, aby wzmocnić łańcuch dostaw.Pomimo tych przeszkód, sama skala rynku Chin praktycznie gwarantuje, że będą one głównym graczem. Kraj ten produkuje i konsumuje ogromne ilości danych – od ponad miliarda użytkowników mobilnych po powszechne usługi oparte na AI – tworząc ogromny popyt krajowy na akceleratory. Sektory takie jak nadzór (z milionami kamer wykorzystujących AI do analizy obrazu), fintech, e-commerce i automatyzacja produkcji opierają się na chipach AI. Ponadto chińska ofensywa w dziedzinie pojazdów autonomicznych i inteligentnej infrastruktury stanowi silny impuls (na przykład platforma autonomicznej jazdy Apollo firmy Baidu wykorzystuje lokalne chipy AI do percepcji pokładowej). Według niektórych szacunków, do 2030 roku Chiny mogą odpowiadać za prawie jedną trzecią światowego popytu na chipy AI, choć obecnie większość tego zapotrzebowania zaspokajają zagraniczne chipy. Jeśli rodzima branża będzie się dalej rozwijać, może przejąć dużą część tej wartości wewnętrznie. Celem Pekinu jest znaczne zwiększenie samowystarczalności: rząd Chin zadeklarował, że do 2025 roku chce produkować 70% używanych chipów (wszystkich typów, nie tylko AI), a do 2030 roku zniwelować różnicę w zakresie zaawansowanych chipów logicznych. Chociaż najbardziej zaawansowana produkcja (węzły 5 nm, 3 nm) może pozostać nieosiągalna w najbliższym czasie, chińscy projektanci chipów AI mogą wykorzystywać procesy 14 nm/7 nm do produkcji bardzo konkurencyjnych akceleratorów do wielu zastosowań – zwłaszcza do wnioskowania na brzegu sieci, gdzie nieco starsze procesy technologiczne często są wystarczające.

Podsumowując, Chiny sprintują, by zbudować kompletny ekosystem chipów AI z mieszanki konieczności i ambicji. Rywalizacja technologiczna USA-Chiny w pewnym sensie przyspieszyła determinację Chin do inwestowania w chipy. Możemy się spodziewać, że Chiny będą wprowadzać coraz bardziej zaawansowane akceleratory AI każdego roku, stopniowo zmniejszając zależność od importu. Jednak sankcje będą również ograniczać tempo, w jakim chińskie chipy mogą osiągnąć parytet pod względem absolutnej wydajności (ze względu na ograniczenia w produkcji najwyższej klasy). Ta dynamika – chińska innowacyjność pod zewnętrznymi ograniczeniami – będzie motywem przewodnim wyścigu akceleratorów AI do 2030 roku.

Europa i inne regiony: Dążenie do suwerenności półprzewodnikowej

Europa, choć nie posiada odpowiednika Nvidii czy Huawei w dziedzinie chipów AI, jest mimo to ważnym obszarem na globalnej mapie. Europejskie branże (motoryzacja, lotnictwo, opieka zdrowotna itd.) są ogromnymi konsumentami półprzewodników, a coraz częściej także akceleratorów AI, nawet jeśli same chipy często pochodzą z zagranicy. Dostrzegając strategiczne znaczenie, UE rozpoczęła skoordynowane działania na rzecz wzmocnienia swojej suwerenności półprzewodnikowej. Sztandarową inicjatywą jest EU Chips Act, uchwalony w 2023 roku, który mobilizuje 43 mld euro środków publicznych i prywatnych na wzmocnienie europejskich możliwości projektowania i produkcji chipów eetimes.eu. Kluczowym celem jest podwojenie udziału Europy w globalnej produkcji chipów do 20% do 2030 roku, z historycznie niskiego poziomu ~9% obecnie eetimes.eu. To ambitny cel (zwłaszcza że światowy rynek się powiększa), ale odzwierciedla on dążenie Europy do uniezależnienia się od zagranicznych dostawców kluczowych technologii.

W praktyce strategia Europy polegała na przyciąganiu czołowych producentów chipów do budowy fabryk na europejskiej ziemi (przy wsparciu hojnych dotacji). Na przykład Intel inwestuje do 30 mld euro w budowę zaawansowanych fabryk w Niemczech i Irlandii (z czego ok. 10 mld euro to dotacje z Niemiec) nextmsc.com. TSMC (Tajwan) również zgodziło się zbudować fabrykę w Niemczech, przy wsparciu rządu. Te fabryki nie będą produkować wyłącznie chipów AI, ale wzmocnią ogólne moce produkcyjne i know-how w regionie. Europa jest także silna w dziedzinie sprzętu półprzewodnikowego (ASML z Holandii jest monopolistą w dostawach maszyn do litografii EUV, na przykład) oraz w badaniach (z instytutami takimi jak IMEC w Belgii). Francja i Niemcy mają inicjatywy na rzecz rozwoju rodzimego IP procesorów (jak European Processor Initiative ukierunkowana na obliczenia eksaskalowe), co może przełożyć się na AI. I choć w Europie brakuje dużych firm produkujących chipy AI, istnieje tu wiele startupów i niszowych graczy:

- Brytyjska firma Graphcore (choć Wielka Brytania jest już poza UE) to znany startup zajmujący się akceleratorami AI, znany ze swojej architektury Intelligence Processing Unit (IPU). Zebrała ponad 680 milionów dolarów i osiągnęła wycenę około 2,8 miliarda dolarów research.contrary.com, współpracując z firmami takimi jak Dell w zakresie oferowania systemów IPU. Jednak Graphcore napotyka trudności w zdobyciu szerokiej adopcji w obliczu ekosystemu NVIDIA.

- XMOS (Bristol, Wielka Brytania) produkuje układy AI na brzegu sieci i był jednym z pierwszych innowatorów w dziedzinie wnioskowania AI przy niskim poborze mocy.

- Hailo (Izrael – ściśle powiązany z europejskim przemysłem motoryzacyjnym) oferuje układy AI na brzegu sieci do kamer i pozyskał znaczne finansowanie.

- BMW i Mercedes w Niemczech prowadzą własne badania i rozwój układów AI do autonomicznej jazdy, czasem we współpracy z dostawcami.

- Bosch, niemiecki dostawca motoryzacyjny, inwestuje w fabryki układów scalonych i opracował układy AI ASIC do systemów radarowych i kamerowych stosowanych w samochodach.

Europa korzysta również z ARM – brytyjskiego projektanta IP układów scalonych (obecnie należącego do japońskiego SoftBanku) – którego rdzenie procesorów i NPU znajdują się w wielu układach SoC z obsługą AI na całym świecie. Choć ARM sam nie produkuje układów AI, jego wpływ (oraz fakt, że NVIDIA próbowała kupić ARM w 2020 roku, zanim regulatorzy to zablokowali) wpisuje się w rolę Europy w łańcuchu wartości chipów.

Ogólnie rzecz biorąc, obecny udział Europy w rynku akceleratorów AI jest stosunkowo niewielki (większość układów jest importowana z USA lub Azji), ale region koncentruje się na polityce i partnerstwach, aby się rozwijać. Europejscy liderzy często podkreślają potrzebę budowy „mózgów”, które trafią do europejskich produktów – czy to samochodów elektrycznych, robotyki, czy infrastruktury chmurowej. Firmy z regionu są ogromnymi klientami: na przykład europejscy producenci samochodów będą głównymi nabywcami układów AI do autonomicznej jazdy, a firmy takie jak SAP i Siemens będą wdrażać sprzęt AI w rozwiązaniach przemysłowych. Dlatego strategia Europy polega częściowo na wykorzystaniu tego popytu, aby przyciągnąć inwestycje w chipy lokalnie.

Inne kluczowe regiony na rynku układów AI to Azja Wschodnia (poza Chinami) oraz nowi gracze:

- Tajwan odgrywa absolutnie kluczową rolę, choć głównie jako baza produkcyjna. Sam TSMC z Tajwanu produkuje szacunkowo 90% najbardziej zaawansowanych układów na świecie (5 nm i poniżej), w tym praktycznie wszystkie najnowocześniejsze akceleratory AI eetimes.eu. Oznacza to, że niezależnie od tego, czy chip został zaprojektowany przez NVIDIA, Google czy Alibaba, najprawdopodobniej został wyprodukowany na Tajwanie. Ta koncentracja niesie ze sobą ryzyka dla łańcucha dostaw (np. napięcia geopolityczne wokół Tajwanu), ale jak dotąd TSMC pozostaje niezawodnym filarem, zwiększając moce produkcyjne, by sprostać zapotrzebowaniu na układy AI. Tajwan posiada także talenty w projektowaniu układów AI (np. MediaTek to duża firma produkująca układy mobilne, która w swoich projektach uwzględnia NPU, a startup TensorCore rozwija układy AI).

- Korea Południowa jest liderem w dziedzinie pamięci (kluczowej dla systemów AI) i posiada także firmę Samsung, która zarówno produkuje, jak i projektuje niektóre układy scalone. Samsung opracował NPU zintegrowane z mobilnymi procesorami Exynos i prowadzi badania nad akceleratorami AI (w tym nad układami neuromorficznymi). Inny koreański startup, Rebellions, buduje układy AI dla centrów danych i otrzymał wsparcie rządowe. Korea Południowa zamierza wykorzystać swoją siłę w dziedzinie pamięci i elektroniki, aby nie przegapić fali sprzętu AI.

- Japonia posiada głęboką wiedzę w niektórych obszarach układów scalonych (czujniki, układy do motoryzacji), a firmy takie jak Sony i Renesas zintegrowały przetwarzanie AI w swoich produktach (czujniki obrazu Sony z przetwarzaniem AI, układy Renesas do samochodów itd.). Rząd Japonii inwestuje także w zaawansowane konsorcja półprzewodnikowe (np. Rapidus dla fabryk 2 nm do końca lat 2020.), które – jeśli się powiodą – mogą ostatecznie produkować układy AI w kraju. Dodatkowo Japonia pozostaje czołowym dostawcą sprzętu i materiałów półprzewodnikowych (niezbędnych do produkcji każdego układu AI).

- Izrael zasługuje na wzmiankę ze względu na swoją ponadprzeciętną rolę w startupach AI chip: Habana (obecnie Intel), Mobileye (Intel), Hailo, NeuroBlade i inne – wiele innowacji pochodzi stamtąd, często przejmowanych przez amerykańskie firmy.

- Indie i Kanada również podejmują pierwsze kroki: Indie, które historycznie nie były producentem układów scalonych, ogłosiły zachęty dla fabryk półprzewodników i mogą stać się centrum montażu/testowania, podczas gdy kanadyjska Tenstorrent jest przykładem północnoamerykańskiej różnorodności poza Doliną Krzemową.

Ciekawym zjawiskiem jest zaangażowanie Bliskiego Wschodu jako inwestorów i użytkowników końcowych sprzętu AI. Fundusze państwowe i inicjatywy technologiczne na Bliskim Wschodzie (np. inicjatywy AI Arabii Saudyjskiej, grupa G42 ze Zjednoczonych Emiratów Arabskich) zaczęły masowo kupować najnowocześniejsze systemy AI, efektywnie importując duże ilości GPU NVIDIA, a nawet współpracując z firmami takimi jak Cerebras. Na przykład G42 z ZEA była największym klientem Cerebras w 2023 roku, wykorzystując jej komputerowe systemy AI na skalę wafla do budowy dużych modeli nextplatform.com. Arabia Saudyjska podobno buduje centra danych z dziesiątkami tysięcy GPU na potrzeby krajowych badań AI. Choć te kraje nie rozwijają własnych układów akceleratorów, ich ogromne środki finansowe wspierają ekosystem (a nawet obejmują udziały w firmach AI chip, jak pokazują inwestycje Abu Zabi).

Podsumowując, poza USA i Chinami, inne regiony nie chcą zostać w tyle w wyścigu sprzętu AI. Europa dąży do strategicznej autonomii poprzez finansowanie i lokalne fabryki, Tajwan i Korea Południowa pozostają niezbędne w produkcji i starają się piąć w górę łańcucha wartości, a mniejsi gracze wnoszą wkład poprzez niszową wiedzę lub kapitał. Rynek akceleratorów AI do 2030 roku będzie zatem kształtowany przez złożoną globalną mozaikę współpracy i konkurencji – z układami często współprojektowanymi w jednym miejscu, produkowanymi w innym i używanymi na całym świecie.

Różnorodne zastosowania w chmurze, na brzegu i w urządzeniach

Układy akceleratorów AI są wdrażane w niezwykle różnorodnym zakresie zastosowań i środowisk, z których każde ma własne wymagania. Poniżej przedstawiamy kluczowe przypadki użycia i sposób, w jaki akceleratory je napędzają:

- Centra danych w chmurze:Epicentrum szkolenia AI znajduje się w hiperskalowych centrach danych chmurowych i korporacyjnych. Tutaj szeregi akceleratorów (GPU/TPU/ASIC) pracują równolegle, aby trenować duże modele AI i obsługiwać wymagające zadania inferencyjne. Dostawcy chmury (AWS, Google Cloud, Microsoft Azure, Alibaba Cloud itd.) oferują instancje akceleratorów AI na wynajem, umożliwiając badaczom i firmom uruchamianie tysięcy chipów na żądanie. Skala jest oszałamiająca – najlepsze klastry szkoleniowe AI łączą obecnie dziesiątki tysięcy GPU za pomocą szybkich połączeń, tworząc „superkomputery AI”. Jak wspomniano, trening GPT-4 pochłonął szacunkowo 25 000 GPU przez kilka miesięcy research.contrary.com. Te centra danych coraz częściej wyposażone są w wyspecjalizowaną infrastrukturę (szybkie sieci jak InfiniBand, systemy chłodzenia dla energochłonnych chipów itd.), aby sprostać wymaganiom obciążeń AI. Chipy AI w chmurze skupiają się na maksymalizacji przepustowości (np. operacji macierzowych na sekundę) i przepustowości pamięci. Dominacja NVIDIA w tym obszarze jest kwestionowana przez chipy własnej produkcji (TPU itd.), ale na połowę 2025 roku GPU nadal napędzają większość obliczeń AI w chmurze. Biorąc pod uwagę gwałtowny wzrost wykorzystania generatywnej AI (wyszukiwanie, asystenci, tworzenie treści), analitycy przewidują ponad 300% wzrost wydatków na AI w ciągu zaledwie najbliższych 3 lat w centrach danych io-fund.com. Rzeczywiście, do 2030 roku obciążenia AI w centrach danych mają być ogromne – jeden ze scenariuszy szacuje 25×10^30 FLOPs zapotrzebowania na generatywne obliczenia AI na całym świecie mckinsey.com. Obsłużenie tego będzie wymagało ciągłego rozwoju chipów akceleratorów i prawdopodobnie większej liczby serwerów dedykowanych AI (z akceleratorami w jednej obudowie, fotonicznymi połączeniami itd. na horyzoncie).

- Edge Computing i IoT: Nie cała sztuczna inteligencja działa w chmurze – istnieje silny trend w kierunku przenoszenia AI na urządzenia brzegowe: na urządzenia takie jak kamery, wearables, sprzęty AGD, drony i maszyny przemysłowe. Akceleratory Edge AI (często miniaturowe NPU lub DSP) umożliwiają wnioskowanie w czasie rzeczywistym z niskimi opóźnieniami i bez stałego połączenia z internetem. Przykłady zastosowań to inteligentne kamery wykonujące analizę obrazu na urządzeniu, maszyny fabryczne z AI do predykcyjnego utrzymania ruchu oraz zestawy AR/VR z lokalnym rozumieniem sceny. Boom na Internet Rzeczy (IoT) oznacza miliardy urządzeń generujących dane; wbudowanie w nie chipów AI pozwala na natychmiastowe przetwarzanie tych danych. Jest to napędzane zaletami w zakresie opóźnień, prywatności i przepustowości. Na przykład kamera bezpieczeństwa z chipem AI może wykryć intruza lokalnie w milisekundy, zamiast wysyłać wideo do serwera w chmurze. Rynek chipów AI dla edge ma szybko rosnąć (wspomniane 42% CAGR) globenewswire.com. Już teraz smartfony są główną platformą edge AI – każdy nowoczesny SoC w telefonie, od serii A Apple po Qualcomm Snapdragon, zawiera akcelerator AI do zadań takich jak ulepszanie obrazu, rozpoznawanie głosu czy rzeczywistość rozszerzona. W rzeczywistości elektronika konsumencka odpowiadała za ok. 34% użycia chipów AI w 2024 roku globenewswire.com, głównie ze względu na liczbę smartfonów z NPU. Po stronie przemysłowej firmy takie jak NXP, Infineon i Analog Devices integrują możliwości AI z mikrokontrolerami i czujnikami. Nawet miniaturowe mikrokontrolery (MCU) mają już czasem akceleratory „TinyML” do uruchamiania prostych sieci neuronowych w wearables lub domowych gadżetach. Ta rozproszona inteligencja ma przeniknąć do inteligentnych domów, miast i infrastruktury. Jak zauważa jeden z raportów, rozprzestrzenianie się urządzeń IoT generujących ogromne ilości danych napędza popyt na chipy AI umożliwiające inteligentne przetwarzanie na poziomie urządzenia, dla analityki i podejmowania decyzji w czasie rzeczywistym na miejscu nextmsc.com. Akceleratory edge stawiają na niskie zużycie energii (aby wydłużyć czas pracy na baterii) i często muszą być wytrzymałe lub wyspecjalizowane do środowisk (np. chipy klasy automotive odporne na ciepło/wibracje).

- Pojazdy autonomiczne: Samojezdne samochody i zaawansowane systemy wspomagania kierowcy (ADAS) to głodni konsumenci chipów AI. Jeden autonomiczny pojazd testowy może mieć wiele chipów akceleratorów przetwarzających obrazy z kamer, dane z LiDAR, sygnały radarowe i inne, aby podejmować decyzje drogowe w ułamku sekundy. Na przykład Tesla opracowała własny chip FSD (Full Self-Driving) do przetwarzania obrazu w swoich samochodach, a NVIDIA DRIVE Orin oraz nowsze SoC Atlan/Thor są wykorzystywane przez wielu producentów samochodów do obsługi funkcji autonomicznych poziomu 2+. Te motoryzacyjne chipy AI są projektowane z myślą o bezpieczeństwie funkcjonalnym i wysokiej niezawodności, często wyposażone w redundantne procesory. Wykonują zadania takie jak wykrywanie obiektów, monitorowanie kierowcy, planowanie trasy – zasadniczo pełniąc rolę „mózgu” pojazdu. Segment motoryzacyjnych chipów AI ma być najszybciej rosnącym, ponieważ nawet samochody klasy średniej mają coraz więcej funkcji ADAS (np. automatyczne hamowanie awaryjne, utrzymanie pasa ruchu), które opierają się na AI na pokładzie. Do 2030 roku w pełni autonomiczne floty taksówek i ciężarówek mogą dodatkowo zwiększyć popyt. Jeden z ekspertów zauważył, że chipy AI są kluczowe dla jazdy autonomicznej, interpretując otoczenie i podejmując inteligentne decyzje w czasie rzeczywistym techstrong.ai. Firmy takie jak Mobileye (Intel) dostarczyły dziesiątki milionów chipów EyeQ do pojazdów, a startupy takie jak Horizon Robotics w Chinach oferują krajowe chipy wspomagające jazdę. Nawet poza samochodami, autonomiczne drony, roboty dostawcze i inne samonawigujące maszyny wykorzystują akceleratory AI do percepcji i sterowania. Unikalnym wymogiem jest tutaj przetwarzanie w czasie rzeczywistym z rygorystycznym bezpieczeństwem – błąd AI może być zagrożeniem życia w ruchu drogowym – dlatego motoryzacyjne chipy AI kładą nacisk na deterministyczną wydajność i szeroką walidację.

- Smartfony i konsumenckie AI: Nasze urządzenia kieszonkowe po cichu stały się potęgami AI. Praktycznie wszystkie flagowe (i wiele średniopółkowych) smartfony mają dziś dedykowane akceleratory AI. Chipy Bionic Apple’a mają Neural Engine, chip Tensor Google’a zawiera TPU-lite, Samsung i Qualcomm integrują NPU – obsługują one takie zadania jak fotografia obliczeniowa (np. Tryb Nocny, który wykorzystuje AI do poprawy obrazu), asystenci głosowi (rozpoznawanie mowy na urządzeniu), identyfikacja twarzy (sieci neuronowe dla FaceID), tłumaczenie języka, a nawet przewidywanie zachowań użytkownika w celu oszczędzania energii. Skala tutaj jest ogromna: miliardy telefonów, tabletów i komputerów codziennie wykonują inferencję AI. Choć pojedyncze NPU są mniejsze niż chipy centrów danych, razem stanowią znaczący rynek. Zazwyczaj są zintegrowane w układach typu system-on-chip (SoC) razem z CPU/GPU/ISP, a nie jako osobne chipy. Trendem jest zwiększanie wydajności AI z każdą generacją – np. Neural Engine Apple’a wzrósł z 600 miliardów operacji/sek do 15,8 biliona operacji/sek w kilka lat. Poza telefonami, urządzenia konsumenckie jak inteligentne głośniki (Amazon Echo z procesorem AZ2), smart TV i zestawy VR (urządzenia Meta korzystają z chipów Qualcomm XR z AI) również wykorzystują AI na urządzeniu. Popyt napędza potrzeba natychmiastowej reakcji i prywatności (przetwarzanie danych osobowych, np. głosu, lokalnie). Wraz z rozwojem okularów AR i urządzeń IoT, można spodziewać się coraz bardziej wyspecjalizowanych, energooszczędnych chipów AI w elektronice konsumenckiej.

- Robotyka i automatyzacja: Roboty w magazynach, szpitalach i biurach coraz częściej wykorzystują wbudowane układy AI do nawigacji i interakcji ze światem. W produkcji ramiona robotyczne używają akceleratorów AI do inspekcji wizualnej i precyzyjnego sterowania. Roboty logistyczne w magazynach Amazona mają na pokładzie AI, aby unikać przeszkód i sortować paczki. Roboty usługowe (takie jak szpitalne roboty dostawcze czy kelnerzy w restauracjach) wykorzystują układy AI do poruszania się i interfejsów głosowych. Te scenariusze często opierają się na wydajnych układach do wnioskowania, które mogą uruchamiać modele wizji komputerowej i polityki uczenia ze wzmocnieniem w czasie rzeczywistym. Jak zauważył jeden z analityków, szybka automatyzacja magazynów napędza wdrażanie układów AI, które sterują robotami i przetwarzają dane z czujników, aby podejmować decyzje techstrong.ai. Pokrewną dziedziną są drony – zarówno konsumenckie, jak i przemysłowe UAV – które wykorzystują układy AI do rozpoznawania obrazów (np. śledzenie celów) i autonomicznego lotu. Robotyka zazwyczaj wymaga akceleratorów bardzo energooszczędnych (aby zmieściły się w małych robotach lub urządzeniach zasilanych bateryjnie), ale jednocześnie zapewniających wystarczającą moc obliczeniową do zadań takich jak SLAM (jednoczesna lokalizacja i mapowanie) oraz rozpoznawanie obiektów. Linia modułów Jetson firmy NVIDIA to popularne rozwiązanie, które zasadniczo łączy GPU i CPU w małej formie dla robotów i edge AI. Liczne startupy (takie jak brazylijski Speedbird czy amerykański Dusty Robotics) wbudowują układy AI, aby zapewnić swoim maszynom większą autonomię. Przy prognozach mówiących o milionach robotów w miejscach pracy do 2030 roku, będzie to skromny, ale znaczący udział w rynku układów AI.

- AI dla przedsiębiorstw i HPC: Wiele dużych przedsiębiorstw i instytucji badawczych wdraża akceleratory AI w swoich lokalnych centrach danych i klastrach wysokowydajnych obliczeń (HPC). Powody są różne: od zarządzania danymi (przechowywanie wrażliwych danych na miejscu) po potrzeby niestandardowe (specjalistyczne badania). Sektory takie jak finanse (handel algorytmiczny, wykrywanie oszustw), opieka zdrowotna (analiza obrazów medycznych) i obrona (wywiad i symulacje) często budują prywatną infrastrukturę AI. Te rozwiązania wykorzystują tę samą klasę układów – wysokiej klasy GPU lub AI ASIC – ale zamknięte w gotowych systemach (np. serwery NVIDIA DGX lub systemy Cerebras CS) dla łatwości wdrożenia. Rynek sprzętu AI dla przedsiębiorstw rośnie, ponieważ AI staje się podstawowym obciążeniem obok tradycyjnego IT. Gotowe urządzenia AI pozwalają firmom bez dużych zespołów inżynierów AI korzystać z przyspieszonego przetwarzania. Na przykład banki mogą instalować węzły NVIDIA DGX do uruchamiania modeli ryzyka lub wykorzystywać urządzenia oparte na FPGA do algorytmów handlu o niskich opóźnieniach. Popyt ze strony przedsiębiorstw wiąże się również ze światem HPC, gdzie superkomputery do badań naukowych coraz częściej integrują akceleratory AI w swojej architekturze. Nowoczesne superkomputery (w laboratoriach narodowych itp.) często mają partycje GPU do symulacji i analizy danych napędzanych przez AI. Do 2030 roku, gdy AI i HPC będą się coraz bardziej przenikać (AI wykorzystywana w symulacjach fizycznych i odwrotnie), niemal wszystkie główne systemy HPC będą zawierać jakąś formę akceleracji AI. To sprzyja wzajemnemu rozwojowi – na przykład GPU H100 jest zarówno układem HPC, jak i AI, obsługując oba rynki. W ten sposób zastosowania w przedsiębiorstwach i HPC zapewniają, że akceleratory trafiają poza największe firmy technologiczne, docierając do każdej dużej organizacji, która może wykorzystać AI dla przewagi konkurencyjnej lub innowacji.

Podsumowując, akceleratory AI stają się wszechobecne w informatyce – od chmury po urządzenia brzegowe, od urządzeń osobistych po maszyny przemysłowe. Każdy przypadek użycia ceni inne metryki (przepustowość, opóźnienie, zużycie energii, koszt), dlatego obserwujemy współistnienie różnych typów układów scalonych (GPU dla elastyczności, ASIC dla wydajności, FPGA dla adaptacyjności itd.). Tak szerokie zastosowanie w różnych dziedzinach jest podstawowym motorem wzrostu rynku chipów AI – AI nie jest pojedynczą niszą, lecz technologią horyzontalną, umożliwiającą rozwój na wielu płaszczyznach, podobnie jak elektryczność czy internet, a wyspecjalizowany krzem stanowi kręgosłup umożliwiający jej skalowanie.

Kluczowe czynniki rynkowe

Kilka silnych czynników napędza szybki wzrost rynku chipów akceleratorów AI:

- Popyt na generatywną AI i zaawansowane ML: Szum wokół generatywnej AI (duże modele językowe jak ChatGPT, generatory obrazów itd.) przekłada się na realne inwestycje w sprzęt AI. Organizacje ścigają się w trenowaniu coraz większych modeli, by pozostać konkurencyjnymi, co bezpośrednio napędza popyt na większą liczbę GPU i chipów AI w centrach danych. Analitycy nazywają to kolejną „złotą falą” inwestycji technologicznych, ponieważ możliwości AI odblokowują nowe produkty i usługi fingerlakes1.com. W przeciwieństwie do niektórych wcześniejszych cykli technologicznych, AI okazała się transformacyjna w różnych branżach – od tworzenia treści po obsługę klienta – dlatego firmy odpowiednio planują budżety na infrastrukturę AI. CEO NVIDIA zauważył, że każdy sektor obecnie zastanawia się, jak zastosować AI, co prowadzi do korzystnego cyklu innowacji modeli i wydatków na sprzęt. Generatywna inferencja AI (serwowanie odpowiedzi AI użytkownikom) również generuje stały popyt na akceleratory, ponieważ te modele muszą działać na GPU/ASIC, aby dostarczać wyniki z niskim opóźnieniem.

- Szeroka adopcja AI w przemyśle: Poza chatbotami przyciągającymi uwagę mediów, AI jest wdrażana w procesach w ochronie zdrowia, finansach, produkcji, handlu detalicznym i innych. Tak powszechna adopcja zwiększa zapotrzebowanie na chipy. Na przykład szpitale używają chipów AI do diagnostyki obrazowej (analiza MRI wspierana AI), rolnicy stosują je w dronach do monitorowania upraw, a detaliści wdrażają AI do optymalizacji łańcucha dostaw. Jak podkreślono w raporcie NextMSC, sektory od motoryzacji po finanse integrują AI – autonomiczna jazda, wykrywanie oszustw, spersonalizowany handel detaliczny – wszystko to „zwiększa popyt na chipy AI” nextmsc.com. W wielu przypadkach AI umożliwia rzeczy wcześniej niemożliwe lub nieopłacalne, tworząc nowe zastosowania (np. czujniki predykcyjnej konserwacji na platformach wiertniczych wykorzystują teraz lokalne akceleratory AI do wykrywania anomalii). Cyfryzacja przemysłu działa jak wiatr w żagle: więcej danych cyfrowych -> więcej analiz AI -> większe zapotrzebowanie na sprzęt zoptymalizowany pod AI.

- Wzrost Edge AI i IoT: Wzrost liczby urządzeń IoT oraz potrzeba przetwarzania w czasie rzeczywistym na brzegu sieci to istotny czynnik napędzający rynek. Miliardy podłączonych czujników i inteligentnych urządzeń są wdrażane, a wiele z nich będzie wyposażonych w jakąś formę akceleracji AI do obsługi zadań lokalnie. Jak zauważono, wydatki na ekosystem IoT rosną dynamicznie i prognozuje się, że przekroczą 1 bilion dolarów do 2026 roku nextmsc.com, co koreluje z większymi inwestycjami w układy AI na brzegu sieci. Zastosowania takie jak inteligentne miasta (kamery monitoringu z AI), inteligentne fabryki (AI monitorujące sprzęt) oraz inteligentne domy (inteligentne urządzenia AGD) wszystkie wymagają „wydajnych układów AI do analityki na urządzeniu” nextmsc.com. Dążenie do prywatności (przechowywanie danych na urządzeniu) i niskich opóźnień (natychmiastowa reakcja) oznacza, że edge AI będzie się nadal rozwijać, napędzając wysokie wolumeny dostaw akceleratorów (choć mniejszych i tańszych na jednostkę niż układy chmurowe).

- Imperatyw efektywności energetycznej: Wraz ze skalowaniem obciążeń AI, zużycie energii stało się kluczowym problemem. Centra danych obsługujące AI mogą pobierać ogromne ilości energii elektrycznej – jedna z analiz ostrzegała, że centra danych AI mogą zużywać >10% globalnej energii do 2030 roku, jeśli obecne trendy się utrzymają mckinsey.com. To tworzy silną motywację do bardziej wydajnych układów do obsługi operacji AI na wat. Tak więc jednym z czynników rynkowych jest potrzeba energooszczędnych układów AI. Wyspecjalizowane akceleratory mogą być znacznie bardziej energooszczędne niż CPU w zadaniach AI, a każda nowa generacja układów (5nm, 3nm itd.) przynosi zyski w efektywności. Firmy inwestują w nowe architektury (np. obliczenia analogowe, optyczne układy AI), dążąc do wielokrotnie niższego zużycia energii przy przetwarzaniu sieci neuronowych. Zarówno rządy, jak i dostawcy chmury są zainteresowani ograniczeniem śladu węglowego i kosztów AI – a modernizacja do najnowszych, wydajnych akceleratorów to kluczowa strategia. Raport SNS Insider wyraźnie wskazuje „energooszczędne układy” jako czynnik wzrostu obok generatywnej AI i edge computingu globenewswire.com. W przyszłości efektywność energetyczna to nie tylko kwestia kosztów, ale także zrównoważonego rozwoju i zgodności z regulacjami, co może przyspieszyć wdrażanie nowszych układów (o niższym TDP) w miejsce starszych, energochłonnych.

- Polityka rządowa i inwestycje: Czynniki geopolityczne i ekonomiczne silnie katalizują rynek chipów AI. Programy finansowania rządowego, takie jak amerykańska ustawa CHIPS o wartości 52 miliardów dolarów oraz europejska ustawa Chips Act o wartości 43 miliardów euro, pompują środki w badania i rozwój oraz produkcję półprzewodników nextmsc.com eetimes.eu. Choć są to działania szeroko zakrojone, akceleratory AI mogą znacząco skorzystać jako segment o wysokim wzroście, który wpisuje się w narodowe priorytety dotyczące przywództwa w AI. Na przykład amerykańska ustawa CHIPS zawiera konkretne zachęty dla odlewni, które będą produkować zaawansowane układy logiczne wykorzystywane w AI, a także finansowanie badań nad projektowaniem chipów AI. Podobnie rząd Chin uczynił półprzewodniki najwyższym priorytetem w swoich planach pięcioletnich, przeznaczając podobno dziesiątki miliardów dolarów subsydiów na krajowy sektor chipów AI (dotacje, inwestycje kapitałowe, tanie pożyczki dla startupów AI). Ta inicjatywa sektora publicznego przyspiesza innowacje i zwiększa moce produkcyjne – powstały nowe fabryki, startupy i programy uniwersyteckie z zakresu projektowania chipów dzięki tym zachętom. Dodatkowo, zainteresowanie sektora obronnego AI (np. do autonomicznych systemów wojskowych) skutkuje popytem rządowym na zaawansowane chipy AI i może prowadzić do większych nakładów publicznych na badania i rozwój wyspecjalizowanych procesorów.

- Postęp technologiczny i nowe zastosowania: Po stronie podaży, ciągłe postępy w technologii półprzewodników umożliwiają powstawanie lepszych chipów AI, które z kolei otwierają nowe zastosowania. Na przykład przejście na procesy 3 nm i nadchodzące 2 nm pozwala upakować więcej tranzystorów w akceleratorach, umożliwiając pamięć na chipie, większe rdzenie macierzowe itp., co poprawia wydajność AI. Produkcja masowa 2 nm TSMC planowana jest na 2025 rok, co zapowiada chipy o większej gęstości i wydajności nextmsc.com – prawdopodobnie przyniesie to kolejną falę chipów AI o bezprecedensowych możliwościach. Tak ulepszone chipy mogą sprawić, że takie rozwiązania jak okulary AR w czasie rzeczywistym czy autonomiczne drony staną się znacznie bardziej realne (gdzie wcześniejsze chipy były zbyt słabe lub zbyt energochłonne). W istocie, lepsze chipy tworzą nowe rynki, czyniąc AI możliwą do zastosowania w większej liczbie kontekstów. Na przykład, jeśli przełom sprawi, że akceleratory AI będą 10× bardziej wydajne, możemy zobaczyć je w każdym urządzeniu i pojeździe, nie tylko w tych z najwyższej półki. Wzajemnie napędzający się cykl prawa Moore’a (choć spowalnia, wciąż żyje dzięki architekturze chipletów, układaniu 3D itp.) oraz postęp algorytmów AI nadal napędzają rynek. Jako konkretny przykład, wprowadzenie HBM (High Bandwidth Memory) w akceleratorach opartych na GPU znacznie zwiększyło prędkości pamięci, umożliwiając przetwarzanie większych modeli AI, co z kolei napędza wdrażanie tych chipów w centrach danych, które chcą trenować modele o bilionach parametrów. Tak więc osiągnięcia w badaniach i rozwoju – od nowych projektów układów po nowe materiały do produkcji chipów – są fundamentalnymi czynnikami napędzającymi wzrost rynku.

- AI jako priorytet strategiczny dla przedsiębiorstw: Wreszcie, na poziomie strategicznym, firmy we wszystkich branżach obecnie uznają, że wdrożenie AI jest kluczowe dla utrzymania konkurencyjności. To podejście „AI-first” przekłada się na przydzielanie budżetu na infrastrukturę AI. CIO i CTO opowiadają się za platformami AI w swoich organizacjach, często przy wsparciu zarządu, co oznacza, że nawet tradycyjnie konserwatywne branże inwestują w sprzęt AI. Dostawcy chmury zgłaszają, że obciążenia AI są głównym czynnikiem napędzającym nowe wydatki na chmurę – klienci korporacyjni chmury wyraźnie poszukują zasobów GPU/TPU do swoich projektów. Ten szeroki popyt ze strony klientów korporacyjnych i instytucjonalnych (banki, uniwersytety, medycyna itd.) jest czynnikiem, który nie istniał w pełni dekadę temu, gdy AI było niszowe. Dziś, jeśli firma z listy Fortune 500 chce wdrożyć usługę wspieraną przez AI, może zakupić klaster akceleratorów lub wykupić subskrypcję na instancje w chmurze – w obu przypadkach generując przychody w ekosystemie chipów AI. Dynamika AI w biznesie (co potwierdza fakt, że ponad 70% organizacji wdrożyło jakąś formę AI do 2024 roku, w porównaniu do 20% w 2017 roku research.contrary.com) zapewnia silny, podstawowy sygnał popytu dla dostawców akceleratorów.

Te czynniki wzmacniają się nawzajem – np. wsparcie rządowe przyspiesza postęp technologiczny, który umożliwia nowe zastosowania, co z kolei napędza większą adopcję w przedsiębiorstwach itd. Razem tworzą obraz solidnych, trwałych warunków wzrostu dla rynku chipów akceleratorów AI do 2030 roku i później.

Wyzwania i ograniczenia

Pomimo optymizmu, branża akceleratorów AI stoi w obliczu szeregu wyzwań i przeciwności, które mogą spowolnić wzrost lub wpłynąć na kształtowanie się krajobrazu konkurencyjnego:

- Ograniczenia w dostawach chipów: Jednym z natychmiastowych wyzwań jest to, że popyt przewyższa podaż na najnowocześniejsze chipy AI. Globalny niedobór półprzewodników w latach 2021–2022 ujawnił, jak ograniczona jest pojemność fabryk, zwłaszcza na zaawansowanych węzłach, co może powodować wąskie gardła w branżach. Nawet w latach 2024–2025 firmy zgłaszały długie czasy oczekiwania na GPU. Odlewnie takie jak TSMC pracują na pełnych obrotach przy produkcji wafli 5nm/4nm, a zwiększenie mocy produkcyjnych zajmuje lata i wymaga inwestycji rzędu dziesiątek miliardów dolarów. W rezultacie firmy AI czasami mają trudności z pozyskaniem wystarczającej liczby chipów, aby zaspokoić potrzeby wewnętrzne lub klientów. „Globalny deficyt chipów” spowodował powstanie długich list oczekujących i trudności w łańcuchu dostaw, a odlewnie priorytetowo traktują inne produkty masowe kosztem niektórych chipów AI nextmsc.com. Ta sytuacja może spowolnić projekty AI lub podnieść ceny. Dodatkowo, poleganie na kilku odlewniach (TSMC, Samsung) oznacza, że każde zakłócenie (konflikt polityczny, klęska żywiołowa) może poważnie wpłynąć na dostawy. Analitycy branżowi ostrzegają, że do 2030 roku może wystąpić „niedobór podaży wafli logicznych” na wiodących węzłach, napędzany eksplozją popytu na AI – potencjalnie może zabraknąć milionów wafli, jeśli nie powstaną nowe fabryki mckinsey.com. Budowa wystarczającej liczby nowych fabryk (każda to łatwo ponad 10 mld dolarów i 2–3 lata budowy) to zarówno wyścig, jak i priorytet geopolityczny (stąd ustawy o chipach). Dopóki podaż i popyt się nie zrównoważą, ograniczona dostępność najnowszych chipów może w niektórych przypadkach hamować wdrażanie AI.

- Wysokie koszty B+R i produkcji: Opracowanie najnowocześniejszych chipów AI jest niesamowicie kosztowne i złożone. Koszt zaprojektowania ASIC 5nm lub 3nm może sięgać setek milionów dolarów, jeśli uwzględnić talenty inżynierskie, narzędzia EDA, prototypowanie i rozwój stosu oprogramowania. W przypadku GPU i innych dużych chipów wydatki są jeszcze większe (NVIDIA podobno wydaje miliardy na każdy nowy cykl B+R i tape-out GPU). Ta wysoka bariera wejścia oznacza, że tylko firmy z dużym kapitałem (lub bardzo silną niszą) mogą konkurować na krawędzi technologii. Startupy muszą albo pozyskać ogromne środki, albo znaleźć mniej konkurencyjną niszę. Nawet wtedy przekształcenie prototypu w produkt wymaga przejścia przez produkcję (same maski kosztują dziesiątki milionów) i później konkurowania z uznanymi graczami. Po stronie produkcji nakłady inwestycyjne na zwiększenie mocy są ogromne, jak wspomniano. Zatem wyzwaniem jest: czy podaż nadąży bez nadmiernego wzrostu kosztów (a tym samym cen chipów)? Istnieje ryzyko, że rosnące koszty fabryk i projektowania mogą sprawić, że każda nowa generacja akceleratorów AI będzie droższa, co potencjalnie spowolni wdrażanie. Jednak historycznie wzrost wolumenu pomagał to równoważyć, a główni gracze korzystają z efektu skali. Mimo to ryzyko finansowe każdej pomyłki projektowej (nieudany projekt chipu) jest wysokie, co może zniechęcać do innowacji na marginesie.

- Konkurencyjne fosy – uzależnienie od ekosystemu oprogramowania: Jednym z mniej namacalnych, ale kluczowych wyzwań dla nowych graczy jest ekosystem oprogramowania. Dominacja NVIDIA to nie tylko sprzęt; to także platforma programistyczna CUDA i ogromna społeczność deweloperów zoptymalizowana pod ich GPU. Podobnie, TPU Google są powiązane z TensorFlow i ekosystemem chmurowym Google. Aby nowy chip AI zdobył popularność, musi oferować nie tylko surową wydajność, ale także łatwą integrację z przepływami pracy AI (wsparcie dla frameworków takich jak PyTorch, narzędzia do migracji itd.). To wysoka poprzeczka – wiele obiecujących chipów miało trudności, ponieważ stos oprogramowania AI nie był dojrzały lub deweloperzy nie chcieli przepisywać kodu. Tworzy to rodzaj przewagi inkumbenta: nawet jeśli chip startupu jest np. 2× szybszy, jeśli jego użycie wymaga dużo wysiłku, klienci mogą pozostać przy NVIDIA. Problemy Graphcore to ilustrują; mimo innowacyjnego sprzętu, budowa kompilatora i przekonanie deweloperów do przenoszenia modeli okazały się wyzwaniem research.contrary.com. Ten „efekt sieciowy” w oprogramowaniu to bariera wejścia, która może tłumić konkurencję i jest wyzwaniem, z którym branża musi się zmierzyć (poprzez standardy lub oprogramowanie pośredniczące), jeśli ma rozkwitnąć różnorodność akceleratorów. Pewne działania, jak uniezależnianie frameworków ML od sprzętu czy stosowanie otwartych standardów (jak Triton OpenAI czy oneAPI), mogą to ułatwić, ale wciąż pozostaje to punktem tarcia.

- Limity mocy i termiczne: W miarę jak chipy AI oferują coraz większą moc obliczeniową, gęstość mocy i odprowadzanie ciepła stają się czynnikami ograniczającymi. Pojedynczy topowy GPU może obecnie pobierać 300–400 watów pod obciążeniem; serwery z 8 takimi GPU mogą zużywać >3 kW. Operatorzy centrów danych mierzą się z wyzwaniami w dostarczaniu zasilania i chłodzeniu – wielu z nich osiąga granice możliwości chłodzenia powietrzem i przechodzi na chłodzenie cieczą dla szaf pełnych akceleratorów AI. Istnieje też górna granica, gdzie chipy po prostu nie mogą dalej zwiększać TDP bez nowatorskiego chłodzenia (np. chłodzenie zanurzeniowe) lub bardziej wydajnych architektur. Choć wydajność na operację się poprawia, sama skala modeli powoduje wzrost całkowitego zużycia energii. To rodzi obawy o zrównoważony rozwój i koszty operacyjne. Jeśli zapotrzebowanie na moc obliczeniową AI będzie nadal podwajać się co 1–2 lata, możemy dojść do sytuacji, w której obecna infrastruktura centrów danych nie poradzi sobie z wymaganym poborem mocy bez znaczących modernizacji. Wyzwanie polega więc na innowacjach, by utrzymać wzrost wydajności w rozsądnych granicach zużycia energii. Stosuje się takie techniki jak architektury chipletowe (rozproszenie obliczeń na wiele układów), lepsze materiały i nowe metody chłodzenia, by temu sprostać. Niemniej jednak, moc to podstawowe ograniczenie, które może utrudnić niektóre wdrożenia (np. AI na skraju sieci, na baterii), dopóki nie nastąpią przełomy.

- Ryzyka geopolityczne i handlowe: Arena chipów AI jest uwikłana w rywalizację geopolityczną, zwłaszcza między USA a Chinami. Ograniczenia handlowe (kontrole eksportu) tworzą niepewność i podział rynku. Na przykład, amerykańskie przepisy z 2022 roku zakazały eksportu niektórych wysokowydajnych chipów AI do Chin, co odcięło duży rynek dla tych chipów i zmusiło firmę NVIDIA do stworzenia okrojonych wersji. Istnieje ryzyko dalszego rozłączenia: jeśli Chiny nie będą mogły pozyskiwać zachodnich chipów, przyspieszą rozwój własnych alternatyw, co może prowadzić do rozbieżnych ekosystemów (różne standardy oprogramowania itp.). Firmy muszą ostrożnie poruszać się w tej polityce – amerykańskie przedsiębiorstwa nie chcą tracić rynku chińskiego, ale muszą przestrzegać przepisów. Z drugiej strony, chińskie firmy są narażone na ryzyko, jeśli polegają na zachodniej własności intelektualnej lub fabach – np. chiński producent chipów AI korzystający z TSMC może napotkać problemy z licencjami eksportowymi na narzędzia EDA lub sprzęt. Jak zauważył jeden z ekspertów branżowych, nowe przepisy eksportowe dotyczące chipów AI (szczególnie do Chin) „wpłyną na koszt i dostępność chipów AI na rynku.” techstrong.ai. Otoczenie regulacyjne jest w fazie zmian, a ta niepewność stanowi wyzwanie. Dodatkowo, napięcia polityczne (np. wokół Tajwanu) rzucają cień – konflikt lub sankcje mogłyby poważnie zakłócić łańcuch dostaw. To napędza wysiłki na rzecz regionalnej samowystarczalności (USA przenoszą część produkcji chipów na własne terytorium, Chiny robią to samo, Europa dąży do zwiększenia mocy produkcyjnych) nextmsc.com eetimes.eu. W krótkim okresie firmy często muszą przeprojektowywać lub zmieniać specyfikację produktów, aby spełnić wymogi (jak NVIDIA A800 dla Chin), co wiąże się z nakładami inżynieryjnymi i możliwymi kompromisami wydajnościowymi.

- Własność intelektualna i spory patentowe: Wraz z rozgrzewaniem się rynku chipów AI, nasilają się także spory dotyczące własności intelektualnej. Ugruntowane firmy półprzewodnikowe posiadają obszerne portfele patentowe dotyczące architektur GPU, metod dostępu do pamięci itp. Nowi gracze ryzykują naruszenie tych patentów – świadomie lub nieświadomie – co może prowadzić do pozwów sądowych. Spory patentowe mogą być poważnym obciążeniem – są kosztowne, czasochłonne i mogą opóźniać wprowadzenie produktu na rynek lub wymuszać zmiany w projekcie. Na przykład, NVIDIA pozwała Habana firmy Intel (a wcześniej innych rywali) za domniemane naruszenia własności intelektualnej, co zakończyło się ugodą i opłatami licencyjnymi techstrong.ai. Zdarzały się także przypadki, gdy startupy pozywały się nawzajem lub podkradały sobie pracowników, co prowadziło do sporów o tajemnice handlowe. To prawne pole minowe stanowi wyzwanie zwłaszcza dla startupów, które mogą nie mieć środków na długotrwałe procesy. Problemy z własnością intelektualną mogą również odstraszać inwestorów lub potencjalnych nabywców (nikt nie chce kupować firmy uwikłanej w procesy sądowe). Ponadto, nakładające się prawa własności intelektualnej mogą komplikować partnerstwa – np. licencjonowanie rdzeni IP kontra rozwijanie własnych rozwiązań. Ostrzeżenie od analityków: „Rosnące spory o własność intelektualną i patenty utrudniają rozwój i dystrybucję chipów AI oraz mogą ograniczyć wzrost rynku” techstrong.ai. Poruszanie się po gąszczu patentowym (lub zawieranie umów cross-licencyjnych) będzie stałym zadaniem dla graczy rynkowych.

- Konsolidacja rynku i ryzyka biznesowe: Przy dziesiątkach startupów wchodzących do gry, nie wszystkie przetrwają – można się spodziewać konsolidacji. Już widzieliśmy pierwsze ofiary (Wave Computing, wczesny jednorożec AI chipów, zbankrutował; Graphcore musiał zwolnić pracowników z powodu opóźnień; inni mali gracze zmienili profil działalności). Istnieje ryzyko cyklu boom-bust: ogromne oczekiwania napędzają wielu nowych graczy, po czym następuje selekcja, w której tylko nieliczni zdobywają większość rynku. Jeśli główny gracz (jak NVIDIA) nadal będzie znacząco przewyższał konkurencję, klienci mogą nie przyjąć alternatywnych rozwiązań, co spowoduje wyschnięcie finansowania dla rywali. Dodatkowo, duzi klienci (chmury) mogą strategicznie wspierać wielu dostawców, by uniknąć uzależnienia od jednego, ale jeśli alternatywy będą zbyt słabe, rynek może przechylić się na korzyść jednego lub dwóch zwycięzców. Dla startupów i mniejszych firm wyzwaniem jest udowodnienie nie tylko jakości chipu, ale także długowieczności (mapa drogowa, wsparcie, skalowanie produkcji), by przekonać klientów do zaryzykowania współpracy. Wiele przedsiębiorstw wybierze bezpieczną opcję (NVIDIA lub innego uznanego dostawcę), chyba że nowy chip zaoferuje np. 10× lepszą wydajność/koszt dla ich obciążenia – to bardzo wysoka poprzeczka. Oznacza to, że nowi gracze muszą albo celować w niszowe zastosowania, gdzie mogą być wyraźnie lepsi, albo współpracować z większymi firmami, by uzyskać dostęp do rynku (np. poprzez umowy OEM). Najbliższe lata prawdopodobnie oddzielą tych z naprawdę wyróżniającą się technologią lub wykonaniem od tych, którzy nie nadążą, prowadząc do przejęć lub wyjść z rynku. Taka konsolidacja może zmniejszyć konkurencję, co paradoksalnie może spowolnić innowacje lub utrzymać wyższe ceny.

- Zgodność z przepisami (specyficzne dla AI): Choć nie jest to bezpośrednio problem sprzętowy, pojawiające się regulacje dotyczące AI (takie jak unijny AI Act) mogą pośrednio wpływać na rynek sprzętu. Na przykład, jeśli niektóre zastosowania AI będą regulowane lub będą wymagały wyjaśnialności, mogą pojawić się nowe wymagania wobec układów scalonych, aby obsługiwały rejestry audytowe lub tryby bezpiecznej pracy. Przepisy dotyczące prywatności danych mogą zachęcać do przetwarzania na urządzeniu (co sprzyja chipom edge), ale także ograniczać scentralizowane wykorzystanie danych (co potencjalnie może osłabić wzrost AI w chmurze). Przepisy środowiskowe mogą zmusić centra danych do większej efektywności energetycznej lub ograniczenia zużycia energii, co z kolei wymusza wdrażanie bardziej wydajnych akceleratorów (co jest korzystne dla nowszych chipów, a niekorzystne dla starszego sprzętu). Kontrole eksportowe omówiliśmy w kontekście geopolityki – są one w istocie środkami regulacyjnymi kształtującymi, kto może sprzedawać co komu. Innym aspektem jest prawo antymonopolowe i konkurencyjne: regulatorzy mogą przyglądać się, czy jedna firma (np. NVIDIA) nie staje się zbyt dominująca na rynku chipów AI, co może wpłynąć na fuzje (jak zablokowanie przejęcia ARM przez NVIDIA) lub praktyki (zapewnienie uczciwego dostępu do własności intelektualnej). Choć to spekulacje, te czynniki oznaczają, że branża chipów AI nie działa w próżni i musi dostosowywać się do zmieniającego się krajobrazu przepisów i norm dotyczących wdrażania AI.

Krótko mówiąc, choć rynek akceleratorów AI znajduje się na silnej ścieżce wzrostu, musi pokonać znaczące wyzwania – od ograniczeń fizycznych i problemów z podażą po konkurencyjne i regulacyjne przeszkody. To, jak branża sobie z nimi poradzi, wpłynie na to, którzy gracze odniosą sukces i jak płynnie technologia AI będzie mogła się dalej rozwijać. Historycznie branża technologiczna radziła sobie z podobnymi wyzwaniami (np. spowolnienie prawa Moore’a, spory handlowe), często dzięki innowacjom i współpracy. Prawdopodobnie zobaczymy działania takie jak nowe partnerstwa produkcyjne, standardy upraszczające przenośność oprogramowania AI oraz dalszą współpracę rządu z przemysłem w celu złagodzenia tych ograniczeń.

Trendy technologiczne kształtujące przyszłość

Szybka ewolucja chipów akceleratorów AI napędzana jest kluczowymi trendami technologicznymi i innowacjami, które kształtują sposób projektowania, produkcji i wykorzystywania układów scalonych. Oto niektóre z najważniejszych trendów od 2025 do 2030 roku:

- Postępy w technologii procesów półprzewodnikowych: Marsz w dół zgodnie z prawem Moore’a trwa (choć z większymi trudnościami). Do 2025 roku branża będzie przechodzić z węzłów 5nm/4nm na procesy 3nm, a nawet 2nm dla najbardziej zaawansowanych układów scalonych. Proces 2nm firmy TSMC ma rozpocząć produkcję w 2025 roku, wykorzystując nowatorskie tranzystory nanosheet (GAAFET) dla lepszej efektywności energetycznej nextmsc.com. Dla akceleratorów AI przejście na mniejsze tranzystory oznacza, że na chipie można zmieścić więcej rdzeni i pamięci lub alternatywnie uzyskać tę samą moc obliczeniową w mniejszej, bardziej energooszczędnej formie. Na przykład, układ AI oparty na 2nm w latach 2026–2027 mógłby potencjalnie zawierać biliony tranzystorów, umożliwiając większe pamięci podręczne na chipie lub więcej jednostek mnożenia macierzy specjalnie dla AI. Te zmniejszenia węzłów przyniosą poprawę wydajności na wat, co jest kluczowe, gdy zapotrzebowanie na moc obliczeniową AI gwałtownie rośnie. Jednakże zwiększają one również złożoność projektowania i koszty. Możemy zobaczyć mniej nowych projektów na każdym nowym węźle, skupiających się na układach o dużym wolumenie lub wysokiej wartości (GPU, ASIC-i do centrów danych), podczas gdy układy AI dla urządzeń brzegowych/konsumenckich mogą pozostawać o jeden lub dwa węzły w tyle, jeśli zapewnia to lepszy kompromis kosztowy. Niezależnie od tego, wprowadzenie układów 3nm i 2nm w latach 2025–2027 prawdopodobnie będzie punktem zwrotnym dla AI – umożliwiając na przykład układy do wnioskowania AI w telefonach, które dorównują możliwościom GPU z lat 2020., lub układy do trenowania, które skracają zadania trwające cały dzień do kilku godzin. Poza 2nm trwają badania nad technologiami postkrzemowymi (takimi jak tranzystory z nanorurek węglowych czy nawet akceleratory kwantowe dla AI), ale nie oczekuje się, by stały się one powszechne do 2030 roku. Zamiast tego zobaczymy, jak coraz większe znaczenie zyskuje skalowanie 3D (przechodzenie w górę, ponieważ skalowanie 2D zwalnia).

- Chiplet i integracja heterogeniczna: Jednym z głównych trendów jest rozbijanie dużych układów scalonych na mniejsze chiplet i następnie łączenie ich razem w zaawansowanych modułach. Już teraz widać to w produktach takich jak MI300 firmy AMD, który łączy wiele chipletów GPU i CPU, czy GPU Ponte Vecchio firmy Intel, który wykorzystuje Foveros/EMIB do integracji wielu płytek. Chiplet umożliwiają projektantom mieszanie i dopasowywanie technologii – np. użycie najnowocześniejszego procesu dla rdzeni, ale tańszego procesu dla układów I/O lub analogowych – optymalizując w ten sposób koszty i uzysk. Dla akceleratorów AI to przełom: zamiast jednego monolitycznego układu scalonego (który napotyka problemy z uzyskiem wraz ze wzrostem rozmiaru), chiplet pozwalają na skalowanie przez dodawanie kolejnych „płytek”. Przykładowo, przyszłe akceleratory mogą mieć dziesiątki małych chipletów rdzeni AI na interposerze, działających jak jeden ogromny układ. Przełączniki NVLink lub zastrzeżone łącza o wysokiej przepustowości mogą łączyć chiplet prawie z prędkościami wewnątrz układu. Widzimy także integrację heterogeniczną w pakowaniu różnych typów układów: pamięci i logiki. Najnowsze GPU często mają stosowane HBM (High-Bandwidth Memory) współpakowane na tym samym podłożu, co drastycznie zwiększa przepustowość pamięci (wiele TB/s) dostępną dla procesorów AI globenewswire.com. Patrząc w przyszłość, firmy opracowują jeszcze ściślejszą integrację, jak układanie 3D logiki na logice (umieszczanie mniejszych układów obliczeniowych na większym układzie bazowym) oraz logiki na pamięci (koncepcje przetwarzania w pamięci). Do 2030 roku możliwe, że będziemy mieć układy AI, w których SRAM lub DRAM będą warstwowo umieszczone bezpośrednio nad jednostkami obliczeniowymi, skracając ścieżki danych – to może złagodzić wąskie gardło pamięci dla dużych modeli AI. Krótko mówiąc, zaawansowane pakowanie staje się równie ważne jak zmniejszanie tranzystorów dla wzrostu wydajności, umożliwiając powstawanie „układów”, które są w rzeczywistości modułowymi zespołami wyspecjalizowanych elementów. Ta modułowość sprzyja także personalizacji – np. dostawca chmury może zamówić projekt oparty na chipletach dostosowany do swoich potrzeb (niektóre rdzenie zoptymalizowane pod transformatory, inne pod modele rekomendacyjne itd.).

- Specjalistyczne architektury dla AI: Wczesne akceleratory AI wykorzystywały istniejące projekty GPU lub DSP i dostosowywały je do nowych zadań. Obecnie obserwujemy architektury budowane od podstaw z myślą o AI. Obejmuje to Tensor Cores (jednostki macierzowe NVIDIA), które znacznie przyspieszają mnożenie macierzy, systolic arrays (stosowane w Google TPU), które efektywnie przesyłają dane do gęstej algebry liniowej, oraz nowatorskie architektury przepływu danych (jak podejście SambaNova czy Graphcore), których celem jest minimalizacja ruchu danych. W miarę jak algorytmy AI się różnicują, możemy zobaczyć więcej akceleratorów specyficznych dla danej dziedziny: na przykład układy zoptymalizowane pod kątem modeli transformerowych (które mogłyby wydajniej obsługiwać mechanizmy uwagi), lub takie dla grafowych sieci neuronowych (z obsługą rzadkich obliczeń). Rzeczywiście, niektóre startupy badają architektury rekonfigurowalne, które mogą dostosować się do typu modelu. Chipów neuromorficznych (inspirowanych mózgiem, sieciami neuronowymi z impulsami) to kolejny kierunek, obiecujący ultra niskie zużycie energii przy rozpoznawaniu wzorców, choć pozostają one głównie w fazie badań i mają niewiele komercyjnych wdrożeń. Do 2030 roku oczekuje się, że AI ASIC-y będą obsługiwać większość wyspecjalizowanych zadań inferencyjnych mckinsey.com, jak przewiduje McKinsey, ponieważ te ASIC-y mogą być precyzyjnie dostrojone do swojego zadania w sposób, w jaki ogólne GPU nie mogą. Same GPU ewoluują, by być bardziej ukierunkowane na AI – na przykład nowsze GPU zawierają więcej rdzeni dedykowanych AI, a nawet pewną ilość rekonfigurowalnej logiki podobnej do FPGA dla większej elastyczności. Kolejnym trendem są architektury „fusion”, które łączą różne elementy: chip AIU IBM to na przykład rdzeń AI, który może współistnieć z rdzeniami CPU na jednym układzie scalonym, co sugeruje, że przyszłe CPU mogą mieć solidne koprocesory AI (widzimy tego zapowiedzi w chipach Apple M-series i nadchodzącym Intel Meteor Lake z zintegrowanymi NPU). Podsumowując: innowacje architektoniczne są bardzo dynamiczne i odchodzimy od podejścia „jeden rozmiar dla wszystkich”. Rynek prawdopodobnie podzieli się na układy zoptymalizowane pod trening, układy zoptymalizowane pod inferencję (z podkategoriami dla chmury i edge) oraz układy adaptacyjne do badań, które mogą obsługiwać nowe typy modeli.

- Innowacje w pamięci i połączeniach: Obciążenia AI są znane z dużego zapotrzebowania na pamięć i przepustowość. Trenowanie dużego modelu może wymagać odczytu terabajtów danych i przetwarzania ogromnych macierzy parametrów. Dlatego innowacje w technologii pamięci są kluczowe. Oprócz wspomnianej HBM, trwają prace nad nowymi typami pamięci, takimi jak MRAM czy ReRAM, które mogłyby być zintegrowane na chipie, aby przechowywać wagi bliżej jednostek obliczeniowych. Niektóre startupy (np. Mythic) próbowały obliczeń analogowych w pamięci, przechowując wagi jako wartości analogowe w komórkach flash, aby osiągnąć ogromny poziom równoległości, choć z mieszanym skutkiem. Jednak w miarę jak zbliżamy się do granic DDR i standardowego skalowania DRAM, możemy zobaczyć nowe hierarchie pamięci skoncentrowane na AI: być może większe pamięci podręczne na chipie lub wielopoziomową pamięć z HBM + nowo powstającą pamięcią nieulotną na potrzeby nadmiaru danych. Po stronie połączeń, wyzwaniem jest efektywne łączenie tysięcy akceleratorów. Technologie takie jak NVLink firmy NVIDIA i Infinity Fabric firmy AMD umożliwiają bezpośrednią komunikację GPU-GPU z dużą prędkością, co pozwala na trenowanie dużych modeli na wielu układach scalonych. Przyszłe wersje mogą wykorzystywać optyczne połączenia (Facebook i inni prowadzą badania nad sieciami optycznymi dla klastrów AI), aby zapewnić większą przepustowość i niższe opóźnienia między szafami akceleratorów. Do 2030 roku mogą pojawić się architektury rozdzielone – gdzie pule pamięci i pule obliczeniowe są oddzielne, ale połączone ultraszybkimi łączami, dając akceleratorom dostęp do ogromnej przestrzeni pamięci. Może to być możliwe dzięki technologiom takim jak CXL (Compute Express Link), które umożliwiają współdzielenie pamięci między CPU a akceleratorami. Celem wszystkich tych trendów jest pokonanie „ściany pamięci” i „wąskiego gardła komunikacyjnego” w AI. Można się spodziewać specyfikacji takich jak interfejsy sieciowe 400 Gbit/s na akceleratorach, połączeń fotonowych na opakowaniu oraz kreatywnych rozwiązań pamięciowych w najnowocześniejszym sprzęcie AI.

- Projektowanie chipów AI wspomagane przez AI: Co ciekawe, sama AI pomaga w projektowaniu następnej generacji układów scalonych. Producenci narzędzi EDA i duże firmy wdrażają uczenie maszynowe do optymalizacji projektowania chipów – od planowania rozmieszczenia po weryfikację. Na przykład w 2023 roku Google użyło uczenia ze wzmocnieniem do optymalizacji rozmieszczenia TPU, a NVIDIA zastosowała AI do zadań związanych z układem chipów. Deloitte Insights zauważyło, że kluczowe firmy półprzewodnikowe wydały około 300 mln USD na narzędzia AI do projektowania chipów w 2023 roku, a prognozy mówią o wzroście do 500 mln USD do 2026 roku nextmsc.com. Narzędzia te mogą potencjalnie skrócić czas rozwoju i poprawić wydajność, znajdując nieoczywiste optymalizacje. Powstaje więc pewna pętla sprzężenia zwrotnego: chipy AI umożliwiają lepszą AI, która następnie służy do projektowania lepszych chipów. Pod koniec lat 20. XXI wieku użycie AI w procesie projektowania będzie rutynowe – być może całe bloki będą generowane automatycznie pod określone specyfikacje. Może to nieco obniżyć bariery wejścia lub przynajmniej przyspieszyć cykl iteracji. Może to także umożliwić większą personalizację – np. system AI mógłby automatycznie wygenerować akcelerator dostosowany do obciążenia konkretnej firmy. Jeśli koszty projektowania uda się obniżyć dzięki AI, możemy zobaczyć proliferację półspersonalizowanych chipów (być może z użyciem otwartego sprzętu jak RISC-V jako podstawy, a następnie akceleratorów generowanych przez AI jako „tajny składnik”). Ten trend jest jeszcze w powijakach, ale obiecujący, jeśli chodzi o złagodzenie jednego z problemów rozwoju chipów: długiej, wymagającej dużego nakładu pracy fazy projektowania.

- Skupienie na bezpieczeństwie i niezawodności: Wraz z upowszechnianiem się układów AI (szczególnie w zastosowaniach krytycznych, takich jak samochody, opieka zdrowotna, bezpieczeństwo narodowe), rośnie nacisk na ich funkcje bezpieczeństwa i niezawodności. Obejmuje to m.in.: zapewnienie odporności sprzętu na ataki hakerskie (np. dodanie silników szyfrujących, bezpiecznego rozruchu, wykrywania manipulacji na akceleratorach) oraz na awarie funkcjonalne (szczególnie w motoryzacji układy muszą spełniać rygorystyczne normy bezpieczeństwa, takie jak ISO 26262, z wbudowaną redundancją). Przyszłe akceleratory AI mogą zawierać więcej monitoringu na chipie, korekcji błędów, a nawet narzędzi wyjaśniających (np. rejestrowanie decyzji do późniejszego audytu w zastosowaniach wysokiego ryzyka). Prowadzone są też badania nad sprzętem AI, który może udowodnić określone zachowania (co jest ważne dla zaufania np. w wojskowych lub medycznych urządzeniach AI). Kluczowa jest także odporność – promieniowanie kosmiczne powodujące błędy bitowe może być katastrofalne, jeśli sprawi, że AI zacznie działać nieprawidłowo; dlatego pamięci ECC i odporne na błędy projekty z HPC trafiają do układów AI. Do 2030 roku, jeśli systemy AI zostaną zintegrowane np. z kontrolą kolei czy robotami chirurgicznymi, regulatorzy będą wymagać silnych gwarancji już od poziomu sprzętu. Może to sprzyjać firmom inwestującym w projekty krytyczne dla bezpieczeństwa (przykładem jest EyeQ firmy Mobileye, który zdobył zaufanie dzięki skupieniu na bezpiecznym przetwarzaniu dla ADAS).

- Komputery kwantowe i optyczne (po 2030 roku): Choć prawdopodobnie poza głównym nurtem w latach 2025–2030, warto wspomnieć o nowych paradygmatach, które mogą w przyszłości zrewolucjonizować akceleratory. Obliczenia kwantowe mają potencjał w wybranych problemach optymalizacyjnych i być może w uczeniu maszynowym (kwantowe ML). Firmy takie jak D-Wave i IBM badają metody kwantowe dla AI, ale komputery kwantowe musiałyby się powiększyć o wiele rzędów wielkości, by dorównać klasycznym akceleratorom w większości zadań AI. Bardziej istotne mogą być obliczenia optyczne dla AI – startupy takie jak Lightmatter i LightOn zbudowały optyczne akceleratory sieci neuronowych, które wykorzystują fotony do mnożenia macierzy, celując w bardzo wysoką szybkość i niskie zużycie energii w wybranych zadaniach. Chip fotoniczny Lightmattera podobno może współpracować z konwencjonalną elektroniką, by przyspieszać modele transformerów. To wczesny etap rozwoju i początkowo będą one uzupełniać, a nie zastępować układy elektroniczne. Jeśli dojrzeją, w drugiej połowie lat 30. XXI wieku mogą pojawić się hybrydy: optyczne preprocesory zasilające elektroniczne rdzenie. Dodatkowo, układy neuromorficzne (np. Intel Loihi lub badania BrainChip) oferują przetwarzanie inspirowane mózgiem, co może znaleźć niszę w ultraenergooszczędnej AI na brzegu do 2030 roku. Na razie jednak są to głównie rozwiązania eksperymentalne lub wyspecjalizowane.