- NVIDIA Blackwell B200 ma 180 GB pamięci HBM3e na GPU i maksymalną przepustowość pamięci do 8 TB/s.

- B200 obsługuje nowe precyzje FP4 i FP6 (wyłączając FP8/FP16/TF32), co daje szczytową wydajność tensorową do 18 PFLOPS FP4.

- Układ jest modułowy (chiplet) i wykorzystuje Transformer Engine, co zwiększa możliwości AI przy niższych precyzjach.

- Pojedynczy B200 zużywa około 1,5 kW, a konfiguracja DGX B200 z 8 kartami pobiera około 14,3 kW.

- NVIDIA twierdzi, że DGX B200 zapewnia 3× wydajności w treningu i 15× w inferencji w zintegrowanych przepływach w porównaniu z DGX H100.

- W testach MLPerf 8× B200 osiąga 3,1× wyższą przepustowość w inferencji Llama-2 70B niż system H100.

- Główne systemy end-to-end oparte na B200, takie jak GB200 (Grace+Blackwell), odnotowały 30× wzrost całkowitej przepustowości w testach modelu 405B.

- AMD Instinct MI350X/MI355X oferują 288 GB pamięci HBM3e i do 8 TB/s przepustowości, z obsługą formatów FP4/FP6 i redukcją wydajności FP64 w MI350/MI300X na rzecz AI.

- MI355X pobiera około 1,4 kW, MI350X około 1,0 kW, a konfiguracje 2P/4P umożliwiają dużą pojemność i skalowalność w centrach danych.

- Cena MI355X wynosi około 25 tys. USD za GPU (początkowo ~15 tys. USD, później podnoszone do ~25 tys.), podczas gdy NVIDIA B200 kosztuje około 30–40 tys. USD za sztukę.

- Google TPU v6e, kod Trillium, to pojedynczy chip 918 TFLOPS BF16 i 1 836 TOPS INT8, z 32 GB pamięci HBM i 1,6 TB/s przepustowości na chip, przy 256-chipowym podzie teoretycznie 234,9 PFLOPS BF16 i ponad 1 exaOP/s INT8 na pod.

Wyścig o dominację w dziedzinie akceleratorów AI osiągnął punkt kulminacyjny w latach 2024–2025. NVIDIA, AMD i Google zaprezentowały najnowocześniejszy sprzęt, odpowiadający na rosnące zapotrzebowanie na generatywną sztuczną inteligencję, duże modele językowe (LLM) oraz obliczenia o wysokiej wydajności (HPC). Nowy Blackwell B200 GPU od NVIDIA, seria Instinct MI350 od AMD oraz TPU v6e „Trillium” od Google są określane jako przełomowe układy, z których każdy przesuwa granice architektury, wydajności i efektywności. Niniejszy raport przedstawia dogłębne porównanie tych trzech akceleratorów – obejmujące ich architekturę, surową wydajność (FLOPS, przepustowość pamięci itp.), efektywność energetyczną, ekosystemy programistyczne, rzeczywiste testy wydajności, scenariusze wdrożeniowe i więcej. Przedstawiamy także komentarze ekspertów, najnowsze wydarzenia oraz rzucamy okiem na plany rozwoju kolejnych generacji, które realizuje każda z firm.

W tym starciu gigantów AI, GPU Blackwell od NVIDIA obiecuje 3× wzrost wydajności w treningu i 15× w inferencji względem swojego poprzednika nvidia.com, MI350 od AMD (architektura CDNA4) oferuje do 4× wyższą moc obliczeniową AI i 35× szybszą inferencję AI niż poprzednia generacja tomshardware.com smbom.com, a TPU v6e od Google zapewnia 4,7× wzrost szczytowej wydajności obliczeniowej oraz podwojoną przepustowość pamięci i połączeń względem poprzednich generacji TPU cloud.google.com cloud.google.com. Poniżej analizujemy każde z tych rozwiązań i porównujemy, jak wypadają na tle konkurencji w dziedzinie akceleracji AI.

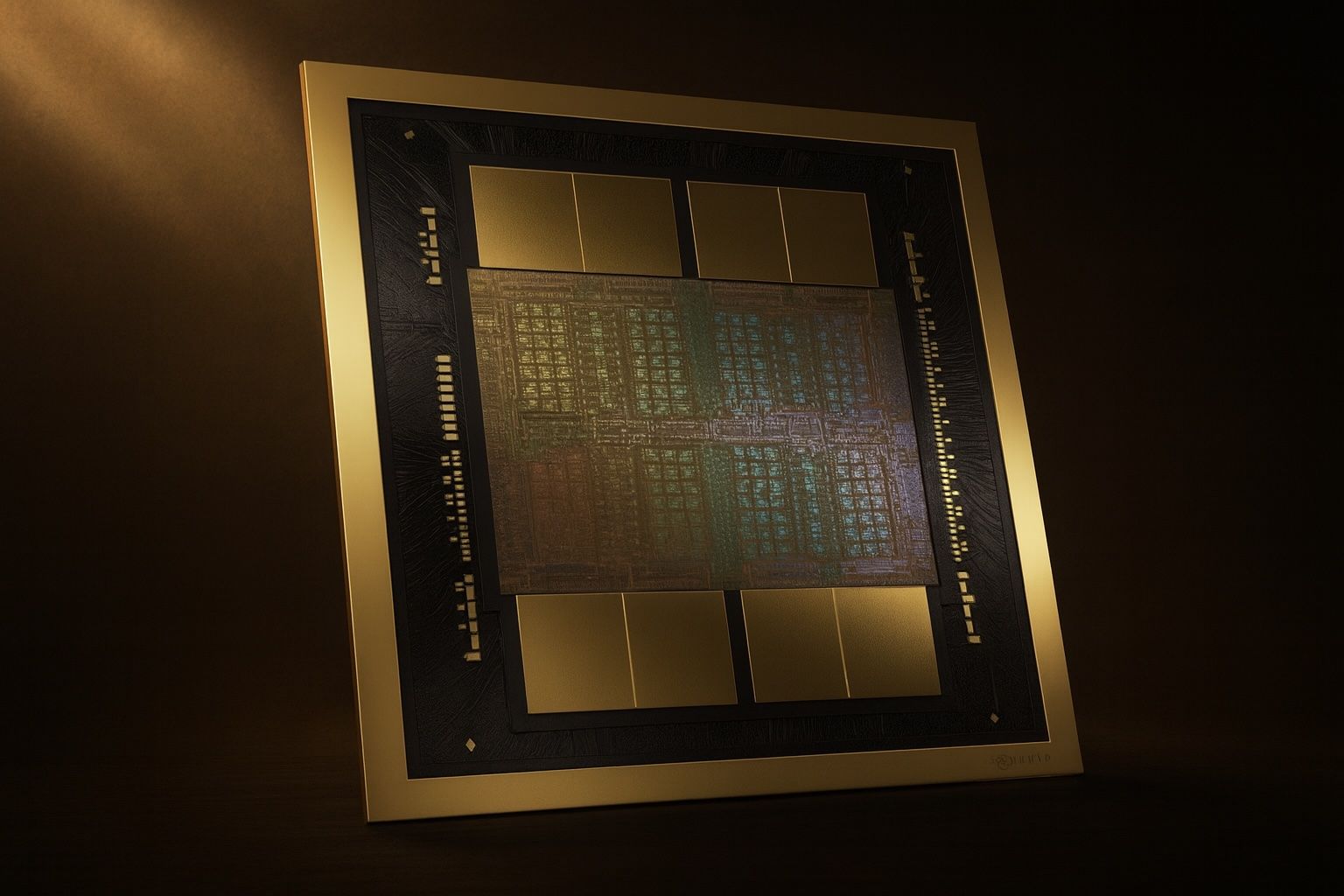

NVIDIA Blackwell B200 – Architektura i wydajność

Innowacje architektoniczne: NVIDIA Blackwell B200 to flagowy model najnowszej architektury GPU firmy NVIDIA, będący następcą Hopper H100. Blackwell wprowadza konstrukcję modułu wieloukładowego (chiplet), znacznie większą pojemność pamięci, nowe formaty matematyki niskiej precyzji oraz szybsze połączenia. Pojedynczy GPU B200 posiada 180 GB pamięci HBM3e (w porównaniu do 80 GB w H100), oferując do 8 TB/s przepustowości pamięci exxactcorp.com exxactcorp.com. Ta ogromna pamięć (180 GB na GPU) umożliwia trenowanie większych modeli lub używanie większych rozmiarów partii, co jest kluczową zaletą, która przyczyniła się do ~57% szybszego trenowania modeli w niektórych zadaniach wizji komputerowej w porównaniu do GPU H100 lightly.ai lightly.ai. Blackwell podwaja również wydajność rdzeni tensorowych dla obliczeń AI: obsługuje nowe precyzje FP4 i FP6 (oprócz FP8/FP16/TF32), wykorzystując drugą generację silnika Transformer do dynamicznego wykorzystywania niższej precyzji dla przyspieszenia obliczeń developer.nvidia.com developer.nvidia.com. Poprzez poświęcenie części wydajności FP64 (kluczowej dla tradycyjnych obliczeń HPC) na rzecz ogromnego zwiększenia wydajności rdzeni tensorowych przy niższych precyzjach, B200 osiąga ponad 2× wyższą wydajność TF32/FP16/INT8 niż Hopper exxactcorp.com exxactcorp.com. W rzeczywistości B200 może wykonać 18 PFLOPS operacji tensorowych FP4 (szczytowo) – to nowy poziom wydajności możliwy dzięki rdzeniom FP4 exxactcorp.com. Układ jest produkowany w najnowocześniejszym procesie technologicznym (prawdopodobnie TSMC 4nm lub 3nm) i zawiera ogromną liczbę tranzystorów (NVIDIA nie podała oficjalnie liczby tranzystorów, ale oczekuje się, że znacznie przekracza ona 80 miliardów w H100). Chłodzenie i dostarczanie zasilania to kluczowe kwestie – karty B200 do centrów danych występują w modułach formatu SXM i mogą pobierać około 1,5 kW każda pod obciążeniem (szacunki na podstawie systemu DGX z 8× B200 zużywającego ~14,3 kW) nvidia.com nvidia.com.

Wydajność i benchmarki: Pod względem surowej wydajności Blackwell B200 to prawdziwy potwór. Oferuje około 4,5 PFLOPS FP16/BF16 oraz 9 PFLOPS FP8 mocy obliczeniowej tensorów, czyli ponad dwukrotnie więcej niż poprzednia generacja exxactcorp.com. W zadaniach inferencyjnych jego przepustowość INT8 wynosi około 9 PetaOps (w porównaniu do ~4 PetaOps w H100) exxactcorp.com, a nowa obsługa FP4 ponownie podwaja przepustowość dla niektórych modeli opartych na Transformerach developer.nvidia.com. Wyniki rzeczywistych benchmarków potwierdzają te specyfikacje. W najnowszych testach MLPerf systemy z GPU Blackwell pobiły rekordy. Ośmioprocesorowy serwer DGX B200 osiągnął 3,1× wyższą przepustowość w benchmarku inferencyjnym Llama-2 70B chatbot w porównaniu do ośmioprocesorowego systemu H200 (Hopper-refresh) developer.nvidia.com. W ogromnym scenariuszu inferencyjnym Llama 3.1 (model o 405 miliardach parametrów) superchip NVIDIA Grace+Blackwell GB200 (łączący 72 GPU Blackwell z 36 CPU Grace w jednym klastrze) zapewnił do 3,4× wyższą wydajność na GPU w porównaniu do systemu opartego na Hopperze developer.nvidia.com developer.nvidia.com. Na poziomie systemu ta konfiguracja GB200 osiągnęła zdumiewający 30× wzrost całkowitej przepustowości w teście modelu 405B, dzięki większej liczbie GPU i sieci NVLink Switch łączącej je ze sobą developer.nvidia.com. Nawet w mniejszych testach użytkownicy z wczesnym dostępem zgłaszają solidne przyrosty: Lightly.ai porównało B200 z H100 na rzeczywistych zadaniach i stwierdziło, że B200 jest około 57% szybszy w zadaniach treningowych mocno obciążających GPU (np. trening komputerowego widzenia YOLOv8) oraz ~10% szybszy w zadaniach inferencyjnych średniej wielkości LLM lightly.ai lightly.ai. Warto zauważyć, że duża pamięć Blackwell (180 GB) pozwala na uruchamianie większych rozmiarów partii, co poprawia przepustowość treningu, a jego nowość oznacza, że oprogramowanie do inferencji jest wciąż optymalizowane – oczekuje się, że ~10% przyspieszenie LLM będzie się zwiększać wraz z dojrzewaniem bibliotek CUDA lightly.ai. NVIDIA sama twierdzi, że DGX B200 zapewnia 3× wyższą wydajność w treningu i 15× wyższą wydajność w inferencji w zintegrowanych przepływach pracy niż systemy DGX H100 nvidia.com, podkreślając szczególną siłę Blackwella w inferencji (prawdopodobnie dzięki akceleracji FP4 i innym optymalizacjom dla modeli transformerowych). Jeśli chodzi o wydajność w stylu HPC z podwójną precyzją (FP64), Blackwell utrzymuje się na poziomie około 30–40 TFLOPS FP64 (podobnie jak H100) exxactcorp.com w operacjach wektorowych, choć przepustowość rdzeni tensorowych FP64 jest zmniejszona w porównaniu do Hopper exxactcorp.com – co wskazuje na strategiczne ukierunkowanie NVIDIA na obciążenia AI kosztem klasycznego HPC w tej generacji.

Wydajność energetyczna: Pomimo wyższej surowej wydajności, Blackwell B200 ma być znacznie bardziej energooszczędny w zadaniach AI. NVIDIA podaje 15× poprawę wydajności inferencji na system (DGX B200 vs DGX H100) przy podobnym limicie mocy nvidia.com. Efektywność architektury (takie jak zoptymalizowane wsparcie dla rzadkości i Transformer Engine) przekłada się na znacznie większą wydajność na wat w zadaniach AI. GPU Blackwell wykorzystują także interkonekty NVLink piątej generacji (900 GB/s na połączenie GPU, 1,8 TB/s łącznie na GPU) exxactcorp.com, co zmniejsza wąskie gardła w przesyłaniu danych i obciążenie CPU. W połączeniu z lepszym zarządzaniem energią daje to znaczne oszczędności energii przy tych samych zadaniach. Na przykład jedna analiza wykazała, że Blackwell zapewnia 25× poprawę efektywności energetycznej w niektórych zadaniach inferencji AI w porównaniu do poprzednika adrianco.medium.com. Należy jednak zauważyć, że całkowity pobór mocy jest wysoki; zapotrzebowanie B200 (do ~1,4 kW na GPU przy dużym obciążeniu) wymaga zaawansowanego chłodzenia. NVIDIA oferuje warianty chłodzone powietrzem i cieczą w zależności od potrzeb wdrożeniowych. Kwestia wydajności względem TCO jest kluczowa – nawet jeśli każdy GPU B200 jest drogi i energochłonny, przepustowość, jaką zapewnia, może zmniejszyć całkowitą liczbę potrzebnych serwerów. NVIDIA podkreśla, że upakowanie większej wydajności w każdej szafie (dzięki potężnym GPU jak B200) ostatecznie obniża koszt i zużycie energii na jednostkę pracy, zwłaszcza przy wdrożeniach na dużą skalę tomshardware.com tomshardware.com. To odpowiada oczekiwaniom użytkowników korporacyjnych: większa gęstość mocy obliczeniowej AI, by zmaksymalizować efektywność centrum danych.

Oprogramowanie i ekosystem: Największą przewagą NVIDIA pozostaje jej stos oprogramowania. Blackwell B200 jest w pełni obsługiwany przez ekosystem oprogramowania CUDA i NVIDIA AI od pierwszego dnia. Programiści mogą korzystać z zoptymalizowanych bibliotek NVIDIA (cuDNN, TensorRT, CUDA-X API itd.) oraz frameworków takich jak TensorRT-LLM do przyspieszonego wnioskowania LLM developer.nvidia.com. W rzeczywistości, możliwość FP4 Blackwella jest udostępniona przez TensorRT i nowe narzędzia do kwantyzacji, co pozwala na uruchamianie modeli z precyzją FP4 przy minimalnej utracie dokładności – kluczowy czynnik tych ogromnych zysków we wnioskowaniu developer.nvidia.com. Trening wielogpu na dużą skalę umożliwia NVLink Switch fabric (NVSwitch), który łączy wszystkie GPU w serwerze lub nawet pomiędzy serwerami (w GB200 pod) jako jeden klaster o wysokiej przepustowości. Obsługiwane są także funkcje takie jak Multi-Instance GPU (MIG), pozwalające na podział B200 na maksymalnie 7 odizolowanych instancji GPU (każda z ok. 23 GB) do obsługi wielu zadań exxactcorp.com. Z punktu widzenia wdrożenia, GPU Blackwell są dostępne w systemach NVIDIA DGX B200 oraz płytach HGX dla producentów serwerów OEM. Główni dostawcy chmury również wprowadzają instancje oparte na Blackwell – NVIDIA zapowiedziała szeroką dostępność u czołowych dostawców chmury w 2024 roku developer.nvidia.com. Oznacza to, że przedsiębiorstwa mogą uzyskać dostęp do wydajności B200 zarówno lokalnie, jak i w chmurze, stosunkowo łatwo. CEO NVIDIA, Jensen Huang, często opisuje ich podejście platformowe jako dostarczanie „pełnego stosu, od krzemu po oprogramowanie” w celu przyspieszenia AI. Blackwell jest tego doskonałym przykładem – to nie tylko układ scalony, ale część zunifikowanej platformy AI z oprogramowaniem i usługami (takimi jak NVIDIA AI Enterprise, frameworki NeMo dla LLM oraz integracje DGX Cloud) nvidia.com nvidia.com. Ten solidny ekosystem daje NVIDIA silną pozycję konkurencyjną, ponieważ programiści mogą łatwo przenosić modele i umiejętności z poprzednich GPU (takich jak H100) na nowy Blackwell przy minimalnych trudnościach.

AMD Instinct MI350 (CDNA 4) – Architektura i wydajność

Innowacje architektoniczne: Seria AMD Instinct MI350 to odpowiedź AMD na Blackwell – rodzina układów GPU do centrów danych oparta na nowej architekturze CDNA 4 oraz zaawansowanej technologii chipletów/3D stacking. Zaprezentowane przez CEO, dr Lisę Su, na Computex 2024, układy MI350 są produkowane w procesie TSMC klasy 3nm (N3P) i zawierają szacunkowo ~185 miliardów tranzystorów w konstrukcji multi-die smbom.com. Podobnie jak poprzednik (seria MI300), MI350 wykorzystuje integrację 3D do połączenia rdzeni obliczeniowych i warstwowanej pamięci HBM. Flagowe modele MI355X oraz jego chłodzony powietrzem odpowiednik MI350X oferują imponujące 288 GB pamięci HBM3e na pokładzie, z całkowitą przepustowością do 8 TB/s tomshardware.com tomshardware.com. To 1,5× więcej pamięci niż NVIDIA B200 (180 GB), co AMD podkreśla – MI355X ma o 60% większą pojemność HBM niż GPU NVIDIA B200/GB200 (288 GB vs ~180 GB) tomshardware.com. Podsystem pamięci jest nie tylko większy, ale i szybszy dzięki HBM3e i poszerzonej magistrali pamięci. Seria MI350 wprowadza także obsługę nowych formatów zmiennoprzecinkowych 4-bitowych i 6-bitowych (FP4 i FP6) sprzętowo, podobnie jak rozwiązanie NVIDIA, by przyspieszyć wnioskowanie AI. Inżynierowie AMD podwoili możliwości obliczeń macierzowych: architektura CDNA 4 zawiera rdzenie macierzowe zoptymalizowane pod niższą precyzję. Co istotne, AMD zdecydowało się zmniejszyć wydajność FP64 w MI350 względem MI300X, przekierowując krzem do jednostek AI – wydajność macierzowa FP64 została zredukowana o połowę, choć operacje wektorowe FP64 spadły tylko o ~4% generacyjnie tomshardware.com tomshardware.com. Wskazuje to na strategiczny zwrot w kierunku obciążeń AI, naśladując podejście NVIDIA. Rdzeń GPU MI350X jest wyłącznie obliczeniowy (w przeciwieństwie do MI300A, który miał CPU+GPU), ponieważ AMD porzuciło podejście APU w tej generacji, by skupić się na konstrukcjach wyłącznie GPU dla maksymalnej skalowalności tomshardware.com. Każdy pakiet MI350X ma format OAM i jest zaprojektowany do gęstej integracji w centrach danych, z opcją ekstremalnego chłodzenia cieczą w topowym MI355X (który ma Całkowitą Moc Płyty do 1 400 W dla maksymalnej wydajności) tomshardware.com tomshardware.com. Chłodzony powietrzem MI350X działa przy niższym poborze mocy (~1 000 W). Oba warianty mają tę samą konstrukcję rdzenia i są kompatybilne pinowo z istniejącymi systemami serii MI300 „Universal Base Board”, co ułatwia modernizacje amd.com.

Wydajność i testy porównawcze: AMD twierdzi, że seria Instinct MI350 będzie generacyjnym skokiem, zwłaszcza w zakresie wnioskowania AI. Według danych AMD, seria MI350 zapewnia 4× wyższą wydajność obliczeniową AI oraz do 35× wyższą przepustowość wnioskowania AI w porównaniu do poprzedniej generacji MI300 (CDNA 3) tomshardware.com tomshardware.com. W wewnętrznych testach AMD pojedynczy MI350X ma przewyższać obecny flagowy model NVIDIA w kluczowych metrykach. Na przykład podczas wydarzenia AMD „Advancing AI 2025” firma stwierdziła, że GPU klasy MI350 osiągają do 1,3× wydajności wnioskowania rozwiązań NVIDIA w testach porównawczych, a nawet prowadzą o ~13% w wybranych zadaniach treningowych tomshardware.com tomshardware.com. Pojawiły się też konkretne porównania w raportach branżowych: analiza HSBC cytowana przez media wskazała, że MI355X przewyższa NVIDIA B200 w niektórych zadaniach wnioskowania na dużych modelach – około 20% szybciej w zadaniu DeepSeek R1 FP4 oraz 30% szybciej w teście Llama 3.1-405B LLM (dorównując wydajności ogromnego systemu NVIDIA GB200) smbom.com smbom.com. To odważne twierdzenia sugerujące, że AMD jest konkurencyjne na czołówce wnioskowania LLM. Surowe dane z Tom’s Hardware to potwierdzają: pojedynczy MI355X może osiągnąć 10 PFLOPS obliczeń macierzowych w FP4/FP6 (lub 20 PFLOPS z włączoną rzadkością), podczas gdy MI350X osiąga maksymalnie około ~5 PFLOPS FP16 i ~10 PFLOPS FP8 tomshardware.com tomshardware.com. W porównaniu z NVIDIA, AMD podaje, że MI355X oferuje około 2× szczytowej przepustowości FP64/FP32 względem Blackwell (ponieważ NVIDIA je obniżyła) tomshardware.com. Przy niższej precyzji, takiej jak FP16/FP8/FP4, przepustowość pojedynczego GPU AMD jest podobna do Blackwella – MI350X wydaje się „dorównywać lub nieznacznie przewyższać porównywalne układy Nvidii” w większości przypadków tomshardware.com tomshardware.com. Jednym z wyróżniających się formatów jest FP6: architektura AMD może obsługiwać FP6 z taką samą szybkością jak FP4, co firma przedstawia jako wyróżnik dla niektórych modeli tomshardware.com. W przypadku zadań ograniczonych przez pamięć, ogromna pula HBM3e w MI355X może zabłysnąć: AMD twierdzi, że ich akcelerator o pojemności 288 GB może wygenerować o 40% więcej tokenów LLM na dolara niż B200 od NVIDIA, częściowo dzięki obsłudze większych okien kontekstowych lub rozmiarów partii bez przepełnienia smbom.com smbom.com. Będziemy musieli poczekać na niezależne wyniki MLPerf, aby uzyskać pełne potwierdzenie – pod koniec 2024 roku sprzęt MI350 dopiero wchodzi na rynek – ale wstępne sygnały wskazują, że AMD zdecydowanie liczy się w wyścigu o szkolenie i wnioskowanie AI na dużą skalę. Warto zauważyć, że akceleratory z serii MI350 są kluczowe dla nadchodzącego El Capitan – superkomputera eksaskalowego i innych systemów HPC, więc ich wydajność FP64 i w precyzji mieszanej będzie również testowana w zastosowaniach naukowych. (AMD tradycyjnie przoduje w wydajności GPU FP64; np. wcześniejszy MI250X oferował ~47,9 TFLOPS FP64, znacznie powyżej 9,7 TFLOPS NVIDIA A100, a seria MI300 kontynuowała ten trend). Dzięki MI350 AMD równoważy tę siłę HPC z ogromnymi zyskami wydajności AI.

Wydajność energetyczna: Dzięki zaawansowanemu procesowi 3 nm i ulepszeniom architektury, seria MI350 ma być niezwykle energooszczędna pod względem wydajności AI – choć przy wysokim całkowitym poborze mocy. AMD podaje 35× poprawę wydajności inferencji na wat w porównaniu z poprzednią generacją, co częściowo wynika z użycia formatów danych INT4/FP4, które po prostu wykonują więcej operacji na dżul amd.com amd.com. MI350X oferuje znacznie większą wydajność na kartę niż jego poprzednicy, co powinno przełożyć się na lepszą efektywność na poziomie szafy serwerowej. Jednak flagowy MI355X pobiera 1,4 kW mocy, czyli prawie dwa razy więcej niż MI300X (750 W) tomshardware.com. Argument AMD jest taki, że ten wyższy limit mocy zwraca się w gęstości: jeden MI355X zapewnia tak dużą wydajność, że ogólnie potrzeba mniej GPU, co ostatecznie poprawia wydajność na TCO (całkowity koszt posiadania) na poziomie centrum danych tomshardware.com tomshardware.com. Innymi słowy, można wdrożyć jedną szafę z węzłami MI355X zamiast dwóch szaf z mniej wydajnym akceleratorem, oszczędzając na chłodzeniu, sieci i kosztach infrastruktury przy tej samej wykonanej pracy. AMD podkreśla również zyski wydajnościowe swojej architektury CDNA4: przejście na 3 nm, zastosowanie zaawansowanego pakietowania oraz wprowadzenie nowych instrukcji dla AI znacząco zwiększyły wydajność na wat. Na przykład MI350 wykorzystuje nowsze formaty niskiej precyzji (FP4/FP6), które znacznie zmniejszają zapotrzebowanie na przepustowość pamięci i pojemność magazynową dla danego modelu, bezpośrednio obniżając zużycie energii na inferencję. Rozwiązania chłodzące (ciecz dla MI355X) zapewniają, że GPU mogą utrzymywać wysokie taktowania bez throttlingu. Wszystko to sugeruje, że AMD zaprojektowało MI350 nie tylko po to, by konkurować pod względem surowej szybkości, ale także pod względem przepustowości na dolara i na wat. Komentarze kadry zarządzającej to potwierdzają: „Jesteśmy nieustępliwi w tempie innowacji, dostarczając wiodące możliwości i wydajność, jakich oczekuje branża AI, aby napędzać kolejną ewolucję trenowania i inferencji AI w centrach danych” – powiedział Brad McCredie, wiceprezes AMD ds. przyspieszonego przetwarzania, podkreślając nacisk na wartość i wydajność razem tomshardware.com.

Ekosystem oprogramowania i przypadki użycia: Historycznie oprogramowanie było dla AMD trudnym polem w obszarze AI, ale firma poczyniła znaczące postępy dzięki otwartemu stosowi oprogramowania ROCm. Do czasu szerokiej premiery MI350 (oczekiwanej w 2025 roku), platforma i biblioteki ROCm 6+ AMD będą już dojrzałe, z obsługą głównych frameworków (PyTorch, TensorFlow, JAX) oraz bibliotek modeli. W rzeczywistości AMD nawiązało współpracę z firmami takimi jak Hugging Face, aby proaktywnie testować setki tysięcy popularnych modeli AI na sprzęcie z serii MI300, zapewniając ich natychmiastowe działanie na GPU AMD amd.com amd.com. Tego typu wsparcie programowe jest kluczowe dla zaufania klientów. AMD zintegrowało także obsługę popularnych optymalizacji transformerów – np. oprogramowanie do wykorzystywania FP8/FP4 oraz narzędzia ułatwiające portowanie kodu CUDA do HIP (równoległe API programistyczne AMD). Chociaż NVIDIA wciąż przoduje pod względem dopracowania oprogramowania, AMD pozycjonuje MI350 jako realną alternatywę dla dostawców chmurowych i dużych przedsiębiorstw, które chcą zdywersyfikować swój sprzęt AI. Warto zauważyć, że Microsoft Azure, Meta (Facebook) oraz główni producenci OEM (Dell, HPE, Lenovo) już współpracują z akceleratorami MI300X tomshardware.com tomshardware.com i prawdopodobnie będą kandydatami do wdrożenia MI350 po 2025 roku. Na przykład Azure oferuje instancje AI z MI300A/X dla usług OpenAI, a Meta zatwierdziła MI300 do własnych obciążeń tomshardware.com. Oczekuje się, że ta dynamika utrzyma się w generacji CDNA4. AMD bada także partycjonowanie i skalowanie wielu GPU podobnie jak NVSwitch NVIDII – karty MI350 wykorzystują ten sam format UBB, który obsługuje łącza Infinity Fabric AMD między GPU. Chociaż szczegóły są skąpe, przecieki sugerują, że AMD może umożliwić duże konfiguracje (np. Instinct MI450X z IF128 fabric łączącym wiele GPU w 2026 roku) tomshardware.com tomshardware.com. Na razie MI350X można używać w konfiguracjach 2P lub 4P GPU z szybkimi połączeniami. Główne przypadki użycia MI350 obejmą zarówno AI, jak i HPC: trenowanie ogromnych LLM, wdrażanie iwnioskowanie dla modeli takich jak ChatGPT czy generatory obrazów oraz przyspieszanie symulacji naukowych (modelowanie klimatu, fizyka itp.), które coraz częściej łączą AI z tradycyjnymi obliczeniami. Dzięki mocnemu FP64 i ogromnej pamięci, MI350 może obsługiwać symulacje HPC lub dużą analizę grafów wymagającą wysokiej precyzji i pamięci, a jednocześnie efektywnie trenować sieci neuronowe w tym samym systemie. Ta elastyczność, jeśli zostanie dostarczona, może sprawić, że rozwiązanie AMD będzie atrakcyjne zarówno dla laboratoriów narodowych, jak i gigantów chmurowych. Jeśli chodzi o ceny, AMD działa agresywnie: według doniesień AMD początkowo wyceniło MI350X na około 15 tys. dolarów, ale widząc duży popyt, podniosło cenę do ~25 tys. dolarów – wciąż nieco mniej niż odpowiednik NVIDIA, który kosztuje w przedziale 30–40 tys. dolarów smbom.com smbom.com. Analitycy postrzegają to jako znak, że AMD jest pewne wartości MI350 w porównaniu do Blackwell firmy NVIDIA. Jak zauważył jeden z portali technologicznych, „AMD uważa, że wydajność MI350 może dorównać Nvidia Blackwell B200, a mimo podwyżki cen MI350 pozostaje bardziej przystępny cenowo niż oferta Nvidii.” smbom.com smbom.com.Google TPU v6e „Trillium” – Architektura i wydajność

Przegląd architektury: TPU v6e firmy Google, o nazwie kodowej Trillium, to szósta generacja zastrzeżonego przez Google procesora Tensor Processing Unit – akceleratora AI typu ASIC zaprojektowanego specjalnie do trenowania i wnioskowania sieci neuronowych. Ogłoszone na Google I/O 2024, Trillium TPU zostały stworzone, aby zmaksymalizować wydajność na wydanego dolara w docelowych obciążeniach Google (duże transformatory, modele rekomendacyjne itp.) w Google Cloud. Pod względem architektury, chip TPU v6e znacznie różni się od GPU: zawiera jeden ogromny TensorCore, w którym znajdują się dwie jednostki mnożenia macierzy (MXU) wraz z jednostkami wektorowymi i skalarnymi cloud.google.com cloud.google.com. Te MXU implementują ogromne tablice systoliczne do obliczeń macierzowych, dostosowane do obliczeń BF16 (bfloat16) i INT8 (TPU historycznie nie obsługują natywnie arytmetyki FP32/FP64, aby oszczędzać krzem). Wraz z Trillium Google znacząco powiększyło rdzeń: MXU w v6e są większe i pracują z wyższymi częstotliwościami zegara niż w poprzednich TPU cloud.google.com. Efektem jest 4,7-krotny wzrost szczytowej mocy obliczeniowej na chip w porównaniu do poprzedniej generacji Cloud TPU v5e cloud.google.com cloud.google.com. Konkretne liczby: pojedynczy chip TPU v6e dostarcza 918 TFLOPS BF16 w szczycie (wzrost z ok. 197 TF w v5e) oraz około 1,836 POPS (PetaOPS) INT8 przepustowości cloud.google.com cloud.google.com. Każdy chip wyposażony jest w 32 GB pamięci High Bandwidth Memory (HBM2e/HBM3) – dwa razy więcej niż 16 GB w v5e cloud.google.com cloud.google.com. Przepustowość pamięci na chip również się podwoiła do 1,6 TB/s cloud.google.com cloud.google.com. Choć 32 GB na chip może wydawać się niewielkie w porównaniu do pamięci GPU, TPU są przeznaczone do pracy w klastrach, a Google podwoiło także przepustowość Inter-Chip Interconnect (ICI) (z 1 600 Gbps do 3 200 Gbps na chip) cloud.google.com cloud.google.com. Każdy chip v6e ma 4 łącza ICI tworzące topologię torusa 2D z maksymalnie 256 chipami w jednym TPU pod cloud.google.com cloud.google.com. Zasadniczo filozofia projektowa Google polega na użyciu wielu umiarkowanie dużych chipów współpracujących ze sobą, zamiast jednego ogromnego układu scalonego. Standardowy Cloud TPU v6e pod składa się z 256 chipów (rozmieszczonych na 32 maszynach hosta po 8 chipów każda), wszystkie ściśle połączone w celu wspólnego trenowania bardzo dużych modeli cloud.google.com cloud.google.com. Google wprowadziło także 3. generację SparseCore w Trillium – specjalizowany koprocesor na każdym chipie, przeznaczony do przyspieszania dużych obciążeń związanych z embeddingami i rekomendacjami (poprzez bardziej efektywne obsługiwanie rzadkich odwołań do danych) cloud.google.com cloud.google.com. Rozwiązuje to przypadki użycia takie jak ranking, embeddingi do wyszukiwania/reklam itp., które są kluczowe dla działalności Google. Warto zauważyć, że TPU tradycyjnie operują na niższej precyzji numerycznej; v6e obsługuje bfloat16 i INT8, a pojawiają się sugestie, że może obsługiwać eksperymentalne formaty float 8-bitowe lub 4-bitowe, choć Google nie podało oficjalnych szczegółów na ten temat nextplatform.com nextplatform.com. (The Next Platform spekulował, że FP8/FP4 mogą zostać dodane do Trillium, aby nadążyć za trendami branżowymi nextplatform.com.) Proces technologiczny i pobór mocy dla TPU v6e nie zostały publicznie ujawnione, ale biorąc pod uwagę wzrost wydajności, prawdopodobnie wykorzystuje proces 5 nm lub 4 nm. Każdy chip może zużywać około ~200–250 W (poprzednie chipy TPU v4 zużywały ~175 W), ale dokładne dane nie są ujawnione. Google podkreśliło 67% lepszą efektywność energetyczną w v6e w porównaniu do v5e cloud.google.com cloud.google.com, wskazując na znacznie większą wydajność na wat.

Wydajność i skalowalność: Pojedynczy chip TPU v6e zapewnia około 0,918 PFLOPS (918 TF) BF16 i może być masowo klastrowany, dlatego wydajność jest zwykle omawiana w skali całego poda. Pełny pod (256 chipów) ma teoretyczny szczyt ~234,9 PFLOPS BF16 łącznie i ponad 1 exaOP/s INT8 cloud.google.com cloud.google.com. W praktyce Google wykazało imponującą wydajność rzeczywistą z Trillium. Wewnętrzne modele Google, takie jak Gemini 1.5 (model bazowy nowej generacji) oraz Imagen 3 (generator obrazów), były trenowane na sprzęcie TPU v6 cloud.google.com. Google twierdzi, że te TPU umożliwiają trenowanie „kolejnej fali modeli bazowych szybciej oraz ich obsługę przy niższych opóźnieniach i kosztach” cloud.google.com cloud.google.com. Na przykład, w jednym publicznym przykładzie, Google zauważyło, że przejście z TPU v5e na v6e dało 4,7× przyspieszenie w zadaniu opartym na transformatorach na poziomie chipu cloud.google.com. Innym kluczowym wskaźnikiem jest wydajność względem TCO – Google podaje, że v5e to 0,65×, a v6e to 1,0 (bazowy) w wydajności/TCO, co oznacza, że v6e zapewnia ~54% lepszą przepustowość na dolara niż v5e w ich wdrożeniach chmurowych cloud.google.com cloud.google.com. Podwojenie pamięci i przepustowości komunikacji oznacza, że v6e może efektywnie obsługiwać znacznie większe modele. Przy 32 GB na chip (i 8 chipów na hosta), każdy host TPU ma łącznie 256 GB HBM, a cały pod z 256 chipami ma 8 TB HBM rozłożone w siatce – co efektywnie umożliwia trenowanie modeli z dziesiątkami miliardów parametrów w trybach data-parallel lub model-parallel. Jeśli chodzi o benchmarki, Google zazwyczaj nie zgłasza TPU do MLPerf, ale istnieją porównania anegdotyczne. TPU v4 był mniej więcej porównywalny z NVIDIA A100 w niektórych zadaniach (przynajmniej w skali podów), a TPU v5e był wersją zoptymalizowaną pod kątem kosztów TPU v5. v6e „Trillium” wydaje się niwelować dużą część różnicy względem Hopper/Blackwell od NVIDIA pod względem surowej mocy obliczeniowej: np. 918 TF BF16 to poziom zbliżony do NVIDIA H100 (~1 000 TF FP16), choć pojedynczy Blackwell B200 z ~4 500 TF16 jest znacznie wyżej. Jednak Google może wdrożyć 256 takich chipów (lub nawet większe klastry multi-pod z optycznymi interkonektami cloud.google.com), osiągając wydajność dorównującą superkomputerom. Google informuje również, że TPU v6e jest o 67% bardziej energooszczędny niż v5e przy tej samej pracy cloud.google.com, co jest kluczową statystyką dla obniżenia kosztów chmury. W praktyce oznacza to, że zadania takie jak obsługa dużego modelu językowego mogą być realizowane przy znacznie niższym zużyciu energii, co przekłada się na oszczędności dla Google i jego klientów Cloud TPU. Trzecia generacja SparseCore Trillium znacznie zwiększa przepustowość w systemach rekomendacyjnych – to obszar, w którym GPU często mają trudności z powodu operacji rzadkich ograniczonych przez pamięć. Dzięki przeniesieniu wyszukiwań osadzania do SparseCore, Google deklaruje duże zyski dla takich zastosowań jak modele rankingowe reklam cloud.google.com cloud.google.com. Ogólnie rzecz biorąc, wydajność TPU v6e jest precyzyjnie ukierunkowana na modele transformer, CNN i osadzenia. Prawdopodobnie nie obsługuje FP32/FP64, więc nie byłby używany do ogólnych zadań HPC, ale do trenowania AI na dużą skalę jest jednym z najlepszych – Google nazwało go „naszym najwydajniejszym i najbardziej energooszczędnym TPU w historii” cloud.google.com.

Wydajność i wdrożenie: Strategia Google dotycząca TPU polega na maksymalizacji przepustowości na dolara w chmurze. Trillium TPU jest tego przykładem, oferując lepszy stosunek ceny do wydajności niż wcześniejsze TPU i, jak sugeruje Google, konkurencyjną alternatywę dla wynajmu GPU NVIDIA. Jedna z analiz zauważyła, że Google może wycenić instancje TPU v6e na nieco ponad 2× kosztu v5e, ale ponieważ są one 4–5× szybsze, końcowy koszt za jednostkę pracy i tak poprawia się o ponad 2× nextplatform.com. Rzeczywiście, Google promuje v6e jako „produkt o najwyższej wartości” dla szerokiego zakresu zadań AI (transformatory, tekst-na-obraz, CNN do wizji komputerowej) w ofercie Cloud TPU cloud.google.com cloud.google.com. Pody TPU v6e mogą być również skalowane poza pojedynczy pod: Google wprowadziło technologię multislice oraz Titanium IPU, aby łączyć wiele podów po 256 chipów przez sieć centrów danych cloud.google.com cloud.google.com. Może to pozwolić tysiącom chipów TPU v6e współpracować w „superkomputerze na skalę budynku”, czyli praktycznie nieograniczone skalowanie dla ultradużych modeli – koncepcja, do której Google nawiązywało w kontekście przyszłej infrastruktury AI cloud.google.com. Jeśli chodzi o dostępność, Cloud TPU v6e jest dostępny (na koniec 2024) w regionach Google Cloud poprzez instancje takie jak ct6e-standard typy VM cloud.google.com. Programiści mogą korzystać z konfiguracji od pojedynczego chipa (v6e-1) do pełnego podu (v6e-256), a nawet multi-pod w ramach specjalnych ustaleń cloud.google.com cloud.google.com. Google zapewnia integracje dla TensorFlow i JAX, aby bezproblemowo wykorzystywać TPU, a PyTorch jest obsługiwany przez kompilator XLA (wiele modeli PyTorch może działać na TPU przy minimalnych zmianach kodu dzięki PyTorch XLA). Popularne frameworki do serwowania modeli, takie jak vLLM, zostały również zademonstrowane na TPU v6e medium.com. Ekosystem TPU jest bardziej zamknięty niż CUDA/ROCm; nie można kupić TPU i uruchomić go lokalnie (poza rzadkimi partnerstwami), więc użytkownikami są zasadniczo ci w Google Cloud lub wewnętrzne zespoły Google. Jednak TPU Google udowodniły swoją wartość, zasilając niemal wszystkieWłasne przełomy Google w dziedzinie AI – od badań nad Transformerami po flagowe modele, takie jak PaLM i Gemini – są teraz oferowane zewnętrznym klientom, którzy potrzebują ogromnej skali bez konieczności zakupu fizycznych GPU. Kluczowy cytat od wiceprezesa i dyrektora generalnego ds. systemów i AI w Google, Amina Vahdata, podsumował premierę: „Z radością ogłaszamy Trillium, nasz szóstą generację TPU, najbardziej wydajny i najbardziej energooszczędny TPU do tej pory.” cloud.google.com To podkreśla zamiar Google, by nadal przesuwać granice wyspecjalizowanych układów AI, konkurując z producentami uniwersalnych GPU.

Porównanie rzeczywistych testów i efektywności energetycznej

Każdy z tych akceleratorów wyróżnia się w innych aspektach, więc ich porównanie wymaga kontekstu. NVIDIA B200 i AMD MI350 są bardziej bezpośrednio porównywalne (oba to uniwersalne GPU do AI/HPC), podczas gdy TPU Google to wyspecjalizowany układ ASIC w chmurze przeznaczony wyłącznie do AI. Mimo to warto zobaczyć, jak wypadają w zadaniach, do których wszystkie są przeznaczone – czyli trenowaniu i obsłudze dużych modeli AI.

- Wydajność trenowania AI (BF16/FP16): Na papierze pojedynczy NVIDIA B200 zapewnia najwyższą szczytową wydajność (4,5 PFLOPS FP16) exxactcorp.com, co odpowiada mniej więcej dwóm GPU MI350X lub pięciu chipom TPU v6e (każdy 0,918 PFLOPS BF16) cloud.google.com. W praktyce duże znaczenie mają skalowanie wielu GPU i dojrzałość oprogramowania. NVIDIA zaprezentowała klaster GPU Blackwell (GB200 NVL) trenujący ogromny LLM z rekordową prędkością – na GPU około 3× szybciej niż poprzednia generacja H200 developer.nvidia.com developer.nvidia.com. AMD z kolei deklaruje ~1,13× szybsze trenowanie względem NVIDIA w wybranych testach tomshardware.com, ale prawdopodobnie chodzi o scenariusze, w których dodatkowa pamięć MI355X lub FP32/FP64 mogą wspomóc zbieżność. TPU v6e Google może efektywnie trenować modele takie jak PaLM po skalowaniu do podów, ale wydajność pojedynczego chipa jest niższa niż GPU. Na przykład serwer 8-GPU B200 (DGX B200) może znacznie przewyższyć hosta z 8 chipami TPU podczas trenowania, biorąc pod uwagę 72 PFLOPS FP8 w DGX wobec ~7,3 PFLOPS BF16 w hoście TPU nvidia.com cloud.google.com. Jednak Google może wdrożyć 32 takie hosty (256 chipów), by siłowo rozwiązywać duże zadania. Podsumowując, pod względem surowej prędkości trenowania na jednym serwerze, B200 prawdopodobnie prowadzi, następnie MI350 (który powinien być w tej samej klasie), a TPU v6e osiąga szczytową efektywność dopiero w skali podów. Wnioskowanie AI i przepustowość przy niskiej precyzji: To jest obszar, w którym wszystkie trzy firmy złożyły duże deklaracje. NVIDIA reklamuje do 15× wzrost wydajności wnioskowania względem H100 nvidia.com, głównie dzięki FP4. AMD chwali się 35× wzrostem wydajności wnioskowania względem MI300 i twierdzi, że MI355X przewyższa B200 o 20–30% w niektórych zadaniach wnioskowania LLM smbom.com. TPU v6e Google’a, z obsługą INT8 i potencjalnie FP8, jest bardzo zoptymalizowany pod kątem wnioskowania (67% więcej wydajności na wat niż wcześniej, głównie do obsługi zapytań). Warto zauważyć, że Blackwell od NVIDIA ma przewagę elastyczności: uruchamianie dowolnego modelu w istniejących frameworkach GPU. MI350 od AMD może wykorzystać nowe FP4/FP8 w PyTorch/TensorFlow, gdy tylko zostaną one obsłużone, a AMD deklaruje 40% przewagi kosztu na token dla MI355X względem B200 przy obsłudze wnioskowania smbom.com. TPU Google’a może wygrać pod względem bezwzględnej latencji w skali – TPU mają specjalizowane połączenia i batching do obsługi wielu zapytań (Google używa ich do obsługi usług takich jak Search i Bard na całym świecie). Jeśli weźmiemy pod uwagę koszty, pod TPU v6e prawdopodobnie zapewnia wnioskowanie po niższym koszcie niż równoważny klaster GPU dla niektórych obciążeń, co jest atutem Google’a. Na przykład, jeden z blogów Google Cloud wskazał na 2,3× lepszy stosunek ceny do wydajności przy przejściu z GPU na rozwiązania TPU w niektórych przypadkach nextplatform.com. Wszystko zależy od obciążenia; transformatory z intensywną algebrą macierzy to mocna strona NVIDIA/AMD, podczas gdy zadania rekomendacyjne i o dużej rzadkości to domena Google SparseCore.

- Pamięć i rozmiar modelu: AMD wyraźnie prowadzi pod względem surowej pamięci na akcelerator: 288 GB HBM3e w MI355X tomshardware.com. NVIDIA B200 ma 180 GB nvidia.com. Google TPU v6e ma 32 GB na chip, ale efektywnie 256 GB na hosta z 8 chipami i 8 TB w całym podzie cloud.google.com. Dla zadań na pojedynczej instancji (jeden model mieszczący się na jednym akceleratorze), AMD może obsłużyć największe modele (np. model wymagający 250 GB wag mógłby działać na jednym MI355X, podczas gdy musiałby być podzielony na dwa B200 lub 8 chipów TPU). Niemniej jednak, zarówno NVIDIA, jak i Google stosują równoległość modelu, aby dzielić duże modele na GPU/TPU. NVIDIA NVLink i NVSwitch pozwalają wielu B200 działać jak jedna duża pula pamięci (8×180 GB = 1,44 TB w DGX, co zostało wykorzystane do uruchomienia modeli z ponad 400 mld parametrów w MLPerf) nvidia.com developer.nvidia.com. Pod TPU Google’a podobnie łączy 8 TB HBM w całości. Tak więc dla ultradużych modeli (setki miliardów parametrów) wszystkie mogą je obsłużyć poprzez trening rozproszony – ale AMD może pozwolić na uruchomienie nieco większych modeli bez rozproszenia (prostszy model programowania). Ponadto przepustowość pamięci AMD dorównuje NVIDIA: 8 TB/s vs 8 TB/s tomshardware.com tomshardware.com, obie znacznie powyżej 1,6 TB/s na chip TPU (choć TPU rekompensuje to większą liczbą chipów obsługujących model). Dla modeli ograniczonych przepustowością pamięci (jak wizja CNN lub rzadkie ML), GPU mają przewagę w surowej przepustowości na urządzenie.

- Wydajność energetyczna: Wszyscy trzej dostawcy poprawili stosunek wydajności do zużycia energii (perf/W), ale jak się ze sobą porównują? NVIDIA nie podała prostego wskaźnika perf/W, ale wydajność na wat dla AI w Blackwellu prawdopodobnie się podwoiła w porównaniu do Hopper (który był w zakresie ~TOPS/W). AMD wyraźnie deklaruje 4× większą moc obliczeniową przy podobnym poborze mocy przechodząc z CDNA3 na CDNA4, plus zyski z 3D stackingu; gęstość wydajności MI350X (PFLOPS na wat) wydaje się bardzo wysoka, choć przy wysokim poborze mocy. 67% wzrost efektywności energetycznej Google to ogromny wynik – TPU v6e wykonuje prawie 5× więcej pracy przy zużyciu ok. ~3× więcej energii niż v5e, więc daje to ~1,67× netto poprawy perf/W. Trudno to uszeregować bez identycznych metryk, ale jeśli chodzi o przepustowość inferencji na wat, Blackwell używający FP4 prawdopodobnie wygrywa (ponieważ FP4 podwaja przepustowość przy niewielkim wzroście zużycia energii). FP4 od AMD jest podobny i firma deklaruje MI355X 20 PFLOPS z rzadkością przy 1,4 kW smbom.com, co daje ~14,3 TFLOPS na wat dla FP4 sparse. NVIDIA B200 przy ~1,5 kW osiąga 18 PFLOPS FP4 (bez potrzeby rzadkości) exxactcorp.com exxactcorp.com, czyli około 12 TFLOPS/W – nieco mniej, jeśli porównać te liczby bezpośrednio. Przy rzadkości Blackwell również by podwoił, więc w idealnych warunkach mógłby osiągnąć ~24–30 TFLOPS/W. Podsumowując, wszystkie są niezwykle energooszczędne dla AI względem poprzedniej generacji, a różnice mogą wynosić 10–20%. Rzeczywista efektywność zależy też od wykorzystania (TPU Google błyszczą przy wysokim wykorzystaniu w chmurze, podczas gdy samodzielnie hostowane GPU mogą czasem się nudzić).

Wsparcie programowe i ekosystemowe

Wszystkie trzy platformy mają odrębne ekosystemy programowe, które mogą być równie ważne jak możliwości sprzętowe:

- NVIDIA (CUDA + AI Enterprise): Stos NVIDIA jest najbardziej ugruntowany. Programiści używają CUDA oraz bibliotek takich jak cuDNN, TensorRT, NCCL i innych, które były intensywnie optymalizowane przez ponad dekadę. Frameworki takie jak PyTorch i TensorFlow mają natywne wsparcie dla CUDA, co oznacza, że modele uruchamiają się na GPU NVIDIA bez większych problemów. Wraz z Blackwell, NVIDIA udostępnia także aktualizacje, takie jak pakiet TensorRT-LLM dla dużych modeli językowych oraz integrację Transformer Engine, która automatyzuje mieszane precyzje (teraz także z FP4) developer.nvidia.com. Dodatkowo, pakiet oprogramowania AI Enterprise od NVIDIA (dołączany do systemów DGX) zapewnia stabilność i wsparcie dla korporacyjnych przepływów pracy AI, a narzędzia takie jak NeMo Megatron upraszczają trenowanie ogromnych modeli na klastrach DGX nvidia.com. Przewaga ekosystemu jest widoczna: wielu badaczy i inżynierów AI „myśli w CUDA” i korzysta z rozbudowanego wsparcia społeczności oraz dokumentacji dla GPU NVIDIA. GPU Blackwell mogą w dużej mierze wykorzystywać oprogramowanie zoptymalizowane pod Hopper; NVIDIA wypuściła zestaw narzędzi CUDA zoptymalizowany pod Blackwell równocześnie z dostępnością sprzętu. Ta kompatybilność wsteczna i przyszłościowa to duży plus – kod, który działał na V100/A100/H100, można zazwyczaj po prostu przekompilować lub nawet uruchomić bez zmian na B200 (po prostu działa szybciej). Bliska współpraca NVIDIA z dostawcami oprogramowania i platformami chmurowymi oznacza także, że nawet zastrzeżone lub zamknięte oprogramowanie AI (np. niektóre korporacyjne platformy AI) często domyślnie najpierw wspiera NVIDIA.

- AMD (ROCm + HIP): ROCm (Radeon Open Compute) firmy AMD to otwartoźródłowy stos obliczeń GPU, który znacznie dojrzał w ostatnich latach. Dla MI300/MI350 AMD udostępnia ROCm 6, który obsługuje wszystkie główne frameworki AI poprzez natywne backendy lub HIP (Heterogeneous-compute Interface for Portability). HIP to kompatybilne z CUDA API AMD – pozwala na kompilację wielu baz kodu CUDA dla GPU AMD przy minimalnych zmianach. AMD współpracowało z PyTorch przy opracowaniu PyTorch Direct ML for ROCm, a także z zespołami TensorFlow i JAX, aby umożliwić ich działanie na ROCm amd.com. Do 2024 roku PyTorch na ROCm mógł uruchamiać popularne modele transformerów na MI300X z jedynie niewielkimi różnicami wydajności względem NVIDIA (zakładając, że model nie korzystał z operacji specyficznych dla NVIDIA). Ponadto AMD optymalizuje popularne jądra modeli (attention, blok transformera, konwolucja itd.) dla architektur CDNA. Wyróżnia się tu: nocne testy Hugging Face 700 tys. modeli na MI300X, które zapewniają, że szeroka gama modeli z repozytorium jest weryfikowana na AMD amd.com, co daje pewność, że wiele architektur (BERT, GPT, Stable Diffusion itd.) będzie działać na MI350 już na starcie. ROCm ma wciąż mniejszą społeczność użytkowników niż CUDA, a narzędzia/debugowanie na AMD mogą być trudniejsze ze względu na stosunkowo nową technologię. AMD stara się temu zaradzić, współpracując z uniwersytetami, laboratoriami narodowymi i dostawcami chmury, by budować bazę wiedzy wokół GPU Instinct. Firma kładzie też nacisk na otwarte standardy – np. wsparcie dla PyTorch/XLA (używanego także przez TPU) oraz offloadingu OpenMP dla kodu HPC. Luka programistyczna się zmniejsza; jeśli modele organizacji opierają się na niestandardowych jądrach CUDA, portowanie na AMD może wymagać wysiłku, ale dla wielu popularnych modeli jest to coraz częściej „zamień i uruchom”. MI350 od AMD będzie również wykorzystywać MIOpen (odpowiednik cuDNN) do rutyn uczenia głębokiego oraz kompilatory AOMP dla HPC. Jednym z wyzwań jest szybkie tempo rozwoju AMD – MI250, MI300, MI350 różnią się między sobą – więc oprogramowanie musi nadążać za nowymi funkcjami, jak FP4/FP6. Jednak biorąc pod uwagę, że MI350 korzysta z tej samej platformy UBB i w dużej mierze rozszerza MI300, wsparcie programowe powinno być gotowe (MI350 był wspominany jako „proxy” w prognozach podczas ocen wydajności MI300X amd.com, co sugeruje, że prototypy oprogramowania były testowane). Podsumowując, ekosystem AMD nie jest jeszcze tak „plug-and-play” jak NVIDIA, ale dla zaangażowanych użytkowników jest to rozwiązanie realne i szybko się rozwija, obniżając barierę wejścia dla GPU MI350, zwłaszcza w kontrolowanych środowiskach, takich jak superkomputery czy zarządzane instancje chmurowe.

- Google TPU (TensorFlow & JAX na Cloud TPU): Ekosystem TPU v6e jest dość inny, ponieważ jest dostępny wyłącznie jako usługa. Użytkownicy nie zarządzają sterownikami ani niskopoziomowymi bibliotekami; zamiast tego uzyskują dostęp do TPU za pośrednictwem Cloud TPU API Google lub poprzez integracje w TensorFlow i JAX. Google udostępnia kompilator TPU (XLA), który przekształca grafy obliczeniowe w kod wykonywalny na TPU. W przypadku TensorFlow jest to niemal bezproblemowe – można rozproszyć model na TPU używając wysokopoziomowych API (tf.distribute.TPUStrategy). Dla JAX (który Google preferuje w badaniach), kompilator jax.jit może skutecznie wykorzystywać TPU, a wiele modeli badawczych Google jest pisanych w JAX+Flax, aby działały na TPU. Wsparcie PyTorch na TPU historycznie pozostawało w tyle, ale wraz z TPU v5e i v6e Google i Meta współpracowały nad PyTorch XLA, co pozwala uruchamiać kod PyTorch na TPU przy minimalnych modyfikacjach. To kluczowe, ponieważ PyTorch jest dominującym frameworkiem w przemyśle. Istnieją pewne ograniczenia (nie każda operacja PyTorch jest kompatybilna z TPU i czasem wymagana jest optymalizacja wydajności), ale wiele popularnych modeli można uruchomić. Dodatkowo, narzędzia Google, takie jak tf.data, profiler TPU oraz pulpity Cloud Monitoring, są dostępne, aby pomóc zoptymalizować potoki wejściowe i debugować problemy z wydajnością na TPU cloud.google.com cloud.google.com. Jedną z zalet ekosystemu TPU jest zarządzane środowisko – nie martwisz się o wersje oprogramowania czy niezgodności sterowników; Google zapewnia, że cały stos (od krzemu po chłodzenie) działa od razu po uruchomieniu. Wadą jest mniejsza elastyczność: nie możesz np. pisać własnego kodu jądra dla TPU (poza pisaniem własnych operacji w kompilowalnym podzbiorze TensorFlow). Jeśli Twój model używa operacji, której XLA nie obsługuje, musisz poczekać, aż Google ją doda lub znaleźć obejście. Ponadto, niektóre typy modeli (np. te z dużą ilością dynamicznej kontroli przepływu) nie pasują dobrze do zorientowanego na batch, statycznie kompilowanego paradygmatu TPU. Jednak do podstawowych zastosowań deep learningu – dużych mnożeń macierzy – TPU są bardzo wydajne. Google przygotował także wysokowydajne implementacje takich elementów jak multi-head attention, warstwy Transformer itp. w swoich bibliotekach TensorFlow i JAX dla TPU. Stale wprowadzają swoje badania (np. optymalizacje dla mixture-of-experts, wydajne strategie shardingowe itd.) do oprogramowania cloud TPU. Jeśli więc Twój przypadek użycia pokrywa się z tym, co robi Google (LLM, modele wizji komputerowej itd.), oprogramowanie TPU może być bardzo solidne. Kolejną częścią ekosystemu TPU są wyższe usługi Google: na przykład Pathways (do inferencji na wielu hostach) oraz zarządzane rozwiązania jak Vertex AI mogą wykorzystywać TPU w tle. To jeszcze bardziej abstrahuje sprzęt od użytkownika końcowego, czyniąc zalety TPU dostępnymi bez zaawansowanego wysiłku inżynierskiego. W istocie, ekosystem TPU v6e jest idealny dla tych, którzy już są w świecie Google Cloud i TensorFlow/JAX, ale jest mniej dostępny dla tych, którzy chcą rozwiązania on-prem lub pełnej kontroli (co jest zamierzone, ponieważ Google używa TPU, by przyciągnąć użytkowników do swojej chmury).

Scenariusze wdrożenia i dostępność

NVIDIA, AMD i Google mają różne modele wdrożeniowe i harmonogramy dostępności tych akceleratorów:

- Dostępność NVIDIA Blackwell B200: GPU Blackwell firmy NVIDIA zostały wprowadzone około GTC 2024, a pod koniec 2024 roku weszły do pełnej produkcji. Urządzenia DGX B200 (8× GPU B200) są obecnie filarem oferty centrów danych AI firmy NVIDIA, a dostawy do kluczowych klientów oraz do własnej chmury NVIDIA (DGX Cloud) rozpoczęły się około IV kwartału 2024 roku developer.nvidia.com. Do 2025 roku główni dostawcy chmur, tacy jak AWS, Azure, GCP i Oracle, mają oferować instancje B200, jak wskazuje NVIDIA developer.nvidia.com. Przedsiębiorstwa mogą również kupować płyty serwerowe HGX B200 poprzez OEM-ów, takich jak Dell, HPE, Supermicro itd. DGX B200 (z 8 GPU, dwoma procesorami Xeon, siecią, 1,44 TB HBM łącznie) to system z najwyższej półki, którego koszt wynosi około $500K+ (plotki mówią o około $515k) modal.com. Cena za pojedynczy GPU to dziesiątki tysięcy dolarów; branżowe pogłoski sugerują, że jedna karta B200 kosztuje $30K–$40K w zależności od wolumenu smbom.com. Wczesnymi użytkownikami są laboratoria badawcze trenujące przełomowe modele AI oraz firmy budujące prywatne klastry AI – zasadniczo ci, którzy wycisnęli Hopper H100 do granic możliwości i potrzebują kolejnego przyspieszenia. NVIDIA wdraża także GPU Blackwell w swoich superchipach: Grace-Blackwell GB200 (1 CPU Grace + 2× B200 na jednej płycie, połączone przez NVLink-C2C) jest przeznaczony dla gigantycznych modeli, które korzystają z bliskiej integracji CPU-GPU i ogromnej pamięci (CPU Grace dodaje 512 GB pamięci LPDDR). Ta konfiguracja GB200 „Ultra GPU” jest skierowana do obciążeń typu HPC-AI fusion i planowana na 2025 rok, z ceną na poziomie około $60K–$70K za moduł nextplatform.com. Podsumowując, Blackwell będzie wszechobecny w segmencie high-end AI do 2025 roku – każda organizacja, która może sobie na nie pozwolić i potrzebuje najlepszej wydajności do trenowania lub wnioskowania, rozważy wdrożenie B200, czy to w klastrach lokalnych (ze względu na suwerenność danych lub potrzebę stałego wykorzystania), czy przez wynajem w chmurze (do okazjonalnego skalowania). Rozbudowana sieć partnerska NVIDIA zapewnia, że od rozwiązań SuperPOD po mniejsze serwery 4-GPU, GPU Blackwell będą dostępne w różnych formatach. Dostępność AMD Instinct MI350: AMD zapowiedziało, że akceleratory MI350X i MI355X mają być dostępne w 2025 amd.com amd.com. Pierwszy układ scalony został zaprezentowany w połowie 2024 roku, a do połowy 2025 AMD poinformowało, że rozpoczęło wysyłkę produkcyjnych jednostek MI350X (w ograniczonych ilościach) tomshardware.com tomshardware.com. Wzrost produkcji przewidywany jest na końcówkę 2025 roku, gdy ruszą główne wdrożenia. Jednym z najbardziej oczekiwanych wdrożeń jest superkomputer El Capitan amerykańskiego DOE (w Lawrence Livermore National Lab), który wykorzysta wariant MI300 – potencjalnie zaktualizowany do MI350 w momencie instalacji. Dodatkowo, giganci chmurowi tacy jak Microsoft oficjalnie współpracują z AMD: Azure ogłosiło zamiar oferowania maszyn wirtualnych z serii MI300, więc można przypuszczać, że MI350 pojawi się w ofercie, jeśli wydajność się potwierdzi tomshardware.com. Są także doniesienia o Meta testującej MI300/MI350 dla swojej infrastruktury AI, co w przypadku sukcesu może skutkować dużymi zamówieniami (Meta historycznie korzystała głównie z NVIDIA, ale presja kosztowa może skłonić ich do wdrożenia AMD). ODM-y takie jak Lenovo i Supermicro zaprezentowały systemy obsługujące moduły MI300 OAM, więc będą one wspierać także MI350. Jednak początkowo dostępność może być ograniczona – AMD zyskuje na popularności, ale wciąż rozwija łańcuchy dostaw i wsparcie programowe. Jak wskazuje doniesienia prasowe o podwyżkach cen, popyt jest na tyle duży, że AMD zdecydowało się podnieść ceny MI350 o około 66% w połowie 2025 roku smbom.com smbom.com, być może z powodu dużych zamówień wstępnych. Możliwe, że akceleratory MI350 pojawią się w ofertach chmurowych pod koniec 2025 lub na początku 2026 roku; wyzwaniem jest to, że hiperskalerzy potrzebują czasu na walidację oprogramowania i wydajności w dużej skali. Roczny cykl aktualizacji AMD (Instinct MI400 spodziewany w 2026 roku) <a href="https://www.amd.com/en/newsroom/press-releases/2024-6-2-amd-accelerates-pace-of-data-center-ai-innovation-.html#:~:text=The%20updated%20roadmap%20starts%20with,the%20AMD%20CDNA%20%E2%80%9CNext%E2%80%9D%20architecture" target="_blank" rel="noramd.com amd.com sugeruje, że MI350 będzie flagowym modelem przez cały 2025 rok. Jeśli chodzi o zastosowania, początkowymi klientami będą prawdopodobnie ci, którzy potrzebują dużej pojemności pamięci (np. do trenowania bardzo dużych modeli lub analizy big data) albo ci, którzy szukają lepszych cen niż u NVIDIA. Przedsiębiorstwa posiadające istniejący kod CUDA mogą wdrażać AMD powoli, ale ci, którzy budują nowe obciążenia (szczególnie na PyTorch lub do serwowania inferencji), mogą się zdecydować, jeśli wsparcie ROCm będzie solidne. Ekosystem OEM dla AMD Instinct również się rozwija: HPE, Dell i inni będą oferować modele serwerów z MI350 dla klientów, którzy o nie poproszą. AMD pozycjonuje MI350 zarówno dla mega-projektów AI, jak i głównego nurtu chmury – można się spodziewać ogłoszeń o wdrożeniach MI350 w superkomputerach, platformach AI w chmurze, a być może nawet w gotowych systemach AI niektórych OEM-ów (podobnych do DGX, ale opartych na AMD). Jeśli chodzi o ceny, jak wspomniano, AMD jest nieco tańsze od NVIDIA: może około 25 tys. dolarów za GPU przy dużych ilościach smbom.com. Jeśli te ceny się utrzymają, można się spodziewać, że serwer 8xMI355X (z ok. 2,3 TB HBM łącznie) będzie wyceniony nieco poniżej NVIDIA DGX o podobnej skali – kusząca propozycja, jeśli wydajność spełni oczekiwania.

- Dostępność Google Cloud TPU v6e: TPU v6e (Trillium) został ogłoszony w maju 2024 roku i udostępniony wkrótce potem w Google Cloud (został również zaprezentowany na SC24 w listopadzie 2024) servethehome.com. Google zazwyczaj wprowadza dostępność TPU region po regionie; do końca 2024 roku pody TPU v6e (256 układów) były prawdopodobnie dostępne dla wybranych klientów Google Cloud (Google często pozwala najpierw korzystać z nowych TPU zespołom Google Research i wybranym partnerom, a następnie udostępnia je szerzej). Oficjalna dokumentacja pokazuje wsparcie dla typów instancji TPU v6e od 1 do 256 układów cloud.google.com, co oznacza, że są one zasadniczo publicznie dostępne. Każdy użytkownik Google Cloud może je zamówić przez konsolę Cloud lub API (zakładając, że zostanie przyznany limit, ponieważ są to drogie zasoby). Scenariusz wdrożenia dla TPU v6e to zasadniczo centra danych Google Cloud – w przeciwieństwie do GPU, nie można wdrożyć TPU lokalnie. Docelowi użytkownicy to więc ci, którzy są gotowi uruchamiać trening/inferencję w GCP. Warto zauważyć, że Google zintegrował TPU v6e z własnymi produktami: np. wewnętrzne badania AI Google prawdopodobnie przeszły na v6e do rozwoju nowych modeli (Gemini itd.), a usługi takie jak Bard AI czy Wyszukiwarka Google z funkcjami AI prawdopodobnie wykorzystują pody v6e do efektywnej obsługi zapytań. Google oferuje także TPU przez swoją usługę zarządzaną Vertex AI jako wyższy poziom interfejsu (klient może nawet nie wiedzieć, że korzysta z TPU, tylko że jego model trenuje się szybko na Vertex AI). Na początku 2025 roku TPU v6e to jedna z najbardziej zaawansowanych ofert w GCP, a Google prawdopodobnie będzie rozszerzać dostępność wraz ze wzrostem popytu. Jeśli chodzi o koszty, Google nie opublikował cen v6e w momencie pisania; dla porównania, wcześniejsze pody TPU v4 kosztowały tysiące dolarów za godzinę. Oczekuje się, że TPU v6e będzie wyceniony premium, ale nadal konkurencyjnie w stosunku do wynajmu równoważnej liczby wysokiej klasy GPU. Strategia Google dotycząca chmurowych TPU historycznie polegała na tym, by były tańsze niż GPU do treningu (TPU v3 był bardzo opłacalny w porównaniu do V100). Jeśli to się utrzyma, możemy zobaczyć v6e oferowane w cenie dającej ~50% lepszy stosunek $/jednostkę treningową niż VM oparty na H100. Jedno ze źródeł społecznościowych wskazało, że pod TPU v6e (256 układów) może kosztować rzędu 1000+ USD/godz., co jest opłacalne tylko dla dobrze finansowanych projektów, ale może być bardziej efektywne niż zarządzanie dziesiątkami serwerów GPU przez krótki czas. Ogólnie wdrożenie TPU v6e jest powiązane z sukcesem Google Cloud w przyciąganiu obciążeń AI. Niektóre firmy (jak Midjourney do generowania obrazów czy Character AI do chatbotów) podobno wykorzystują TPU Google w backendzie – te ulepszenia v6e przyniosą im bezpośrednie korzyści. Ograniczeniem jest to, że te rozwiązania muszą działać w GCP; firmy mocno związane z AWS/Azure mogą pominąć TPU z powodów logistycznych. Ale dla tych otwartych na multi-cloud lub już obecnych w GCP, v6e oferuje potężne narzędzie. Google będzie nadal wykorzystywać TPU jako sposób na wyróżnienie swojej chmury dla AI – zasadniczo mówiąc: jeśli chcesz najszybszego treningu za najniższą cenę, przyjdź do GCP i używaj TPU zamiast wynajmować GPU od firm trzecich. To inna strategia niż NVIDIA i AMD, które sprzedają sprzęt bezpośrednio lub przez OEM.

Perspektywy nowej generacji i krajobraz konkurencyjny

Obecna rywalizacja pomiędzy Blackwell od NVIDIA, serią Instinct MI300/350 od AMD oraz TPU od Google jest zacięta, ale plany na przyszłość sugerują, że konkurencja będzie się tylko zaostrzać. Każda z firm ma już plany na kolejną generację, które będą bazować na mocnych stronach (i próbować rozwiązać słabości) obecnych układów:

- Następna generacja NVIDIA (po Blackwell): NVIDIA historycznie działała w cyklu 2-letnim, jeśli chodzi o główne architektury GPU. Po Blackwell (2024/2025) kolejna architektura – nazwa niepotwierdzona, ale prawdopodobnie znów od znanej postaci – może pojawić się około 2026 lub 2027. Choć szczegóły są skąpe, można pokusić się o pewne uzasadnione spekulacje. Po pierwsze, NVIDIA prawdopodobnie będzie kontynuować strategię specjalizacji GPU pod AI. W Blackwell już ograniczono znaczenie FP64; w przyszłości możemy zobaczyć jeszcze większe rozróżnienie, gdzie NVIDIA zaoferuje osobne linie produktów lub tryby dla „akceleratorów AI” i „akceleratorów HPC”. W rzeczywistości niektóre raporty sugerują, że NVIDIA może podzielić swoje flagowe GPU na specjalistyczne linie dla AI i HPC tomshardware.com. Może to oznaczać jedną wersję z maksymalną gęstością rdzeni tensorowych i drugą z dodatkowymi FP64/FP32 do obliczeń naukowych. Jest też trend coraz większej integracji GPU z CPU: procesor Grace od NVIDIA (oparty na Arm) jest już częścią ich platformy, a superchipy Grace+Blackwell „GB” zapowiadają jeszcze ściślejsze połączenie pamięci CPU i GPU. Nie byłoby zaskoczeniem, gdyby kolejna generacja wprowadziła coś na wzór zunifikowanego pakietu CPU/GPU lub szerszej spójności pamięci CPU-GPU (NVLink-C2C już zapewnia spójność cache między Grace a GPU). Kolejną prawdopodobną cechą jest dalsza rozbudowa pamięci i połączeń – może pojawić się pamięć HBM4 lub HBMNext, przesuwając przepustowość pamięci do 10+ TB/s na GPU. NVIDIA może też przejść na mniejszy proces technologiczny (być może TSMC 3nm lub nawet 2nm, jeśli termin to 2026/27), co pozwoli na większą liczbę tranzystorów. Te mogą zostać wykorzystane na większą liczbę SM, więcej cache lub nowe jednostki funkcjonalne. Ciekawą możliwością są akceleratory specyficzne dla AI na GPU: na przykład Blackwell dodał silnik Transformer dla FP8/FP4. Przyszłe GPU mogą mieć dedykowany sprzęt do takich zastosowań jak modele rekomendacyjne (obszar, na który celują AMD i Google z SparseCore i podobnymi rozwiązaniami). Jensen Huang wspominał też o długoterminowych badaniach nad optycznymi połączeniami, DPU i integracją fotoniki – być może nie w najbliższej generacji, ale na horyzoncie, by dalej skalować sieci. Jeśli chodzi o pozycjonowanie, NVIDIA będzie dążyć do utrzymania pozycji lidera w kompleksowych rozwiązaniach AI. Gdy AMD wypuści MI400 lub MI500, NVIDIA odpowie swoją nową architekturą. Konkurencja prawdopodobnie sprawi, że kolejna generacja NVIDIA będzie znacząco potężniejsza (być może kolejny 2–3× skok wydajności AI), by pozostać na czele. Ceny mogą się też zmienić – jeśli AMD nadal będzie konkurować ceną, NVIDIA może zaoferować bardziej „łagodne” (nomen omen) opcje kosztowe, np. przez partnerstwa chmurowe lub pakiety (np. zniżki na kredyty DGX Cloud). Warto obserwować, czy NVIDIA nie wejdzie w bardziej specjalizowane układy: mają już GPU i DPU, ale czy stworzą kiedyś dedykowany ASIC macierzowy podobny do TPU? Na razie nie musieli tego robić, ale jeśli podejście Google zaczęłoby zagrażać pozycji NVIDIA, mogliby odpowiedzieć, tworząc wariant GPU ograniczony tylko do rdzeni tensorowych i sprzedawany jako akcelerator wnioskowania. Na razie jednak podejście GPU daje im elastyczność, która dobrze się sprawdza.

- Następna generacja AMD (MI400 i dalej): AMD publicznie udostępniło ogólny plan rozwoju: po CDNA4 (seria MI350 w 2025), architektura CDNA „Next” będzie napędzać serię Instinct MI400, której premiera spodziewana jest w 2026 amd.com amd.com. Co ciekawe, niektóre wczesne informacje sugerują, że MI400 może być znaczącym skokiem, być może nawet wykorzystując technologie, które pierwotnie miały trafić do planów MI500 nextplatform.com. Zaktualizowany raport twierdził, że GPU MI400X może być ~10× szybszy od MI300X i jest przewidziany do nowego systemu „Helios” w skali rack z procesorami EPYC „Venice” tomshardware.com. Sugeruje to, że AMD pracuje nie tylko nad samym układem, ale także nad innowacjami na poziomie systemu (podobnie jak strategia NVIDIA Grace+GPU). Wspomniano także o Instinct MI450X z IF128 (128 linii Infinity Fabric) na 2026 rok tomshardware.com, co sugeruje projekt umożliwiający bezproblemowe połączenie 128 GPU w jednym racku – analogicznie do sieci NVLink Switch od NVIDIA. W przypadku MI400 można spodziewać się przejścia na jeszcze nowszy proces technologiczny (być może TSMC 2 nm, jeśli harmonogram się zgodzi, lub udoskonalony 3 nm), bardziej zaawansowanego pakietowania 3D (może nawet integracji HBM na wierzchu układów obliczeniowych itd.) oraz prawdopodobnie dalszego zwiększenia pojemności i przepustowości pamięci. AMD najprawdopodobniej wdroży każdą nową dostępną technologię pamięci (HBM4 lub HBM3e o jeszcze większej gęstości). Po stronie obliczeniowej, biorąc pod uwagę postępy AMD, MI400 może wprowadzić obsługę jeszcze mniejszych typów danych (FP2? Int4 w pełni? kto wie) oraz bardziej agresywne wykorzystanie rzadkości i instrukcji ukierunkowanych na AI. Ostatnie zapowiedzi AMD dotyczące przyszłych produktów AI (jak wzmianka o GPU „Radeon AI” dla rynku prosumenckiego tomshardware.com) wskazują, że firma chce objąć większą część rynku. Wraz z MI400 lub MI500 AMD może także zunifikować niektóre funkcje z GPU konsumenckich (gamingowych) w linii AI (np. wykorzystując rdzenie graficzne RDNA do określonych zadań mieszanych, jeśli zajdzie taka potrzeba). Pod względem pozycjonowania AMD wyraźnie celuje w przewagę wydajności na dolara. Jeśli MI350 odniesie sukces, MI400 pójdzie o krok dalej, być może przeskakując NVIDIA pod pewnymi względami, jeśli się uda. Na przykład AMD może zdecydować się na znaczne przewyższenie NVIDIA pod względem pamięci (wyobraź sobie MI400 z 512 GB HBM) lub obsługi precyzji arytmetycznej (AMD może zachować pełną wydajność FP64, co przemawia do centrów HPC, podczas gdy NVIDIA ją ograniczyła – i w ten sposób wygrywać kontrakty HPC). AMD przejęło także Xilinx, więc wilKarta d pokazuje, jak mogą zintegrować FPGA lub logikę adaptacyjną ze swoimi akceleratorami. Można sobie wyobrazić przyszłe platformy Instinct, które będą zawierać pewne rekonfigurowalne rdzenie do zadań specjalistycznych. Krótko mówiąc, plan rozwoju AMD pokazuje coroczny rytm teraz amd.com – nie są już generację lub dwie za NVIDIA; idą łeb w łeb. Jeśli dobrze zrealizują MI400 w 2026 roku i MI500 około 2027 roku (jak sugerują niektóre przecieki, np. „MI500X w 2027” tomshardware.com tomshardware.com), AMD może stać się współliderem wśród akceleratorów AI, wymuszając prawdziwie konkurencyjny rynek. To dobra wiadomość dla kupujących, ponieważ zwykle prowadzi to do obniżenia kosztów i wzrostu innowacyjności.Google’s Next Gen (TPU v7 i więcej): Google oficjalnie nie mówił o TPU v7, ale niemal pewne jest, że nad nim pracują. Historycznie Google wypuszczał nową generację TPU mniej więcej co 1–1,5 roku (TPU v4 w 2020–21, v4i/v5e w 2022–23, v6 w 2024). Tak więc TPU v7 może pojawić się w 2025 lub 2026. Ciekawostką jest, że Google często wypuszcza „wariant”: dla v4 mieli v4 i v4i (optymalizowany pod inferencję), dla v5 mieli v5e (tańsza, skalowalna wersja). Artykuł na The Next Platform spekulował, że TPU v6 może również doczekać się układu „v6i” zorientowanego na inferencję później nextplatform.com. Jeśli tak, Google może wprowadzić TPU v6i z być może mniejszą liczbą MXU, ale większą liczbą chipów na pod lub czymś, co maksymalizuje przepustowość na dolara przy obsłudze. Alternatywnie, TPU v7 może zaspokoić oba te potrzeby. Technicznie możemy zobaczyć, jak Google wprowadza obsługę jeszcze niższej precyzji; skoro inni mają FP4, Google prawdopodobnie zadba, by TPU v7 obsługiwał FP8, FP4 (prawdopodobnie emulowane programowo w formacie bfloat16 lub nowym sprzęcie). Google może też zwiększyć pamięć – od dawna ograniczeniem TPU była stosunkowo niska pamięć na chip, ale w v6 podwojono ją do 32 GB. Jeśli HBM3 i opakowania 3D na to pozwolą, TPU v7 może mieć np. 64 GB na chip, co pomogłoby przy większych modelach i zmniejszyło potrzebę dzielenia danych. Kolejny obszar to interkonekt: Google już używa łączy optycznych do multi-podów, ale mogą przejść na 3D torus lub inne topologie, by poprawić opóźnienia operacji zbiorczych. Powinniśmy się też spodziewać większej integracji z siecią i infrastrukturą Google: wzmianka o „Titanium IPUs” do łączenia podów cloud.google.com sugeruje, że Google może w przyszłości wprowadzić inteligentne przełączniki sieciowe lub fotoniczne interposery, by skalować systemy do jeszcze większych rozmiarów (dziesiątki tysięcy chipów). Jeśli chodzi o konkurencję, program TPU Google jest skierowany do wewnątrz (wsparcie produktów Google), ale też na zewnątrz, by przyciągnąć klientów chmurowych. Będą nadal pozycjonować TPU jako najbardziej opłacalny sposób trenowania ogromnych modeli – nawet jeśli NVIDIA czy AMD mają szybsze chipy, Google może argumentować, że ich TPU pody, w skali, dają tańsze rezultaty (bo Google kontroluje cały stack i może agresywnie kształtować ceny). Jednym z wyzwań dla Google jest luka w oprogramowaniu dla osób z zewnątrz – mogą musieć zainwestować więcej w narzędzia ułatwiające migrację z GPU na TPU. W przeciwnym razie wielu nadal wybierze GPU mimo kosztów, po prostu z powodu przyzwyczajenia. Nie byłoby zaskoczeniem, gdyby Google w końcu zaoferował TPU z większą pamięcią lub systemy hybrydowe (wyobraź sobie TPU z zintegrowanym CPU lub większą ilością DRAM), by uczynić je bardziej uniwersalnymi. Na razie jednak Google prawdopodobnie utrzyma TPU w roli wyspecjalizowanych: czystych maszyn do ML, wdrażanych w tysiącach w swoich centrach danych. Wraz ze wzrostem zapotrzebowania na generatywną AI, Google będzie skalować wdrożenia TPU, by sprostać swoim potrzebom (dla Search, Map, rekomendacji YouTube itd.), co oznacza, że TPU v7 i kolejne będą kluczowe dla przyszłości AI Google. Warto też zauważyć, że inni hyperscalerzy mogą odpowiedzieć, rozwijając własne chipy (Amazon ma ASIC-i Trainium i Inferentia, choć jeszcze nie tak zaawansowane; Microsoft podobno też pracuje nad chipem AI). Google nie będzie więc sam – ale TPU v6e i v7 wyznaczają wysoką poprzeczkę dla nowych graczy. W szerszym krajobrazie, jeśli klienci chmurowi coraz częściej będą wybierać TPU ze względu na koszty, może to zmusić NVIDIA i AMD do zmiany cen lub strategii chmurowych. Jednak wiele przedsiębiorstw nadal będzie wolało elastyczność GPMy: Chyba że Google TPU staną się znacznie łatwiejsze do wdrożenia bez uzależnienia od jednej platformy.

Podsumowanie krajobrazu konkurencyjnego: W 2025 roku mamy do czynienia z trzystronną rywalizacją, w której NVIDIA dominuje pod względem udziału w rynku i ekosystemu, AMD agresywnie zmniejsza dystans, oferując atrakcyjną propozycję sprzętową, a Google wykorzystuje swoje pionowo zintegrowane podejście, aby rozwijać możliwości AI na dużą skalę. Jensen Huang z NVIDIA często podkreśla, że jesteśmy w „nowej erze obliczeniowej” napędzanej przez generatywną AI, a NVIDIA chce być dla tej ery tym, czym była dla ery PC i gier – domyślną platformą. Z kolei CEO AMD, Lisa Su, kładzie nacisk na wybór i otwartość, pozycjonując AMD Instinct jako oferujące „wyjątkową wydajność i wartość”, cytując wiceprezesa Brada McCredie, na rynku, który bardzo potrzebuje więcej niż jednego dostawcy tomshardware.com. Kierownictwo Google (np. Amin Vahdat) podkreśla efektywność i zrównoważony rozwój – fakt, że TPU mogą wykonać więcej pracy na wat, co wpisuje się zarówno w cele kosztowe, jak i środowiskowe cloud.google.com cloud.google.com. Ostatecznie każda firma gra swoimi atutami: NVIDIA stawia na pełny, ściśle zintegrowany stack, AMD na podejście przełamujące koszty i bogate w pamięć, a Google na rozwiązanie szyte na miarę, zoptymalizowane pod hiperskalę. Dla klientów i branży dobrą wiadomością jest to, że wydajność sprzętu AI szybuje w górę, podczas gdy oprogramowanie stopniowo zaciera różnice. Możliwe, że przyszłe frameworki pozwolą dynamicznie wybierać sprzęt najlepiej dopasowany do danego zadania (np. trenowanie na GPU, wnioskowanie na TPU itd.).

Wnioski: NVIDIA Blackwell B200, AMD Instinct MI350 i Google TPU v6e to prawdziwe cuda inżynierii, odpowiadające na nienasycone zapotrzebowanie na moc obliczeniową AI. NVIDIA B200 oferuje zawrotną szybkość i zaufany ekosystem, AMD MI350 zapewnia ogromną pamięć i konkurencyjną wydajność przy (potencjalnie) niższych kosztach, a Google TPU v6e dostarcza niezwykłą efektywność i skalę dla użytkowników swojej chmury. W miarę jak będziemy wchodzić w 2025 rok i kolejne lata, zobaczymy te akceleratory wykorzystywane wszędzie – od superkomputerów rozwiązujących wielkie wyzwania naukowe po zaplecze AI napędzające usługi internetowe używane przez miliardy ludzi. Konkurencja napędza innowacje w zawrotnym tempie – każda nowa generacja obiecuje większe modele, szybsze czasy trenowania i bardziej inteligentne aplikacje. Dla praktyków AI to ekscytujący czas z bogatszym wyborem sprzętu niż kiedykolwiek. A dla branży ta trzystronna rywalizacja ukształtuje sposób budowy i wyceny infrastruktury AI w nadchodzących latach, ostatecznie wpływając na to, jak szybko będziemy mogli rozwijać możliwości AI w sposób zrównoważony i dostępny. Jak ujął to jeden z analityków, „labirynt obliczeń AI” staje się tylko bardziej złożony i potężny engineering.miko.ai – a omawiane tu firmy przewodzą w pokonywaniu tego labiryntu w kierunku kolejnych przełomów.

Źródła:

- Strona produktu NVIDIA DGX B200 nvidia.com nvidia.com

- Blog techniczny NVIDIA MLPerf (wydajność Blackwell) developer.nvidia.com developer.nvidia.com

- Exxact Corp. – specyfikacje Blackwell vs. Hopper exxactcorp.com exxactcorp.com

- Tom’s Hardware – relacja o AMD MI350/MI355X tomshardware.com tomshardware.com

- Informacja prasowa AMD – mapa drogowa Instinct (Computex 2024) amd.com amd.com

- SMBOM News – podwyżka cen i deklaracje wydajności AMD MI350 smbom.com smbom.com Google Cloud Blog – TPU v6e “Trillium” announcement cloud.google.com cloud.google.com Google Cloud Docs – TPU v6e architecture & specs cloud.google.com cloud.google.com ServeTheHome – TPU v6e at SC24 report servethehome.com servethehome.com NextPlatform – Analysis of TPU v6 (Trillium) nextplatform.com nextplatform.com Lightly.ai Blog – B200 vs H100 real-world benchmarks lightly.ai lightly.ai Tom’s Hardware – MI350X launch (Paul Alcorn, 2025) tomshardware.com tomshardware.com Tom’s Hardware – Computex 2024 (Anton Shilov) tomshardware.com tomshardware.com

- Specyfikacje AMD Instinct MI350X (tabela Tom’s Hardware) tomshardware.com tomshardware.com

- Yahoo Finance / SeekingAlpha – informacje o cenach smbom.com (na podstawie raportu HSBC)

- Cytat wiceprezesa AMD (Brad McCredie) tomshardware.com.