- ChatGPT od OpenAI, oparty na GPT-3.5 i GPT-4, osiągnął 100 milionów użytkowników w ciągu 2 miesięcy od premiery.

- GPT-4, wydany w 2023 roku, wprowadził płynne generowanie tekstu i multimodalność (tekst+obraz).

- GPT-4.5 „Orion” został udostępniony 27 lutego 2025 r. dla subskrybentów ChatGPT Pro i jest największym dotychczas modelem OpenAI, a GPT-5 zapowiedziano na 2025 rok.

- Google przebudowało rozwiązania AI pod marką Gemini; Gemini 1.0 ukazało się w 2024 roku, a Gemini 2.5 to multimodalny model wdrożony w 2025 roku.

- Meta zaprezentowała w kwietniu 2025 rodzinę Llama 4 z architekturą MoE, Scout ma 109 miliardów parametrów (16 aktywnych sieci ekspertów) i 10 milionów tokenów kontekstu, a Maverick ma 128 ekspertów i 402 miliardy parametrów.

- DeepSeek-R1, otwarty model do zaawansowanego rozumowania, pojawił się na początku 2025 roku.

- Claude 3.7 „Sonnet” od Anthropic pojawił się w lutym 2025 roku; wprowadza dwutorowy tryb pracy z szybkim generowaniem odpowiedzi lub wydłużonym myśleniem (do 128 tys. tokenów) oraz Claude Code do asystowania kodowaniu.

- AWS Nova – rodzina modeli ogłoszona pod koniec 2024 roku, z wariantami Nova Micro, Nova Lite, Nova Pro i Nova Premier (w Q1 2025), plus Nova Canvas do obrazów i Nova Reel do wideo, a Nova są zintegrowane z AWS Bedrock i obniżają koszty o 75% w porównaniu do porównywalnych topowych modeli.

- AI Act UE uchwalony w 2024 r. wejdzie w życie w latach 2025–2026, wprowadzając rejestrację zastosowań wysokiego ryzyka, ocenę ryzyka i obowiązek oznaczania treści generowanych przez SI.

- Prognozy na 2030–2035 wskazują, że globalny rynek AI przekroczy 100 miliardów USD do 2030 roku i 5–15 bilionów USD do 2035 roku, z możliwością AGI oraz Meta przewiduje aż 1,4 biliona USD przychodów do 2035 roku.

Wprowadzenie

Generatywna sztuczna inteligencja przestała być jedynie branżowym hasłem technologicznym i stała się rzeczywistością, która w 2025 roku przekształca codzienne życie i biznes. Narzędzia takie jak ChatGPT czy generatory obrazów przeszły drogę od ciekawostek do niezbędnych asystentów w klasach lekcyjnych, biurach i studiach kreatywnych. Globalny rynek generatywnej AI gwałtownie rośnie – prognozuje się, że w 2025 roku osiągnie około 32 miliardy dolarów, co oznacza wzrost o 53,7% względem 2024 roku. Ponad 78% organizacji deklaruje korzystanie z AI w przynajmniej jednej funkcji na początku 2025 roku (wzrost z 55% rok wcześniej), co świadczy o tym, że AI stała się już infrastrukturą powszechną, a nie tylko modą. Od pisania kodu i dokumentów prawnych po generowanie dzieł sztuki i analiz biznesowych – generatywna AI rewolucjonizuje nasz sposób życia i pracy. W tym raporcie przyjrzymy się obecnemu stanowi generatywnej AI (połowa 2025 roku), jej głównym graczom i innowacjom, zastosowaniom w kluczowych branżach, najważniejszym wyzwaniom etycznym i regulacyjnym oraz prognozom ekspertów na 1, 5 i 10 lat do przodu. Na końcu stanie się jasne, dlaczego generatywną AI często określa się mianem „rewolucji” – i dlaczego nadchodząca dekada zapowiada jeszcze bardziej spektakularną transformację napędzaną przez AI.

Stan generatywnej AI w 2025 roku

Połowa 2025 roku to okres, w którym generatywna AI rozwija się w zawrotnym tempie, a giganci technologiczni i startupy prześcigają się w możliwościach swoich modeli. Duże modele językowe (LLM) i inne generatywne modele są obecnie znacznie potężniejsze, multimodalne i dostępniejsze niż jeszcze kilka lat temu. Poniżej przedstawiamy kluczowych graczy, przełomowe modele oraz najważniejsze trendy definiujące krajobraz tej technologii w 2025 roku:

- OpenAI (ChatGPT i seria GPT): ChatGPT od OpenAI, oparty na GPT-3.5 oraz GPT-4, zapoczątkował boom na AI, osiągając 100 milionów użytkowników w ciągu 2 miesięcy od premiery. Flagowy model GPT-4 (wydany w 2023 r.) wprowadził bardzo płynne generowanie tekstu i nawet multimodalność (wejście obrazu+tekstu). Na początku 2025 r. OpenAI uruchomiło GPT-4.5 „Orion” jako aktualizację pośrednią – to największy model tej firmy do tej pory – dostępny dla subskrybentów ChatGPT Pro od 27 lutego 2025 r. GPT-4.5 zapewnił lepsze rozumowanie i tryb „chain-of-thought”, ale wiązał się też z ogromnymi kosztami obliczeniowymi. OpenAI zapowiada, że GPT-5 jest na horyzoncie w 2025 r., z celem połączenia zaawansowanego rozumowania z potężnymi możliwościami językowymi. Te szybkie iteracje pokazują determinację OpenAI w przesuwaniu granic, choć każdy nowy model podnosi poprzeczkę pod względem wymagań dotyczących danych i mocy obliczeniowej. Warto podkreślić, że partnerstwo OpenAI z Microsoftem sprawia, iż modele GPT są głęboko zintegrowane z produktami takimi jak Bing Chat i Office 365 Copilot, przez co generatywna AI trafia do setek milionów użytkowników.

- Google (Gemini AI): Google odpowiedział, gruntownie przebudowując swoje rozwiązania AI pod marką Gemini. W 2024 roku Google wypuścił Gemini 1.0, zastępując wcześniejszego chatbota Bard techradar.com. Do 2025 roku najnowszy model Google, Gemini 2.5, to multimodalny gigant wdrożony zarówno w usługach konsumenckich, jak i biznesowych. Gemini potrafi płynnie przetwarzać tekst, kod, obrazy, dźwięk, a nawet video – na przykład, można zrobić zdjęcie i poprosić Gemini o analizę albo poprosić o generowanie i edycję obrazów na bieżąco. W odróżnieniu od wielu konkurentów, Google wbudował Gemini w urządzenia mobilne i swój ekosystem: powstała aplikacja mobilna Gemini, a na telefonach z Androidem może zastąpić Asystenta Google. Gemini jest dostępny w różnych wariantach (Nano, Flash, Pro, Ultra), równoważąc szybkość i moc. Zaawansowani subskrybenci mają do dyspozycji plan „AI Pro” z dostępem do największych modeli i nawet samodzielnego agenta „Deep Research”, który wykonuje zadania w imieniu użytkownika. Dzięki takim funkcjom jak generowanie obrazów (przez Imagen 3) czy nawet eksperymentalne generowanie wideo (Veo) techradar.com, Gemini idealnie odzwierciedla trend 2025: zunifikowana multimodalna AI – systemy płynnie integrujące tekst, widzenie i dźwięk. To daje Google ogromną przewagę konkurencyjną w dostarczaniu bogatych doświadczeń użytkownika (np. odpowiedzi na pytanie generowanym wideo lub interakcji głos-wizja jednocześnie).

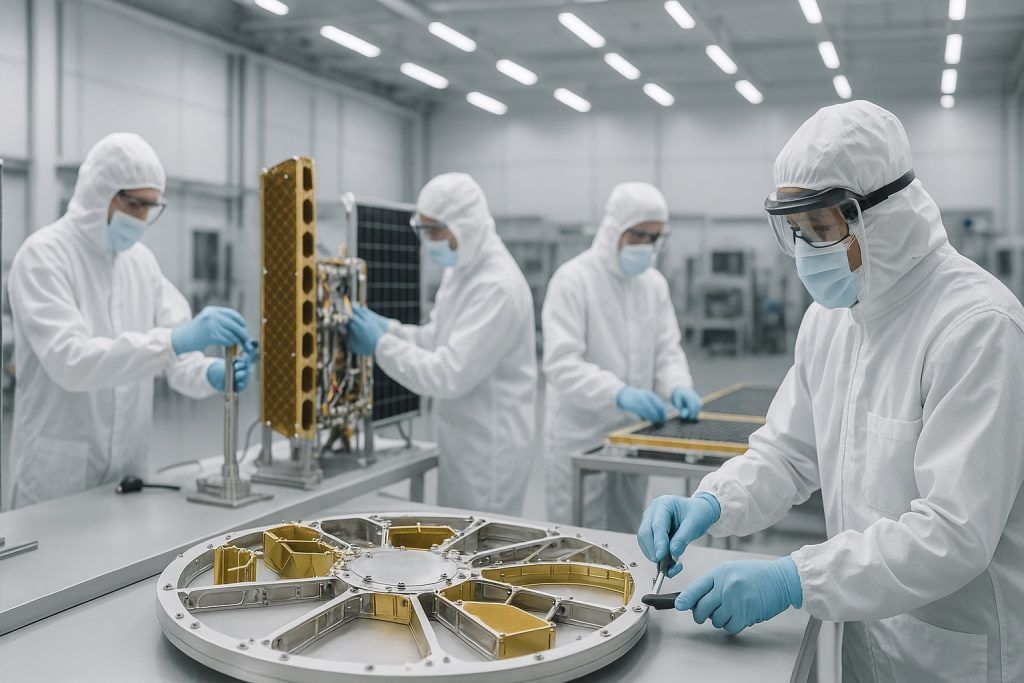

- Meta (Llama i open source): Meta (Facebook) stawia na otwarty model rozwoju generatywnej AI. W kwietniu 2025 r. Meta zaprezentowała rodzinę Llama 4 – nową generację dużych modeli językowych wykorzystujących architekturę mixture-of-experts (MoE). Dwa pierwsze modele, Scout i Maverick, osiągają ogromną skalę dzięki MoE: Scout efektywnie ma 109 miliardów parametrów (16 aktywnych sieci eksperckich) i bezprecedensowe 10 milionów tokenów kontekstu, co pozwala przetwarzać/generować bardzo obszerne dokumenty. Maverick idzie jeszcze dalej z 128 „ekspertami” i łącznie 402 miliardami parametrów (17 miliardów aktywnych na zapytanie). Modele MoE dorównują czołowym modelom przy niższych kosztach operacyjnych dzięki aktywacji tylko odpowiednich „ekspertów” dla danego zadania. Meta szkoli też jeszcze większy model (kryptonim Behemoth) celując w 2 biliony parametrów. Wszystkie modele Llama 4 są multimodalne (uczone na tekście, obrazach, wideo) i wielojęzyczne, odzwierciedlając dążenie do uniwersalnej AI otwartej dla wszystkich. Meta udostępnia je w ramach partnerstw (np. w pełni zarządzane na AWS Bedrock i Azure AI Marketplace) i na otwartych licencjach, umożliwiając naukowcom i firmom fine-tuning do własnych zastosowań. Otwarte wydanie Llama 4 w połączeniu z poprawą równoważenia odpowiedzi (Meta twierdzi, że udało się zredukować niepożądane polityczne przekłamania) pobudziło społeczność open source AI. Poza Metą, rok 2025 przyniósł wysyp otwartych modeli, które konkurują z zamkniętymi systemami – najgłośniej mówi się o chińskim DeepSeek-R1, otwartym modelu zdolnym do zaawansowanego rozumowania jak najlepsze modele OpenAI przy ułamku kosztów trenowania. DeepSeek-R1, wydany na początku 2025 r., zachwycił naukowców dostępnością i pełną przejrzystością. Jego powstanie (oraz inne modele open source, jak Dolly, Mistral itd.) pokazuje, że innowacja nie jest zarezerwowana dla Big Tech – otwarte projekty obniżają koszty i rozprzestrzeniają generatywną AI na cały świat.

- Anthropic (Claude AI): Startup Anthropic, założony przez byłych badaczy OpenAI, stał się ważnym graczem ze swoim asystentem Claude, kładąc nacisk na bezpieczeństwo i ogromne konteksty. W lutym 2025 r. Anthropic wydał Claude 3.7 „Sonnet”, określając go „najinteligentniejszym do tej pory modelem i pierwszym hybrydowym modelem rozumowania na rynku.” Claude 3.7 wprowadził nowatorskie podejście dwutorowe: potrafi generować błyskawiczne odpowiedzi, albo uruchomić tryb „wydłużonego myślenia”, w którym krok po kroku rozważa trudniejsze zadania. To hybrydowe podejście daje użytkownikowi pełną kontrolę nad szybkością kontra dokładnością – można nawet zadeklarować Claude’owi, ile tokenów lub kroków „myślenia” ma użyć (przy wydłużonym rozumowaniu aż do 128 tys. tokenów wyjściowych). Efekt to najwyższy poziom na benchmarkach kodowania i złożonego rozumowania, co podkreślali testerzy. Anthropic udostępnił także Claude Code – AI asystenta kodowania, który działa w terminalu, analizuje kod, pisze testy i potrafi samodzielnie zatwierdzać zmiany na GitHubie – wyznaczając nowy poziom „agentowej” AI w programowaniu. Z ogromnym oknem kontekstu powyżej 100 tys. tokenów i naciskiem na AI konstytucyjną (AI kierowaną zasadami etycznymi), Claude stał się wyborem dla firm ceniących zaufaną, długą analizę AI (dostępny przez API oraz przez partnerów, jak AWS i Google Cloud).

- Amazon (AWS Nova i inne): Amazon Web Services nie zostaje w tyle i pod koniec 2024 r. ogłosił własną rodzinę modeli bazowych o nazwie Amazon Nova. Modele Nova są multimodalne (obsługują tekst, obrazy, wideo) i zoptymalizowane pod kątem ekonomii i integracji biznesowej. Występują w wariantach: Nova Micro (tylko tekst, bardzo niskie opóźnienia), Nova Lite (szybki i tani multimodalny), Nova Pro (wysokie możliwości multimodalne), Nova Premier (najpotężniejszy model rozumowania, wprowadzony Q1 2025 r.). Amazon oferuje też Nova Canvas do generowania obrazów i Nova Reel do generowania wideo. Modele Nova są zintegrowane z AWS Bedrock (zarządzana usługa AI Amazonu), dzięki czemu klienci mogą je łatwo dostrajać do własnych danych i wdrażać z zachowaniem bezpieczeństwa oraz skalowalności. Amazon celuje w biznesy, które chcą korzystać z generatywnej AI na żądanie i przy przewidywalnych kosztach – firma podaje, że modele Nova są 75% tańsze w użyciu niż porównywalne topowe modele w danej klasie. Poza Nova, aktywni pozostają m.in. Microsoft, IBM: usługa Azure OpenAI Service Microsoftu oferuje hostowane GPT-4 i inne modele przedsiębiorstwom, a platforma Watsonx IBM dostarcza branżowe generatywne modele (np. do kodowania, chemii itd.). Dziesiątki startupów (Cohere, AI21, Character.AI itd.) uzupełniają ekosystem, specjalizując się np. w chatowych osobowościach AI lub modelach do medycyny, prawa itd. Rynek AI w 2025 r. jest więc niezwykle różnorodny i bardzo konkurencyjny, napędzając szybkie innowacje.

Kluczowe trendy 2025: Wśród tych graczy wyłania się kilka wspólnych motywów:

- Zunifikowana multimodalna AI: Modele nie są już tylko tekstowe – najlepsze AI roku 2025 natywnie obsługują tekst, obrazy, dźwięk i wideo w jednym systemie. Przykładowo, Gemini Google’a może przyjąć obraz i związane z nim pytanie, a następnie odpowiedzieć generowanym tekstem lub nawet wygenerować krótki film – to płynna interakcja wieloformatowa. GPT-4 OpenAI z obsługą obrazu i Llama 4 od Mety także zacierają granice między modalnościami. Ta multimodalność pozwala AI na bardziej naturalną, kontekstową odpowiedź i wykonywanie złożonych zadań wymagających różnych typów danych (np. analiza wykresu i werbalne wyjaśnienie). To krok do AI, która wchodzi w interakcję ze światem tak jak ludzie – widząc, słysząc i mówiąc w sposób zintegrowany.

- Agentowa AI i automatyzacja: Coraz większy nacisk kładzie się na AI „agentów”, którzy potrafią wykonywać działania, a nie tylko generować tekst. Wiele platform wprowadziło ekosystemy dodatków i narzędzi, dzięki którym AI potrafi wykonywać kod, wywoływać API lub sterować aplikacjami w imieniu użytkownika. Na przykład Copilot Studio Microsoftu (ogłoszony w marcu 2025 r.) zawiera autonomiczne AI zdolne do głębokiego rozumowania i realizacji wieloetapowych zadań w aplikacjach Office. Claude Code Anthropic potrafi samodzielnie modyfikować repozytoria kodu. Startupy jak Adept czy open source’owe eksperymenty AutoGPT/GPT-Engineer pokazują AI planujące i działające dla określonego celu. To dopiero początek, ale trend sugeruje, że przyszła generatywna AI nie będzie już tylko chatbotem – stanie się wykonawcą zdolnym obsłużyć nudne cyfrowe zadania czy koordynować działania z innymi AI. Połączone z multimodalnością, może to stworzyć osobistego asystenta AI zarządzającego złożonymi przepływami pracy (planowanie spotkań, analiza danych, pisanie maili itd. z minimalnym nadzorem).

- Dostosowanie i otwarty ekosystem: Firmy coraz łatwiej umożliwiają dostosowanie AI do własnych potrzeb. Otwarte modele LLM (LLaMA, DeepSeek itd.) pozwalają każdemu samodzielnie je fine-tunować lub rozbudowywać. Nawet usługi zamknięte dodają opcje wtyczek i fine-tuningu – OpenAI umożliwia programistom dostrajanie GPT-3.5 na własnych danych, a rynki pluginów pozwalają na integracje (np. pobieranie kursów akcji w czasie rzeczywistym, sterowanie inteligentnym domem przez AI). Rozwinęły się narzędzia Low-code/no-code do AI, umożliwiając budowę aplikacji AI przez osoby niebędące programistami. Skutek to coraz otwarty ekosystem AI, w którym budowa wyspecjalizowanego modelu generatywnego lub rozwiązania opartego o AI jest tańsza i szybsza niż dotychczas. Według branżowych szacunków w 2025 r. 70% nowych aplikacji biznesowych będzie zawierać Low-code/no-code AI. Ta demokratyzacja technologii AI przyspiesza wdrażanie narzędzi i tworzy setki niszowych zastosowań.

- Wydajność i koszty: Miniony rok przyniósł dramatyczny postęp zarówno pod względem mocy modeli, jak i ich efektywności. Z jednej strony topowe modele są ogromne (liczba parametrów sięga setek miliardów lub więcej) i potrafią znacznie więcej – GPT-4 szacuje się na ponad 1,5 biliona parametrów i deklasuje 175-miliardowego GPT-3 w większości zadań. Z drugiej strony, badania i konkurencja drastycznie obniżają koszty. Nowe architektury (jak MoE w Llama 4) i techniki destylacji umożliwiają świetne wyniki przy mniejszym wkładzie obliczeniowym. Warto zauważyć, że chiński otwarty model DeepSeek-R1 został wytrenowany za mniej niż 6 milionów dolarów i zbliża się poziomem rozumowania do GPT-4. Specjalistyczne chipy (GPU Nvidia H100, Google TPU, Amazon Trainium/Inferentia) oraz chmury obliczeniowe obniżyły także koszt pojedynczego zadania AI. Dzięki temu generatywna AI jest skalowalna i opłacalna dla biznesu. Jednak największe treningi nadal wymagają fortuny – wytrenowanie Gemini 1.0 Ultra Google’a kosztowało ponoć niemal 200 milionów dolarów, a trwający trening GPT-5 to rzekomo ponad 500 milionów dolarów. Tylko nieliczni gracze mogą pozwolić sobie na ten poziom wydatków – rodzi to pytania, kto będzie kontrolował najpotężniejsze AI (do tego wracamy w rozdziale etyka/regulacje).

Podsumowując, krajobraz generatywnej AI w 2025 roku charakteryzuje się intensywną innowacją i konkurencją. Giganci jak OpenAI, Google, Meta, Anthropic i Amazon wyznaczają granice rozmiaru modeli, multimodalności i integracji z rzeczywistością, a środowisko open source i mniejsi gracze wnoszą świeżość i utrzymują otwartość rynku. Generatywna AI stała się kluczowym elementem strategii technologicznej – porównywalnym do internetu czy mobile w poprzednich epokach. Dalej pokażemy, jak te zdobycze AI są stosowane w różnych sektorach, zmieniając reguły gry w ochronie zdrowia, rozrywce, programowaniu, edukacji, finansach i nie tylko.

Kluczowe zastosowania w różnych branżach

Wpływ generatywnej AI w 2025 roku obejmuje praktycznie każdą branżę, od sektorów kreatywnych po badania naukowe. Poniżej przedstawiamy, jak ta technologia jest wykorzystywana w kluczowych sektorach, wraz z przykładami zastosowań, które niegdyś były science fiction:

Opieka zdrowotna i medycyna

W opiece zdrowotnej generatywna AI przyspiesza diagnostykę, badania i opiekę nad pacjentami. Asystenci AI w medycynie potrafią streszczać złożoną dokumentację medyczną i literaturę naukową w przystępny sposób, pomagając lekarzom być na bieżąco. Na przykład medyczny LLM Google (seria Med-PaLM) osiągnął poziom ekspercki na egzaminach lekarskich, a niektóre szpitale testują chatboty AI do triage’u objawów lub generowania notatek klinicznych. Generatywne modele pomagają również analizować obrazy medyczne (RTG, MRI) – opisując wyniki lub nawet sugerując diagnozy do weryfikacji przez lekarza. Prawdopodobnie jednak największy wpływ AI ma na odkrywanie leków: sztuczna inteligencja potrafi generować struktury molekularne o pożądanych właściwościach oraz sugerować hipotezy biomedyczne. Przykładem jest AION Labs (konsorcjum firm farmaceutycznych, takich jak AstraZeneca i Pfizer), które wykorzystuje platformy AI do projektowania nowych kandydatów na leki. Trenując na ogromnych zbiorach danych chemicznych i genomowych, generatywne modele proponują nowe cząsteczki leków lub białek w środowisku cyfrowym, znacznie przyspieszając proces R&D. Dzięki temu AION Labs i inne firmy zidentyfikowały obiecujące cele terapeutyczne w ciągu miesięcy, a nie lat. W medycynie precyzyjnej AI symuluje reakcje różnych profili genetycznych na leczenie, umożliwiając bardziej spersonalizowaną opiekę. Pojawiają się także aplikacje dla pacjentów – np. chatboty wspierające zdrowie psychiczne, oferujące coaching w oparciu o CBT lub AI przygotowujące diety i odpowiadające na pytania zdrowotne. Chociaż AI nie zastępuje lekarzy, coraz częściej pełni rolę szybkiego asystenta badawczego i administracyjnego (np. pisze odwołania do ubezpieczycieli, podsumowania wizyt), zostawiając lekarzom więcej czasu na kontakt z pacjentem. Wstępne badania pokazują nawet, że wygenerowane przez AI notatki i plany leczenia mogą być równie spójne, jak te przygotowane przez profesjonalistów (oczywiście pod warunkiem weryfikacji przez człowieka) – sugerując przyszłość, w której znaczną część dokumentacji medycznej zdejmie z lekarzy sztuczna inteligencja. Ogólnie rzecz biorąc, w 2025 roku generatywna AI pomaga uczynić opiekę zdrowotną bardziej opartą na danych, wydajną i dopasowaną do indywidualnych potrzeb pacjentów.

Rozrywka i media

Przemysł rozrywkowy szeroko wykorzystał generatywną AI do tworzenia treści – choć jednocześnie mierzy się z jej burzącym porządek potencjałem. Pisanie scenariuszy i rozwój fabuły są obecnie wspierane przez AI: scenarzyści mogą korzystać z narzędzi generujących dialogi, podpowiadających zwroty akcji czy nawet piszących całe sceny w stylu danego serialu. Faktycznie, niektóre studia eksperymentowały ze scenariuszami generowanymi przez AI dla krótkometrażowych filmów (choć zwykle są one gruntownie edytowane przez ludzi). AI wspiera również tworzenie storyboardów i prewizualizacji filmów – na podstawie scenariusza potrafi wygenerować wstępne obrazy lub animacje scen, ułatwiając reżyserom planowanie ujęć, a zespołom VFX – prototypowanie efektów. Efekty wizualne (VFX) i animacja zostały zrewolucjonizowane: generatywne modele jak DALL·E 3 czy Midjourney służą do tworzenia concept artów, teł czy nawet fotorealistycznych postaci CGI na podstawie tekstu. Pozwala to znacząco skrócić czas projektowania. W latach 2023–2024 widzieliśmy pierwsze zastosowanie wygenerowanych przez AI grafik w produkcji (np. animowana sekwencja tytułowa serialu Marvel wywołała sporo dyskusji). Do 2025 r. narzędzia są coraz bardziej dopracowane – artyści używają AI, by szybko iterować pomysły, a następnie sami doskonalą efekty, łącząc ludzką kreatywność z maszynową szybkością. Gry komputerowe to kolejny obszar: studia korzystają z AI do generowania dialogów postaci niezależnych (NPC), tworzenia dynamicznych linii fabularnych dostosowujących się do wyborów gracza, a nawet tworzenia poziomów lub elementów gry w locie. W najnowocześniejszych tytułach spotkamy bohaterów sterowanych SI, z którymi można prowadzić otwarte konwersacje, co znacząco zwiększa immersję. W muzyce generatywna AI potrafi komponować utwory w stylu znanych artystów (co zapoczątkowało trend „AI mashupów” w internecie). Chociaż oficjalnych wydań z AI wokalami jest jeszcze niewiele ze względu na prawa autorskie, wielu muzyków korzysta z AI jako źródła inspiracji – generując np. melodie lub bity do dalszej obróbki. Produkcja mediów korzysta również z AI przy montażu: istnieją narzędzia analizujące nieobrobiony materiał i sugerujące edycje, a nawet tworzące zwiastuny automatycznie – identyfikując najlepsze fragmenty nagrań. Od strony biznesowej firmy używają AI do lokalizacji treści (automatyczne podkładanie głosów w różnych językach przy zachowaniu ruchu ust aktorów) czy przewidywania preferencji widowni pod kątem celowanego tworzenia treści. Postęp ten rodzi jednak dylematy etyczne (omówione dalej): niedawne protesty hollywoodzkich scenarzystów i aktorów dotyczyły obaw, że AI może zastąpić ich pracę bez wynagrodzenia. W efekcie strajkowi scenarzystów w 2023 r. pojawiły się nowe zapisy w umowach ograniczające wykorzystanie AI do tworzenia scenariuszy bez udziału ludzi. Podsumowując, AI coraz częściej staje się kreatywnym współtwórcą w rozrywce – zwiększając produktywność w animacji, VFX i piśmiennictwie – ale branża podchodzi do innowacji ostrożnie, dbając o prawa twórców.

Tworzenie oprogramowania i IT

Jednym z najwcześniejszych i najentuzjastyczniejszych użytkowników generatywnej AI jest branża programistyczna. Asystenci do kodowania AI są już wszechobecni: narzędzia takie jak GitHub Copilot, Amazon CodeWhisperer czy Tabnine integrują się z edytorami, aby autouzupełniać kod, sugerować funkcje, a nawet generować całe moduły na podstawie komentarzy. Do połowy 2025 r. te narzędzia znacznie się udoskonaliły – nie tylko podpowiadają składnię, ale potrafią projektować całe rozwiązania. Satya Nadella, prezes Microsoftu, informował, że w części projektów AI pisze już 20–30% kodu, który trafia na produkcję. Znacząco przyspiesza to pracę programistów przy rutynowych zadaniach. Poza autouzupełnianiem, generatywne modele potrafią tłumaczyć kod między językami programowania, pisać testy jednostkowe czy diagnostykować błędy, wyjaśniając ich przyczyny. Programiści coraz częściej korzystają z AI jako pierwszego piszącego kod: opisują potrzebną logikę, a AI tworzy szkic implementacji, który następnie jest weryfikowany i dopracowywany przez człowieka. Chmurowe IDE oferują teraz „ChatGPT mode”, gdzie można rozmawiać z AI o kodzie – pytając na przykład „Jak zoptymalizować tę funkcję?” albo „Znajdź podatności w tym repozytorium”. Przykładowo, Claude od Anthropic potrafi wczytać całe repozytorium GitHub (dzięki kontekstowi 100 tys. tokenów), odpowiadać na pytania lub nawet dokonywać zmian. To niemal jak mieć juniora programistę, który przeczytał całą dokumentację projektu. Efekt: szybsze cykle developmentu oraz utrzymanie złożonego kodu mniejszym zespołem. Startupy takie jak Replit wdrażają AI pozwalające budować aplikacje z poziomu rozmowy – użytkownik opowiada, czego potrzebuje, a AI generuje kod, UI i całą logikę. Ten „app from a prompt”, zwany też „vibe codingiem”, dopiero raczkuje, lecz bardzo szybko się rozwija. Poza samym kodowaniem, korzyści czerpie również IT: generatywna AI pisze skrypty konfiguracyjne, szablony infrastructure-as-code czy zapytania SQL na podstawie języka naturalnego. Pomaga też w cyberbezpieczeństwie: analizuje logi sieciowe czy kod złośliwego oprogramowania oraz tłumaczy ich działanie (nie należy jednak zapominać, że cyberprzestępcy również używają AI do pisania nowych malware – trwa swoista „gra w kotka i myszkę”). Kluczowe jest, że ludzie nadal pozostają w procesie – AI może popełniać błędy lub produkować niebezpieczny kod, dlatego potrzebny jest nadzór. Jednak wraz ze wzrostem niezawodności modeli (niektóre potrafią już tłumaczyć swoje rozumowanie dla większej przejrzystości), rośnie też zaufanie do kodu generowanego przez AI. Obserwujemy początki zmiany paradygmatu w programowaniu: od samodzielnego pisania kodu do zarządzania i nadzorowania kodu generowanego przez AI, co z czasem może otworzyć tworzenie oprogramowania dla znacznie szerszego grona osób.

Edukacja i szkolenia

Edukacja została głęboko przekształcona przez generatywną AI, niosąc zarówno ogromne możliwości, jak i wyzwania. Pozytywną stroną jest to, że AI staje się osobistym korepetytorem dostępnym dla każdego ucznia z dostępem do internetu. Uczniowie mogą zadawać pytania konwersacyjnemu AI o każdej porze, otrzymując wyjaśnienia czy rozwiązania krok po kroku. Aplikacje do nauki języków, jak Duolingo, zintegrowały GPT-4, oferując swobodną rozmowę i automatyczną informację zwrotną; co ciekawe, Duolingo przypisuje generatywnej AI możliwość wypuszczenia 148 nowych kursów językowych w ciągu roku, ponad dwukrotnie zwiększając ofertę. Tak szybka ekspansja była możliwa, ponieważ AI pomagała generować treści i zadania, na które zespoły ludzi potrzebowałyby o wiele więcej czasu. W klasach nauczyciele używają AI do tworzenia quizów, streszczeń i planów lekcji pod kątem swojego programu nauczania. Przykładowo, nauczyciel może poprosić AI o uproszczenie rozdziału dla ucznia mającego trudności lub o wygenerowanie ćwiczeń na zawołanie. Systemy tutoringowe wspierane AI (jak Khanmigo od Khan Academy) prowadzą uczniów krok po kroku przez zadania, zadając pytania w stylu sokratycznym i naprowadzając na rozwiązania. Systemy te dostosowują się do tempa i stylu nauki każdego ucznia, urzeczywistniając długo wyczekiwany sen o indywidualnym, masowym nauczaniu. Jednocześnie generatywna AI wywołała obawy o oszustwa i plagiaty. Narzędzia takie jak ChatGPT potrafią pisać eseje czy rozwiązywać zadania z matematyki, co początkowo spowodowało wzrost „prac domowych wspomaganych AI”. Wywołało to debaty dotyczące uczciwości akademickiej i rozwój narzędzi do wykrywania AI (które bywają omylne, bo zmiana promptów czy parafrazowanie potrafi je oszukać). Trenerzy coraz częściej zmieniają strategię: zamiast zakazywać AI, wdrażają ją w naukę – ucząc, jak korzystać z niej odpowiedzialnie jako narzędzia badawczego i wspierającego pisanie, przy jednoczesnym nacisku na krytyczne myślenie i oryginalność. Jest też trend aktualizacji podstawy programowej o edukację AI, tak by uczniowie rozumieli zarówno jej możliwości, jak i ograniczenia. Na uczelniach i szkoleniach zawodowych generatywna AI umożliwia symulacje: np. studenci biznesu wcielają się w role klientów lub rekruterów HR i mogą trenować realistyczne rozmowy. Medycy praktykują wywiady z pacjentami AI. Zdolność AI do przyjmowania różnych ról i udzielania spersonalizowanej informacji zwrotnej okazuje się nieoceniona w treningu umiejętności. Podsumowując: w edukacji 2025 roku generatywna AI jest jak obosieczny miecz – potrafi spersonalizować i wzbogacić naukę, ale wymaga nowych podejść, by uczniowie nadal nabywali podstawowe kompetencje i etykę w świecie wspieranym przez AI.

Finanse i biznes

Branża finansowa, ze względu na duże potrzeby przetwarzania informacji, szybko zaadaptowała generatywną sztuczną inteligencję, aby zwiększyć efektywność i uzyskać nowe wglądy — jednocześnie poruszając się w ramach ograniczeń regulacyjnych. Jednym z głównych zastosowań jest wiedza asystująca dla profesjonalistów finansowych. Na przykład Morgan Stanley wprowadził wewnętrznego asystenta opartego na GPT-4 dla swoich doradców majątkowych. Ta SI, dostrojona do dokumentów badawczych i polityk firmy, pozwala doradcom zadawać szybkie pytania — „Co mówił nasz ostatni raport kwartalny o wynikach Apple?” — i błyskawicznie otrzymywać podsumowanie z odniesieniami. Może także tworzyć robocze maile do klientów podsumowujące notatki ze spotkań (narzędzie o trafnej nazwie „Debrief”). Bank of America także korzysta z AI, by pomóc pracownikom odnajdywać informacje w złożonych instrukcjach dotyczących zgodności czy produktów. W bankowości inwestycyjnej i badaniach, generatywna SI służy do podsumowywania raportów finansowych, wiadomości i sprawozdań. Zamiast przeglądać 200-stronicowe dokumenty typu 10-K, analitycy mogą poprosić sztuczną inteligencję o wyłuskanie kluczowych informacji lub nawet uzyskanie odpowiedzi na pytania dotyczące finansów firmy. Niektóre fundusze hedgingowe eksperymentują z SI, aby generować syntetyczne dane do modelowania lub do pisania podstawowych analiz rynkowych. Chatboty obsługujące klientów w bankowości stały się dzięki LLM znacznie bardziej konwersacyjne i kompetentne — obsługują wszystko: od resetowania haseł po udzielanie informacji o oprocentowaniach kredytów hipotecznych w naturalny, ludzki sposób. JPMorgan i inne początkowo były ostrożne (nawet zakazując używania ChatGPT na początku 2023 roku z obawy o prywatność danych), ale do 2025 roku wiele firm wdrożyło dostrojone modele wewnętrzne, by żadne wrażliwe dane nie opuszczały serwerów. Te agenty AI redukują czas oczekiwania i pracują 24/7, choć są ściśle monitorowane pod kątem poprawności. W ubezpieczeniach i pożyczkach generatywna SI pomaga tworzyć spersonalizowane dokumenty polis i upraszczać żargon prawny dla klientów. Niektóre firmy wykorzystują SI do analizowania opisów roszczeń lub wniosków kredytowych i streszczania najważniejszych detali dla underwriterów. Dodatkowo, SI znalazła miejsce w edukacji finansowej i doradztwie: aplikacje fintech oferują doradców SI, którzy tłumaczą początkującym inwestorom możliwe opcje inwestycyjne prostym językiem lub generują spersonalizowany budżet i plan oszczędnościowy na podstawie celów użytkownika. Jednym z wyróżniających się obszarów jest wykrywanie nadużyć i zgodność — chociaż to głównie domena analityki predykcyjnej, generatywna SI asystuje, tworząc realistyczne scenariusze oszustw do szkoleń systemów oraz interpretując nierzadko nieustrukturyzowane dane wymagane do zgodności (np. analizując teksty ustaw i streszczając wymagania dla banku). Oczywiście, mocno regulowany charakter finansów sprawia, że wyniki AI są wykorzystywane ostrożnie. Każda treść AI skierowana do klienta zwykle przechodzi kontrolę zgodności. Nieprawidłowe informacje finansowe czy porady mogą mieć poważne konsekwencje, dlatego firmy są ostrożne w pełnej automatyzacji takich zadań. Mimo to trudno nie zauważyć wzrostu efektywności: rutynowe sporządzanie raportów finansowych, pisanie notatek wewnętrznych i analizę danych można w dużej mierze powierzyć SI, wzbogaconą o nadzór człowieka. W przyszłości, wraz z doprecyzowaniem regulacji i wzrostem niezawodności modeli, można oczekiwać jeszcze szerszej adopcji — być może SI przejmie częściowe przygotowywanie deklaracji podatkowych, audytów lub zarządzania portfelem pod nadzorem. Póki co, generatywna AI w finansach działa jako potężny współpilot, przyspieszając procesy i czyniąc dane finansowe bardziej dostępnymi zarówno dla specjalistów, jak i klientów.

Inne branże i zastosowania

Poza powyższymi przykładami, praktycznie każda branża ma pionierów kreatywnie wykorzystujących generatywną SI:

- Marketing i reklama: Generatywna SI to ogromne wsparcie dla działów marketingu. Może natychmiast wygenerować dziesiątki wariantów tekstów reklam, postów na media społecznościowe lub opisów produktów, celowanych do różnych grup odbiorców. Marketerzy używają generatorów obrazów AI (Midjourney, DALL·E), by tworzyć indywidualne wizualizacje kampanii bez konieczności organizowania pełnej sesji fotograficznej. Personalizowany marketing na dużą skalę stał się realny — np. sklepy internetowe automatycznie tworzą spersonalizowane rekomendacje produktów i promocyjne e-maile, pisane w stylu dopasowanym do każdego klienta na podstawie jego profilu. Niektóre firmy wykorzystują AI nawet do generowania pomysłów na branding i sloganów, prowadząc burzę mózgów z kreatywnym asystentem. Minusem są jednak obawy o deepfake’i reklamowe lub dezinformację w reklamach politycznych generowanych przez SI, czemu przyglądają się regulatorzy.

- Prawo i usługi prawne: Prawnicy zaczęli wykorzystywać SI do tworzenia dokumentów prawnych (umów, testamentów, szablonów NDA), opisując wymagania zwykłym językiem. SI potrafi też szybko streszczać orzecznictwo i precedensy — zastępując godziny pracy paralegalów jednym zapytaniem. Startupy oferują narzędzia AI „co-counsel”, wspomagające przygotowywanie pism procesowych i sprawdzanie spójności dokumentacji. Przy rutynowych sprawach, jak formularze zgodności czy wnioski patentowe, generatywna SI wypełnia luki i wskazuje fragmenty wymagające decyzji człowieka. Warto wspomnieć, że w połowie 2023 roku jeden adwokat doświadczył kompromitacji, przedkładając pismo pełne fikcyjnych cytatów stworzonych przez ChatGPT; w 2025 roku prawnicy są już bardziej świadomi — korzystają z siły SI, ale sprawdzają efekty jej pracy. Sądy i ustawodawcy także zastanawiają się, jak SI może pomóc w procesach prawnych (np. upraszczając język prawny dla społeczeństwa). Jednak wytyczne etyczne doradzają obecnie adwokatom ujawnienie, jeśli SI była użyta przy tworzeniu dokumentu, zapewniając rozliczalność.

- Produkcja i inżynieria: Generatywna SI wspomaga projektowanie inżynierskie poprzez generatywne projektowanie — algorytmy tworzą optymalne projekty komponentów na podstawie zadanych kryteriów funkcjonalnych. Przykładowo, firma lotnicza może poprosić SI o zaprojektowanie jak najlżejszego wspornika, który wytrzyma określone siły, a SI wygeneruje kształty (często bardzo organiczne), na które inżynierowie mogliby nie wpaść. Było to możliwe już wcześniej, ale nowe modele generatywne upraszczają obsługę przez interfejsy językowe i mogą nawet tworzyć projekty gotowe do druku 3D. W produkcji SI tworzy syntetyczne dane z czujników do trenowania modeli predykcji awarii (gdy rzeczywiste dane są rzadkie). Napędza również bardziej zaawansowaną robotykę: roboty z „mózgami” AI, które potrafią rozumować o swoich instrukcjach. Jedna z fabryk testowała system SI, który można było poprosić w języku naturalnym: „sprawdź maszynę 4 i wykonaj serwis, jeśli trzeba”, a SI generowała dla robota instrukcję krok po kroku. Wstępne rezultaty są obiecujące, choć standardy niezawodności przemysłowej pozostają wyśrubowane.

- Architektura i planowanie przestrzenne: Architekci korzystają z narzędzi generatywnej SI do wymyślania nowatorskich projektów budynków czy aranżacji wnętrz. Po określeniu wymaganych cech (np. „dom 3-pokojowy na wąskiej działce, dużo światła dziennego, styl modernistyczny”) AI generuje wiele układów oraz rendery 3D w kilka minut. Wzbogaca to kreatywność architekta, dostarczając pomysły do dalszego dopracowania. Planiści miejscy mogą symulować różne koncepcje zagospodarowania, a SI tworzy wizualizacje parku czy nowej zabudowy, a nawet ocenia wpływ na środowisko (np. generowanie map temperatur czy ruchu na podstawie danych).

- Obsługa klienta i handel detaliczny: Chatboty SI stały się w wielu sektorach (telekomunikacja, sprzedaż, podróże) pierwszą linią kontaktu z klientem. W przeciwieństwie do dawnych sztywnych botów, generatorowe SI radzi sobie z chaotycznymi, różnorodnymi sposobami zadawania pytań przez użytkowników. Rozumie kontekst nawet długiej rozmowy, udziela pomocnych odpowiedzi lub podejmuje działania (np. obsługuje zwrot towaru czy zmianę rezerwacji lotu) w uprzejmy, ludzki sposób. Detaliści używają SI także do dynamicznego generowania rekomendacji produktów i porad stylizacyjnych — np. aplikacja sklepu odzieżowego pozwala „porozmawiać” z AI-stylistą, który podpowiada zestawy ubrań, wybierając spośród najnowszego katalogu. Ponadto, asystenci głosowi AI trafiają do call center jako wsparcie dla konsultantów — SI zapisuje rozmowę w czasie rzeczywistym i podpowiada odpowiedzi lub kolejne kroki, przyspieszając obsługę klienta.

To zaledwie wierzchołek góry lodowej. Od rolnictwa (gdzie drony SI generują indywidualne plany ochrony upraw) po eksplorację kosmosu (NASA testuje AI do generowania i samodzielnej realizacji skryptów operacji satelitarnych), generatywna SI odciska swoje piętno. Wszędzie tam, gdzie jest coś do stworzenia, dane do syntezy lub interakcje do skalowania, ludzie znajdują dla tych modeli zastosowanie. Jak ujął to jeden z analityków w 2025 roku: „AI szybko staje się narzędziem niezbędnym w każdej branży” — organizacje, które ją wdrożą, mogą zyskać na efektywności i innowacyjności, a te, które tego nie zrobią — ryzykują pozostaniem w tyle.

Obawy etyczne i dyskusje regulacyjne

Z wielką mocą wiąże się wielka odpowiedzialność — gwałtowny wzrost znaczenia generatywnej SI wywołał gorące debaty etyczne i wezwania do regulacji. Do 2025 roku na pierwszy plan wysuwa się kilka kluczowych obaw:

- Halucynacje i dezinformacja: Modele generatywne potrafią generować fałszywe lub wprowadzające w błąd treści z niepokojącą pewnością siebie. Te „halucynacje” to zarówno drobne błędy faktograficzne, jak i tworzenie fikcyjnych cytowań naukowych (co słynnie zmyliło prawników w 2023 roku). Istnieje ryzyko, że użytkownicy potraktują wyniki SI jako prawdę, przyczyniając się do szerzenia dezinformacji. Jeszcze poważniejsze jest wykorzystanie generatywnej SI do produkcji i dystrybucji dezinformacji — np. tworzenie realistycznych fałszywych artykułów, podrobionych zdjęć wydarzeń, które nigdy się nie wydarzyły, czy syntetycznych nagrań publicznych osób wypowiadających słowa, których nigdy nie powiedziały. W miarę zbliżania się wyborów (np. wybory w USA w 2024 r. były poligonem doświadczalnym), regulatorzy coraz bardziej obawiają się propagandy i deepfake’ów zalewających media społecznościowe. Firmy AI wdrożyły pewne zabezpieczenia: modele odmawiają spełniania oczywistych próśb o generowanie dezinformacji lub propagandy przemocy, a naukowcy pracują nad udoskonaleniem treningu modeli pod kątem prawdziwości. Niemniej jednak, żadna SI nie jest w 100% wolna od halucynacji. To prowadzi do rozwoju świadomości AI — edukowania społeczeństwa, że „AI może być pewnie w błędzie” i zachęcania do krytycznego myślenia o treściach generowanych przez SI. Pojawiają się też rozwiązania techniczne, takie jak używanie narzędzi (model przekierowuje zapytanie do bazy wiedzy lub kalkulatora przy sprawach faktograficznych), co stosują GPT-4 i inne dla poprawy dokładności.

- Uprzedzenia, sprawiedliwość i nadużycia: Generatywne SI uczą się na ogromnych zbiorach ludzkich treści, które nieuchronnie zawierają uprzedzenia (kulturowe, płciowe, rasowe itd.). Bez odpowiednich zabezpieczeń modele mogą generować dyskryminujące lub obraźliwe treści — np. przejawiać uprzedzenia płciowe w symulacjach ról zawodowych czy stosować stereotypy w opowiadaniach. Firmy takie jak OpenAI i Anthropic starają się temu zaradzić przez techniki „alignment” i filtry treści, ale wyważenie jest trudne. Wczesne próby prowadziły do tzw. „nadmiernej cenzury”, gdy modele odmawiały także całkowicie niewinnych próśb. Do 2025 roku techniki typu Constitutional AI (podejście Anthropic, gdzie SI otrzymuje zbiór zasad etycznych do przestrzegania) znacznie poprawiły jakość wyników i ograniczyły produkcję jawnie szkodliwych treści. Nadal jednak uprzedzenia mogą być subtelne i zależne od kontekstu — niezbędny jest ciągły nadzór. Zdolność generowania mowy nienawiści lub treści ekstremistycznych na żądanie to kolejne zagrożenie — firmy generalnie tego zakazują, lecz zdeterminowani użytkownicy mogą fence’ować modele (tworzyć takie prompt’y, by obejść zasady) lub używać modeli open-source z mniejszą liczbą zabezpieczeń. To rodzi pytania: czy pewne zastosowania SI powinny być nielegalne? Kilka jurysdykcji rozważa już ustawy zakazujące użycia SI do generowania skrajnej propagandy nienawiści lub materiałów związanych z wykorzystywaniem dzieci. Wdrożenie takich zakazów jest jednak trudne ze względu na globalny zasięg technologii.

- Prywatność i ochrona danych: Modele generatywne są trenowane na olbrzymich zbiorach danych z internetu — które mogą zawierać dane osobowe lub materiały chronione prawem autorskim pozyskane bez zgody. Osoby prywatne odkryły, że ich dane lub twórczość pojawiają się w odpowiedziach SI. To wywołało debatę o legalności trenowania na danych publicznych. AI Act UE oraz liczne pozwy wymuszają większą przejrzystość: nowe przepisy prawdopodobnie będą wymagały od dostawców SI ujawniania źródeł danych i zabezpieczenia materiałów chronionych prawem autorskim. Włochy na krótko zablokowały ChatGPT w 2023 r. z powodu obaw o prywatność, kiedy okazało się, że SI czasami przytaczała fragmenty tekstów zawierających dane osobowe z treningu. OpenAI odpowiedziało, umożliwiając użytkownikom wyłączenie wykorzystywania historii czatów do szkoleń, a oferty korporacyjne gwarantują izolację danych klientów. Mimo to organizacje dbające o prywatność nadal obawiają się, że generatywne SI mogą zostać wykorzystane do wyciągania wrażliwych informacji. Przykładowo, SI można nakłonić za pomocą sprytnych zapytań do ujawnienia informacji, które widziała podczas treningu (np. czyjegoś adresu z wycieku danych). Odpowiedzialne firmy AI pracują nad ograniczeniem tego ryzyka, a AI Act UE jednoznacznie klasyfikuje systemy SI mogące naruszać prawa podstawowe jako „wysokiego ryzyka”, poddając je ścisłej kontroli danych i nadzorowi. Akt wymaga również, by treści generowane przez SI były możliwe do rozpoznania — np. systemy mają informować „nie jestem człowiekiem”, a niektóre treści, jak deepfake’i, muszą mieć znak wodny lub etykietę zgodnie z prawem. Ma to na celu zachowanie zaufania i jasności w kontaktach z SI.

- Prawa autorskie (IP) i własność: Głównym frontem sporu prawnego jest wykorzystanie przez SI materiałów chronionych prawem autorskim. Artyści, pisarze, fotografowie i inni twórcy są zaniepokojeni, iż modele generatywne trenowane na ich dziełach mogą teraz tworzyć „nową” zawartość w tym samym stylu — potencjalnie odbierając im dochód. W latach 2023–2024 złożono kilka pozwów (np. artystów wizualnych przeciwko Stability AI i Midjourney, pisarzy przeciwko OpenAI i Meta), zarzucając, że użycie chronionych utworów do treningu bez zgody narusza prawo. Kontrargumentem jest, że uczenie SI to „użytek transformacyjny” — analogiczny do tego, jak człowiek uczy się na przykładach, co może mieścić się w ramach dozwolonego użytku. Jak dotąd, sądy nie dały jednoznacznej odpowiedzi (stan na 2025), więc panuje szara strefa. Tymczasem niektóre firmy wybierają podejście „czystych danych” — trenują modele wyłącznie na licencjonowanych lub dostępnych publicznie zbiorach, by unikać ryzyka prawnego. Na przykład generator obrazów Firefly od Adobe korzysta wyłącznie z licencjonowanych zdjęć, więc firmy nie muszą się obawiać o wykorzystanie efektów. Getty Images buduje SI wyłącznie w oparciu o własną bazę obrazów. Są także propozycje wynagradzania twórców: np. wspólna licencja lub system tantiem, dzięki któremu jeśli SI jest wykorzystywana komercyjnie, osoby, których dzieła znalazły się w zbiorze treningowym, otrzymują niewielką część z zysku. Nie ma jeszcze standardów, ale dialog między branżą tech a środowiskiem twórców trwa. Wynik tego sporu zdeterminuje przyszłość produkcji treści — czy znajdziemy symbiozę, w której narzędzia AI wspomagają i wynagradzają twórców, czy raczej czeka nas scenariusz restrykcyjny i duże ograniczenia SI w trosce o prawa autorskie.

- Wpływ na rynek pracy i gospodarkę: Jedną z najważniejszych kwestii społecznych jest to, jak generatywna SI wpłynie na miejsca pracy i gospodarkę. Jak opisaliśmy, SI automatyzuje zadania związane z pisaniem, kodowaniem, obsługą klienta itd. — budząc obawy o likwidację wielu stanowisk lub głębokie przekształcenie zawodów. Badania firm konsultingowych wskazują, że do 2030 r. znaczna część pracy może zostać zautomatyzowana; przykładem, McKinsey szacował, iż około 30% godzin pracy w amerykańskiej gospodarce może zostać zautomatyzowanych do 2030 dzięki rozwojowi SI. Najbardziej zagrożone to stanowiska związane z powtarzalnym tworzeniem treści lub analizą danych (paralegale, copywriterzy, juniorzy programiści, konsultanci call center). Już teraz firmy rezygnują z obsadzania niektórych stanowisk juniorskich, wykorzystując narzędzia SI do zadań jak pisanie maili marketingowych czy podstawowe research’e prawne. Jednak wcześniejsze fale automatyzacji pokazują, że gdy jedni tracą pracę, inni ją zyskują, a wzrost wydajności może tworzyć nowe możliwości. W 2025 jesteśmy na rozdrożu: pracownicy w wielu branżach podnoszą kompetencje, by współpracować z SI (np. grafik musi znać się na promptowaniu i pracy z obrazami AI). Często podkreślany jest model „AI jako współpilota” — SI wykonuje żmudne zadania, a ludzie skupiają się na kreatywności, strategii i kontaktach osobistych. Przykładowo, zamiast 10 konsultantów każdy obsługuje własny zestaw zapytań, w przyszłości może być 5 konsultantów nadzorujących SI obsługujące większość czatów — agenci wkraczają przy bardziej skomplikowanych sprawach i poprawiają odpowiedzi SI. Oznacza to, że wydajność może gwałtownie wzrosnąć, ale społeczeństwo będzie musiało zarządzić tą transformacją — zadbać o możliwość przekwalifikowania i by korzyści z rozwoju SI były szeroko dzielone. Wśród rekomendacji politycznych pojawiają się: wzmacnianie edukacji cyfrowej i w kompetencjach AI, tworzenie zabezpieczeń socjalnych lub nawet wprowadzenie dochodu podstawowego oraz rozważenie skrócenia tygodnia pracy, jeśli produktywność wzrośnie skokowo. Kolejna sekcja, poświęcona prognozom, rozwinie ewentualne zmiany na rynku pracy.

- Alignment SI i ryzyka egzystencjalne: Na bardziej radykalnym końcu spektrum etycznego pojawia się pytanie — czy zaawansowane systemy SI mogą stać się niekontrolowane lub wręcz stanowić zagrożenie egzystencjalne? Obecne generatywne SI są bardzo dalekie od filmowych superinteligencji, ale tempo rozwoju sprawia, że część ekspertów ostrzega przed długoterminowymi zagrożeniami, gdyby SI przewyższyła człowieka i działała wbrew naszym interesom. W 2023 ponad tysiąc liderów świata tech (m.in. Elon Musk, pionierzy AI) podpisało list otwarty z postulatem 6-miesięcznego moratorium na trenowanie najmocniejszych modeli, argumentując potrzebę badań bezpieczeństwa „wszechmocnych systemów SI”. Choć przerwa nie nastąpiła, list wywołał dyskusję o alignment SI (utrzymaniu zgodności celów SI z wartościami człowieka) i zarządzaniu. W 2025 organizacje takie jak OpenAI powołały zespoły do badań nad bezpiecznym rozwojem SI, a współpraca międzynarodowa już trwa (Wielka Brytania zorganizowała globalny AI Safety Summit pod koniec 2024 r. nt. zagrożeń od czołowych modeli SI). Nawet bez wchodzenia w scenariusze katastroficzne, niezestrojona SI może powodować poważne problemy — wyobraźmy sobie autonomiczne SI zarządzające handlem giełdowym powodujące „flash crash”, czy automatyczne systemy infrastruktury, które zawiodą w nieprzewidziany sposób. Dlatego regulatorzy rozważają instrumenty takie, jak licencjonowanie bardzo zaawansowanych modeli, audyty oraz wymóg wdrożenia w SI „wyłączników bezpieczeństwa”. Najwięksi twórcy SI (OpenAI, DeepMind, Anthropic) zobowiązali się wspólnie do testowania nowych modeli pod kątem zdolności do niebezpiecznych działań (np. projektowania broni chemicznej czy przygotowywania cyberataków) i współpracy w tworzeniu standardów bezpieczeństwa. To dynamicznie rozwijająca się dziedzina etycznego nadzoru: jak czerpać korzyści z SI i jednocześnie pewnie ograniczać ryzyka najgorszych scenariuszy.

- Odpowiedź regulacyjna: Rządy na całym świecie dostrzegły konieczność wprowadzenia regulacji związanych z SI, choć ścieżki są różne. AI Act Unii Europejskiej jest najpełniejszym do tej pory ramowym rozwiązaniem — uchwalony w 2024 r., zaczyna obowiązywać fazami do 2025–2026. Akt stosuje podejście oparte na ocenie ryzyka: pewne praktyki SI uznaje za „niedopuszczalne” i zakazuje ich wprost (np. scoring społeczny, rozpoznawanie twarzy w czasie rzeczywistym w miejscach publicznych), systemom o wysokim ryzyku (np. SI w zdrowiu, finansach, policji) nakłada ścisłe wymogi, a wobec AI ogólnego przeznaczenia (General Purpose AI, GPAI), jak duże modele językowe, wprowadza obowiązki przejrzystości, bezpieczeństwa i oznaczania treści. Dostawcy GPAI będą musieli rejestrować swoje modele w urzędach UE, dokumentować dane treningowe, oceniać i łagodzić ryzyka oraz wdrożyć zabezpieczenia przed komercyjną premierą. Przepisy dot. GPAI mają wejść w życie w sierpniu 2025, więc firmy już teraz intensywnie pracują nad zgodnością (i naciskają na możliwe korekty przepisów). W USA nie obowiązuje jeszcze jedna ustawa SI, ale są ruchy w tym kierunku: Biały Dom ogłosił niewiążący „AI Bill of Rights” (zasady poszanowania prywatności, wyjaśnialności itd.), a pod koniec 2024 r. wydano Executive Order on AI, nakazujące m.in. twórcom najmocniejszych modeli udostępniać wyniki testów bezpieczeństwa rządowi i rozwijać znakowanie treści SI. Kongres prowadzi przesłuchania (nawet CEO OpenAI Sam Altman namawiał do regulacji) i rozważa ustawę, choć podejście będzie raczej łagodniejsze niż europejskie. Chiny wdrożyły tymczasowe przepisy nt. generatywnej SI w 2023 r., nakazując platformom SI cenzurowanie zakazanych treści i rejestrację algorytmów w urzędach. Teraz dopracowują prawo, by lepiej pogodzić kontrolę i innowacyjność gdy chińscy giganci tech (Baidu, Alibaba) rozwijają własne modele. UK i Kanada mają własne propozycje regulacyjne oparte raczej na nadzorze sektorowym niż jednej nowej ustawie. Ciałami międzynarodowymi pracującymi nad governance AI są ONZ i OECD. Warto odnotować dobrowolne zobowiązania największych firm AI (OpenAI, Google, Meta) w 2025: zewnętrzny redteaming, znakowanie multimediów tworzonych przez SI, dzielenie się dobrymi praktykami — swoista samoregulacja zachęcana przez rządy.

Podsumowując, rok 2025 jest kluczowym momentem dla ustanowienia ram etycznych i prawnych dla generatywnej SI. Panuje szeroka zgoda, że kwestie przejrzystości („czy ta treść została wygenerowana przez SI?”) i odpowiedzialności (odpowiedzialność prawna, gdy SI wyrządzi szkodę) trzeba uregulować dla utrzymania zaufania społecznego. Sztuką będzie wdrożyć to tak, by nie zahamować innowacji. Jednak kierunek jest jasny: generatywna SI nie działa już w zupełnie nieuregulowanym „dzikim Zachodzie”; decydenci aktywnie kształtują jej odpowiedzialny rozwój. Jeśli uda się im to zrobić dobrze, pozwoli to wykorzystać niezwykłe możliwości SI, jednocześnie minimalizując zagrożenia i zapobiegając nadużyciom.

Prognozy na następne 1, 5 i 10 lat

Co czeka generatywną sztuczną inteligencję w przyszłości? To trudne pytanie, biorąc pod uwagę szybki rozwój tej technologii – jednak obecne trendy i analizy ekspertów dają pewne wskazówki. Poniżej prezentujemy prognozy na najbliższą przyszłość (1 rok), średnioterminową (5 lat) oraz długoterminową (10 lat). Obejmują one przewidywane postępy techniczne, wzrost rynku oraz szerzej pojmowane transformacje, których możemy się spodziewać w społeczeństwie i przemyśle.

Szacowana wielkość rynku generatywnej AI do 2030 r. Przewiduje się, że globalny rynek wzrośnie z poniżej 20 miliardów dolarów w 2024 r. do ponad 100 miliardów dolarów do 2030 r., co odpowiada eksplozji wzrostu na poziomie ok. 37% rocznie grandviewresearch.com.

Krótki termin (do połowy 2026 roku)

W ciągu najbliższego roku możemy spodziewać się wzmożonej konkurencji i częstych aktualizacji w dziedzinie generatywnej AI. Powszechnie oczekuje się, że GPT-5 od OpenAI zostanie wydany do końca 2025 roku, biorąc pod uwagę, że GPT-4.5 pojawił się na początku 2025 roku, a OpenAI sygnalizowało, że GPT-5 jest już „kwestią miesięcy”. Jeśli GPT-5 się pojawi, prawdopodobnie przyniesie ulepszenia w zakresie niezawodności (mniej halucynacji), dłuższy kontekst (być może >100 tys. tokenów) oraz bardziej zaawansowane zdolności rozumowania explodingtopics.com explodingtopics.com. Podobnie Google prawdopodobnie rozwijać będzie swój model Gemini (może Gemini 3.0) i jeszcze głębiej zintegruje AI ze swoimi produktami – możemy spodziewać się głębszego zakorzenienia AI w Androidzie, Google Workspace i codziennych narzędziach. W świecie open source Meta może wypuścić większe modele Llama 4 (wykraczające poza Scout i Maverick), a nawet Llama 5, jeśli utrzymają tempo rozwoju. Chińskie firmy, takie jak Baidu (z ERNIE botem), Alibaba i Huawei prawdopodobnie zmniejszą dystans do zachodnich modeli, zwłaszcza dzięki solidnym inwestycjom w szkolenie (rząd Chin uznaje AI za strategiczną). Multimodalność stanie się standardem – do 2026 roku każdy konkurencyjny asystent AI będzie musiał obsługiwać głos, tekst i obrazy jednocześnie. Zobaczymy także lepsze agenty AI: oczekiwany jest postęp w ramach takich, jak AutoGPT i nowych produktów, które będą w stanie autonomicznie wykonywać wieloetapowe zadania (np. AI planująca wakacje — rezerwacja lotów, hoteli, tworzenie planu podróży — przy minimalnym nakładzie ze strony użytkownika). Niektóre z tych rozwiązań mogą być oparte na integracji dużych modeli językowych z narzędziami/wtyczkami i mniejszymi specjalistycznymi modelami (nowy trend w architekturze: wykorzystanie dużego modelu do orkiestracji wielu wyspecjalizowanych narzędzi).

W zakresie wdrażania w przemyśle nadchodzący rok przyniesie AI „kopilotów” do każdej dziedziny zawodowej. Copilot w Microsoft 365 (asystent AI w aplikacjach Office) będzie prawdopodobnie powszechnie dostępny i szeroko używany, co oznacza, że miliony osób będą codziennie korzystać z AI do redagowania e-maili, podsumowywania spotkań czy generowania formuł w Excelu. Google wprowadzi swoje Duet AI w Google Docs/Sheets/Gmail, wykonując podobne zadania. Tak powszechna obecność AI w pracy może szybko znormalizować użycie generatywnej AI – stanie się ona czymś tak powszednim jak korektor pisowni. Możemy też zobaczyć pierwszych mainstreamowych asystentów osobistych napędzanych AI wykraczających poza głośniki smart: coś na wzór JARVISa z Iron Mana, ale w naszym telefonie lub okularach AR, może być już prezentowane przez firmy technologiczne. W chmurze pojawi się jeszcze więcej ofert „modeli bazowych jako usługa” – Amazon, Microsoft, Google i Oracle będą rywalizować o hostowanie nie tylko własnych modeli, lecz także wielu modeli firm trzecich dla biznesu, gdyż firmy unikają czasochłonnego szkolenia modeli od podstaw. W rezultacie rynek oprogramowania i usług opartych na generatywnej AI gwałtownie się powiększy w najbliższym czasie. Analitycy przewidują wartość rynku generatywnej AI w 2025 roku na ok. 30-40 miliardów dolarów, a w 2026 może ona osiągnąć 60–70+ miliardów dolarów wraz z przyspieszającym wdrażaniem (niektóre źródła prognozują ok. 66,9 mld dolarów już w 2025 r., co może oznaczać nawet 100 mld dolarów w 2026 przy obecnych tempach wzrostu).

Jeśli chodzi o regulacje, pierwsze wymogi unijnego aktu o AI wejdą w życie w latach 2025–26. Oznacza to, że firmy wdrażające generatywną AI w Europie będą musiały m.in. ujawniać treści generowane przez AI (np. znakowanie/wodooddrukowywanie obrazów generowanych przez AI do końca 2025 r.) i rozpoczną rejestrację zastosowań wysokiego ryzyka. Możemy zobaczyć pierwsze kary lub egzekwowanie przepisów, jeśli system AI zostanie uznany za naruszający te zasady. W USA do 2026 roku może pojawić się przynajmniej ogólna rama nadzoru nad AI – być może coś w rodzaju „FDA dla algorytmów” lub obowiązkowy audyt dla systemów powyżej określonych możliwości. Krótkoterminowo jednak regulacje prawdopodobnie będą krok za technologią, dlatego to na firmach spoczywa obowiązek samoregulacji, a opinia publiczna powinna nadal krytycznie podchodzić do treści generowanych przez AI.

Kolejny nadchodzący trend: konsolidacja i przetasowania na rynku biznesowym. W ostatnich dwóch latach mieliśmy do czynienia z wysypem startupów AI; w latach 2024–25 wiele z nich albo zostanie przejętych przez większe firmy, albo nie wytrzyma konkurencji, kiedy giganci zaoferują podobne funkcje za darmo. Przykładowo, mniejsze firmy oferujące asystentów programowania mogą mieć trudności, jeśli Microsoft czy Amazon dodadzą takie rozwiązania do swoich produktów. Jednak niszowi gracze z wyjątkowymi danymi lub specyficznymi modelami (np. AI wyszkolona wyłącznie na umowach prawnych) mogą sobie świetnie poradzić lub zostać przejęci dla technologii. Spodziewajmy się także nowych graczy z innych regionów – możemy usłyszeć o „indyjskiej” lub „europejskiej” odpowiedzi na ChatGPT (zapewne zbudowanej na otwartych modelach).

Wreszcie w wymiarze społecznym, do 2026 roku zobaczymy wyraźniejsze dostosowanie kulturowe do AI. Szkoły będą mieć formalne polityki dotyczące pracy wspieranej przez AI, media opracują standardy wobec treści generowanych przez AI, a ogół społeczeństwa stanie się bardziej wprawny w rozpoznawaniu (lub przynajmniej podejrzewaniu) mediów generowanych przez AI. Hype może nieco ostygnąć z powodu rutynizacji AI – jednak każde większe przełomowe wydarzenie (np. AI przekonująco przechodząca test Turinga lub wykazująca zupełnie nowe zdolności rozumowania) może ponownie wywołać ogromny entuzjazm. Ogólnie rzecz biorąc, za rok będziemy mieć umiarkowanie potężniejsze modele, znacznie więcej zastosowań AI w życiu codziennym i pierwsze „barierki ochronne” regulacyjne.

Perspektywa 5-letnia (2030)

Patrząc pięć lat do przodu, na rok 2030, generatywna AI będzie głęboko zakorzeniona w tkance społeczeństwa i biznesu – zarówno w przewidywalny, jak i zupełnie nieoczekiwany sposób. Jeśli obecne tempo wzrostu się utrzyma, rynek generatywnej AI będzie ogromny – szacunki mówią o rynku rzędu ponad 100 miliardów dolarów do 2030 roku. W rzeczywistości jeden z raportów branżowych prognozuje ok. 109 miliardów dolarów w 2030 roku, z ok. 17 mld w 2024 grandviewresearch.com – to wzrost wręcz zadziwiający. Tak dynamiczny rozwój będzie napędzany szerokim wdrożeniem w przedsiębiorstwach, nowymi aplikacjami konsumenckimi i ciągłym doskonaleniem technologii.

Na froncie technologicznym do 2030 roku modele generatywne będą znacznie bardziej zaawansowane niż dziś. Prawdopodobnie doczekamy się kilku nowych generacji: GPT-6 lub 7, Google Gemini 4 lub 5 itd. Te modele mogą zbliżać się do poziomu, który niektórzy określają jako „ogólna sztuczna inteligencja” (AGI) – niekoniecznie oznaczającego świadomość ludzką, ale zdolność do realizowania bardzo szerokiej gamy zadań intelektualnych na poziomie zbliżonym lub wyższym od człowieka. Co więcej, prognozy ekspertów z ostatnich lat przyspieszyły: niedawno uważano, że taka AI to perspektywa kilku dekad, jednak najnowsze przełomy znacznie skróciły te prognozy. McKinsey zauważyło, że osiągnięcie przez AI poziomu ludzkiego w wielu zadaniach technicznych przewidywane jest obecnie na lata 30. XXI wieku, 20–30 lat szybciej niż sądzono przed GPT-4. W 2030 roku jest wiarygodne, że AI przekroczy test Turinga w sposób przekonujący (jeśli nie nastąpi to już pod koniec lat 20. XXI wieku) – czyli przeciętny użytkownik może nie odróżnić AI od człowieka w otwartej rozmowie. Możemy także zobaczyć pierwsze AI zdolne do efektywnej samonauki i autonomicznego przyswajania nowych umiejętności w locie, co rodzi ekscytujące możliwości, ale i wyzwania regulacyjne.

W praktyce AI w 2030 roku będzie posiadać ogromne okna kontekstu (miliony tokenów) i pamięć, co umożliwi przetwarzanie całych bibliotek lub prowadzenie konwersacji z historią liczoną w miesiącach, przy zachowaniu ciągłego kontekstu. Zdolności multimodalne rozwiną się do poziomu niemal bezszwowej integracji: asystent AI w 2030 roku stanie się czymś w rodzaju poligloty i wielozadaniowca – np. tłumacząc w czasie rzeczywistym rozmowę po chińsku, jednocześnie analizując arkusz kalkulacyjny i generując krótki film podsumowujący dla Twoich współpracowników. Generowanie wideo w czasie rzeczywistym może stać się możliwe, co oznacza, że osoba wpisująca „wygeneruj 10-minutowy animowany film 3D o kosmicznej przygodzie” otrzyma spójną produkcję na miarę własnych preferencji. To może zrewolucjonizować rozrywkę i tworzenie treści – prawdziwie demokratyzując produkcję filmów czy gier.

Rozwój sprzętu i efektywności (może także komputery kwantowe lub optyczne dla AI, jeśli się sprawdzą) sprawi, że tak ogromne modele będzie można uruchamiać przy niskim koszcie. Do 2030 r. możemy nawet mieć osobiste modele AI działające lokalnie na urządzeniach (lub przynajmniej w osobistej chmurze), dorównujące dzisiejszym najlepszym rozwiązaniom. Mogłoby to złagodzić obawy związane z prywatnością i centralizacją.

Można także przewidzieć specjalizację systemów AI: obok dużych modeli ogólnych wiele branż będzie posiadać wysoce dostrojone AI (np. AI w diagnostyce medycznej, które zdało już wszystkie egzaminy lekarskie i przeczytało każdą publikację medyczną – taki „Dr. AI”, z którym lekarze rutynowo będą konsultować przypadki). Te wyspecjalizowane AI, zintegrowane z narzędziami, radykalnie skrócą czas potrzebny na realizację złożonych zadań. Przykładowo, na budowie w 2030 roku AI może w czasie rzeczywistym optymalizować harmonogram i zużycie zasobów, lepiej niż jakikolwiek ludzki menedżer.

Transformacja branż do 2030 roku będzie głęboka. W ochronie zdrowia AI może zajmować się triage’em i poradami dla pacjentów na masową skalę (a lekarze zajmować się będą przypadkami złożonymi i zabiegami). W edukacji korepetytorzy AI mogą oferować każdemu uczniowi spersonalizowany program nauczania i wsparcie, znacząco poprawiając wyniki nauczania na świecie – można mieć nadzieję na rzeczywiste zmniejszenie luki edukacyjnej dzięki tanim AI-tutorom na każdym smartfonie. W programowaniu przewiduje się zmianę, w której ludzcy programiści głównie nadzorują AI generujące kod; programowanie może się sprowadzać do definiowania problemu i weryfikacji wyników AI. Do 2030 roku nawet 30% (lub więcej) godzin pracy może być zautomatyzowanych, co oznacza, że wiele ról zostanie mocno wspartych przez AI lub przeniesie się na zadania, których AI jeszcze nie potrafi wykonać. Pojawią się także nowe zawody – trenerzy AI, audytorzy, etycy, inżynierowie promptów, specjaliści od utrzymania AI i podobne role staną się pospolite.

Ekonomicznie wkład generatywnej AI może być liczony w bilionach. McKinsey oszacował w 2023 roku, że generatywna AI mogłaby dodać od 2,6 do 4,4 biliona dolarów rocznie w różnych branżach przy pełnym wykorzystaniu potencjału – do 2030 roku możemy już obserwować znaczną część tego wzrostu PKB dzięki zwiększonej produktywności i nowym produktom. Do 2030 roku mogą powstać całkowicie nowe gałęzie przemysłu: na przykład branże związane z wirtualnymi doświadczeniami (napędzanymi przez generowanie treści AI) czy spersonalizowane produkty tworzone przez AI (moda projektowana przez AI i produkowana na zamówienie).

Z perspektywy konsumenta, codzienne życie w 2030 roku może wymagać ciągłego kontaktu z AI. Każdy mógłby mieć wirtualnego asystenta osobistego zintegrowanego z okularami AR lub słuchawkami – rozmawiasz z nim swobodnie przez cały dzień. Pomaga ci pamiętać o rzeczach, komponować wiadomości, zapewnia rozrywkę, zajmuje się obowiązkami takimi jak zamawianie zakupów, gdy się kończą (perfekcyjnie ucząc się twoich preferencji). Może zmienić się komunikacja: możesz mówić we własnym języku, a twoja AI tłumaczy twoją mowę lub tekst na preferowany język i styl odbiorcy (dzięki czemu maile zawsze będą grzeczne i optymalnie sformułowane pod kątem adresata). Społecznie wykształcą się nowe normy dotyczące AI. Być może akceptowalne stanie się, by AI uczestniczyła w spotkaniach w twoim imieniu (i później cię informowała). Korzystanie z AI w pracy twórczej stanie się powszechne – np. pisarze korzystający ze współautorów AI, co uznane będzie za zwykłe narzędzie pracy (obecna stygmatyzacja zniknie wraz z upowszechnieniem się tego rozwiązania).

Z ciemniejszej strony, do 2030 roku społeczeństwo będzie musiało zmierzyć się z nowymi zagrożeniami generowanymi przez AI: hiperrealistyczne deepfake’i mogą wymusić przewartościowanie zasady „widzieć to wierzyć” – być może standardem stanie się kryptograficzna weryfikacja mediów (by znać źródło obrazu czy filmu). Zagrożenia cyberbezpieczeństwa mogą być zwiększone przez AI (bardziej zaawansowane phishingi, automatyczne ataki hakerskie), prowadząc do powstania przeciwdziałań opartych na AI. Do 2030 roku ramy regulacyjne i prawne będą bardziej dojrzałe: można oczekiwać, że większość krajów będzie miała regulacje dotyczące AI obejmujące zagadnienia uprzedzeń, bezpieczeństwa i transparentności. Możliwe, że pojawią się międzynarodowe umowy dotyczące AI na wzór traktatów o kontroli zbrojeń, zwłaszcza jeśli systemy AI staną się wyjątkowo potężne. Na przykład może być prowadzony monitoring największych procesów treningowych albo wymóg rejestrowania trenowania modelu przekraczającego określone możliwości.

Rynek pracy w 2030 roku prawdopodobnie będzie w fazie adaptacji. Optymistyczna perspektywa to boom produktywności: ludzie pracujący ramię w ramię z AI mogą wytwarzać dobra i usługi dużo taniej i obficiej, potencjalnie podnosząc poziom życia. Pesymistyczny scenariusz zakłada strukturalne bezrobocie w niektórych wykwalifikowanych zawodach. Realistycznie, w niektórych sektorach nastąpi dezorganizacja rynku, ale w innych pojawi się wzrost – historia pokazuje, że technologia tworzy nowe miejsca pracy, nawet jeśli część ich likwiduje. Społeczeństwo prawdopodobnie będzie musiało wdrożyć innowacje, takie jak programy ułatwiające zmianę zawodu, może krótsze tygodnie pracy itp., by zapewnić korzyści wszystkim.

Podsumowując, w 2030 roku generatywna AI będzie wszechobecna, niesamowicie potężna oraz zintegrowana praktycznie ze wszystkimi aspektami życia. Wiele zadań wykonywanych dziś ręcznie zostanie zautomatyzowanych lub przejętych przez współpracę człowieka z AI. Rynek będzie ogromny, a firmy, które nie będą korzystały z AI, będą jak przedsiębiorstwa, które nie przyjęły komputerów ani internetu – praktycznie skazane na zniknięcie. Trudno przecenić potencjalny wpływ; niektórzy nazywają to „kolejną rewolucją przemysłową.” Warto obserwować: czy natrafimy na jakąś barierę lub fundamentalny limit (na przykład, czy powiększanie rozmiaru modeli przestanie przynosić korzyści lub pojawią się ograniczenia sprzętowe). Jeśli nie, postęp do 2030 może nawet przekroczyć najśmielsze prognozy.

Długoterminowo (perspektywa 10 lat, do 2035)

Patrząc w perspektywie 2035 roku, wkraczamy w bardziej spekulacyjne terytorium, ale jeśli obecne wykładnicze trendy się utrzymają, świat w 2035 roku może być niemal nie do poznania z dzisiejszej perspektywy. Najprawdopodobniej do tego czasu pojęcie „generatywnej AI” rozmyje się w szerszym pojęciu AI – większość systemów AI będzie posiadała zdolności generatywne i to rozróżnienie przestanie być istotne. Będziemy po prostu mówić o inteligentnych systemach, które potrafią tworzyć, rozumować i działać.

W perspektywie technologicznej, do 2035 roku niektórzy eksperci przewidują osiągnięcie lub bardzo bliskie osiągnięcie Sztucznej Ogólnej Inteligencji (AGI) – AI o szerokich, ludzkich zdolnościach poznawczych w różnych dziedzinach. Praktycznie mogłoby to oznaczać agentów AI uczących się i przystosowujących do nowych zadań samoistnie, bez potrzeby specyficznego treningu zadaniowego, podobnie jak człowiek nabywa nowe umiejętności. Jeśli uda się osiągnąć AGI (i zapewnić bezpieczeństwo jej funkcjonowania), może to zapoczątkować erę niespotykanej innowacyjności – w praktyce posiadamy niezwykle kompetentne „cyfrowe umysły” wspomagające naukę, inżynierię i rozwiązywanie problemów. Przykładowo, wyobraźmy sobie AI-naukowca, który samodzielnie tworzy hipotezy i prowadzi wirtualne eksperymenty, odkrywając nowe materiały lub lekarstwa w tempie, którego żaden ludzki zespół nie jest w stanie dorównać. Trwa debata – niektórzy sądzą, że AGI będzie możliwa do tego czasu, inni w to wątpią – ale z pewnością systemy 2035 roku będą pod wieloma względami znacznie przewyższać te z 2025.

Nawet jeśli nie zrealizujemy jednej wszechstronnej AGI, będziemy mieli wysoko wyspecjalizowane supereksperckie AI. W 2035 roku AI-lekarz może nie tylko pomagać ludzkiemu lekarzowi, ale wręcz stać się głównym dostawcą opieki dla wielu osób (z nadzorem człowieka według potrzeb). AI-prawnik może prowadzić rutynowe sprawy sądowe (być może drobne spory będą rozstrzygane przez AI w ograniczonym „sądzie AI”). W branżach kreatywnych możemy zobaczyć przeboje muzyczne lub scenariusze filmowe wygenerowane głównie przez AI analizującą, co porusza ludzi (przy pewnej kreatywnej reżyserii człowieka). Granica między kreatywnością człowieka i maszyny będzie bardzo płynna – film w 2035 roku może mieć aktorów-ludzi i reżysera-AI albo odwrotnie.

Gospodarka w 2035 roku może być ogromnie napędzana przez AI. Jedna z ambitnych prognoz Meta zakłada, że generatywna AI może wygenerować 1,4 biliona dolarów przychodów dla firmy do 2035 (skrajnie optymistyczny scenariusz, zakładający otwarcie przez AI całkowicie nowych linii biznesowych). Choć ta liczba jest spekulacyjna, pokazuje przekonanie, że AI może być równie dużym motorem gospodarczym jak internet czy komputery osobiste, jeśli nie większym. Niektóre raporty analityków przewidują, że całkowity globalny rynek AI (szeroko rozumiany) osiągnie od 5 do 15 bilionów dolarów do 2035 roku. Jeśli się to sprawdzi, AI stanie się jedną z największych gałęzi przemysłu – porównywalną z obecnym całym sektorem technologicznym czy ochroną zdrowia. Generatywna AI będzie stanowić dużą część tego rynku i przeniknie wiele produktów i usług.

Rynek pracy i społeczeństwo w 2035 roku: To tu wpływ może być głęboki. W horyzoncie dziesięciu lat wiele zawodów się zmieni. Niektóre profesje mogą niemal zniknąć lub radykalnie się skurczyć (np. tłumacze mogą być rzadkością, bo tłumaczenia obsługują maszyny, a kierowców zastąpią pojazdy autonomiczne itd.). Z drugiej strony, nowe profesje koncentrujące się na jakości ludzkiej – takie jak zawody wymagające empatii, strategicznego nadzoru czy kreatywnej „iskry” – mogą rozkwitać. Możliwe także, że w 2035 roku społeczeństwo będzie musiało się zmierzyć z ideą ogólnego zmniejszenia zapotrzebowania na pracę ludzką. Wzrost produktywności może być tak duży, że możliwe będzie systemowe skrócenie tygodnia pracy (może ludzie będą pracować 20-30 godzin i wytwarzać to samo, co wcześniej 40-50, a resztę wykona AI). Polityka może ewoluować – być może w niektórych krajach zostanie przetestowany jakiś rodzaj uniwersalnego dochodu podstawowego (UBI), by umożliwić dzielenie się majątkiem generowanym przez AI, gdy tradycyjne wzorce zatrudnienia się zmieniają.

Jeśli chodzi o życie codzienne, do 2035 roku każdy z nas może mieć osobistego, „nieustannie obecnego” towarzysza AI, który zna nas bardzo dobrze (i to na wielu urządzeniach/środowiskach – w samochodzie, domu, pracy). Taki AI może wykonywać niezliczone zadania: planować nasz dzień, zamawiać nam rzeczy, których jeszcze nie wiemy, że potrzebujemy, wspierać w realizacji celów osobistych (zdrowotnych, związanych z nauką umiejętności), a nawet zapewniać wsparcie emocjonalne. To rodzi pytania o relacje człowieka z AI. Mogą pojawić się autentyczne przywiązania do bytów AI (niektórzy już dziś czują coś podobnego do obecnych chatbotów). Społeczeństwo będzie dyskutować kwestie etyczne dotyczące „przyjaciół” AI, czy nawet romantycznych partnerów AI – gdy maszyny stają się bardzo podobne do ludzi, rodzi to realne pytania natury filozoficznej i psychologicznej.

Regulacje do 2035 roku będą prawdopodobnie znacznie surowsze. Jeśli dojdzie do poważnych incydentów (np. awaria AI powodująca szkody, nadużycie prowadzące do kryzysu), to one wywołają silniejsze ramy prawne. Możliwe, że powstanie międzynarodowa agencja regulacyjna ds. AI, jak “Międzynarodowa Agencja AI”, zapewniająca globalne standardy (podobnie jak Międzynarodowa Agencja Energii Atomowej dla techniki jądrowej). W optymistycznym scenariuszu kraje będą współpracować, by ograniczyć niebezpieczne zastosowania AI (np. autonomiczną broń). W pesymistycznym – dojdzie do wyścigu zbrojeń AI i napięć geopolitycznych, jeśli AI jednego państwa znacznie przewyższy resztę pod względem militarnym lub gospodarczym. Jednak biorąc pod uwagę współzależność branży technologicznej, bardziej prawdopodobny jest model współpracy, by uniknąć katastrofy.

Wpływ na środowisko: Często podnosi się kwestię zużycia energii przez AI. Jeśli do 2035 roku zapotrzebowanie AI na moc obliczeniową będzie nadal gwałtownie rosło, może to obciążyć sieci energetyczne lub mieć konsekwencje klimatyczne, o ile nie zostanie zrekompensowane zieloną energią lub bardziej wydajnymi układami scalonymi. Jednak AI może też pomagać w rozwiązaniach proklimatycznych (optymalizacja energii, innowacje technologii ekologicznych). Do 2035 roku zobaczymy, czy AI stała się pomocnikiem czy przeszkodą dla zrównoważonego rozwoju.

Ewolucja człowieka z AI: Pojawiają się spekulacje, że do 2035 roku możemy zacząć bardziej bezpośrednio integrować AI z samymi sobą – np. interfejsy mózg-komputer (jak koncepcja Neuralink Elona Muska) mogłyby pozwolić nam „myśleć” zapytania do AI i otrzymywać odpowiedzi jako myśli wewnętrzne, zacierając granicę między ludzkim a maszynowym poznaniem. Choć brzmi to jak science fiction przy 10-letniej perspektywie, już dziś istnieją prototypy, a dekada może przynieść zaawansowaną neurotechnologię, jeśli nastąpią przełomy. Może to być jedna z dróg, by ludzie mogli nadążyć za AI – poprzez pewnego rodzaju połączenie się z nią.

Podsumowując, rok 2035 może oznaczać wkraczanie systemów AI w każdy aspekt ludzkiej egzystencji, od sposobu w jaki pracujemy i komunikujemy się, przez odkrycia i zarządzanie społeczeństwem. Ta transformacja jest często porównywana do rewolucji przemysłowej lub pojawienia się elektryczności – ale potencjalnie szybsza i znacznie bardziej wszechogarniająca. To ekscytujące, ale i budzi obawy. Spodziewamy się świata, w którym produktywność osiągnie niespotykane dotąd wyżyny, wiele chorób zostanie wyleczonych lub lepiej kontrolowanych dzięki badaniom AI, codzienne uciążliwości zostaną zminimalizowane, a kreatywność eksploduje dzięki współpracy człowieka z AI. Z drugiej strony musimy radzić sobie z dylematami etycznymi, zakłóceniami gospodarczymi oraz zadbać, by AI była zgodna z wartościami człowieka, by ta przyszłość była taka, w jakiej chcemy żyć. Następne dziesięć lat będzie kluczowe, by wyznaczyć ten kierunek.

Jeśli obecny trend się utrzyma, generatywna AI i jej następne technologie zmierzają ku temu, by do 2035 roku fundamentalnie przedefiniować to, jak żyjemy i pracujemy – to prawdziwie przełomowa zmiana technologiczna na skalę jednego pokolenia. Organizacje, osoby indywidualne oraz decydenci, którzy zrozumieją i proaktywnie dostosują się do tej zmiany, będą mieli najlepszą pozycję, by odnieść sukces w nowej erze. Stojąc w 2025 roku na progu tych możliwości, jedno jest pewne: rewolucja AI dopiero się zaczyna i jej historia będzie jednym z kluczowych narracji następnej dekady.

Źródła: Projekcje rynku generatywnej AI; Przykłady wdrożeń w branży; Najważniejsze osiągnięcia platform AI; Innowacje modelowe (GPT-4.5, Llama 4); Analizy etyczne i regulacyjne; Prognozy trendów na przyszłość.